VATT: Transformers for Multimodal Self-Supervised Learning from Raw Video, Audio and Text

We present a framework for learning multimodal representations from unlabeled data using convolution-free Transformer architectures. Specifically, our Video-Audio-Text Transformer (VATT) takes raw signals as inputs and extracts multimodal representations t

arxiv.org

1. Abstract

VATT는 트랜스포머 아키텍처를 사용해, 레이블이 없는 데이터에서 멀티모달 표현을 학습하는 프레임워크이다. Multimodal contrastive loss들을 사용하여 end-to-end로 훈련했다. 세 가지 modality 간에 가중치를 공유하여, modality-agnostic한 single-backbone transformer을 연구

컨볼루션이 필요 없는 VATT가 downstream task에서 SOTA를 달성한 ConvNet 기반 아키텍처보다 성능이 뛰어나다. VATT의 ViT는 supervised pre-training을 거치지 않으면서도 Kinetics-400에서 82.1%, Kinetics-600에서 83.6%, Kinetics-700에서 72.7%, Moments in Time에서 41.1%의 정확도를 달성하며 SOTA를 달성했다. 이미지 분류로 전환하면 이미지넷에서 78.7%의 상위 1퍼센트의 정확도 달성했다. 동일한 transformer를 처음부터 훈련하면 64.7%로, 비디오와 이미지 사이의 도메인 격차에도 불구하고 모델의 일반화가 가능하다. VATT의 오디오 transformer는 supervised pre-training 없이 AudioSet에서 39.4%의 mAP를 달성하여 파형 기반 오디오 이벤트 인식 분야에서 SOTA를 달성했다.

2. Focus on

서로 다른 feature vector를 가지는 multi-modal의 specific semantic을 유지하며 heterogeneity gap(멀티 모달의 이질성의 차이)을 줄이는 것

(1) Method

Representation learning을 통해 비슷한 sematic을 가지는 multi-modal data의 heterogeneous feature를 비슷한 feature vector로 표현

(2) Representation learning

특정 task에 따라 새로운 representation에 해당하는 새로운 feature (input feature)를 출력한다.

이러한 representation을 반영하는 feature vector를 추출하게 학습한다.

Modality-specific representation learning

멀티모달 관련 representation learning은 특정 모달에서 아래와 같이 이뤄졌다.

각 모달은 다른 방식을 사용하기 때문에 추출되는 feature vector가 각기 다르다.

(3) 각 모달의 feature vector를 비교하는 방법 (Joint representation)

Strategy of integrating different types of features to improve the performance

다른 타입의 피쳐를 통합하는 방법으로, 특정 모달들은 개별 뉴런 네트워크로 인코딩 된 후 공유된 feature 공간에 매핑

각 vector를 학습하는 방식

1) Concatenate multi-modal features directly

- 각각의 modality 에 대해서 학습 후 modal의 feature들을 concatenate한다.

(구체적인 벡터를 추가해주는 hidden layer를 병합)

problem. 각 modal에서 semantic이 결합되어, semantic이 제대로 반영되지 못하는 문제 발생

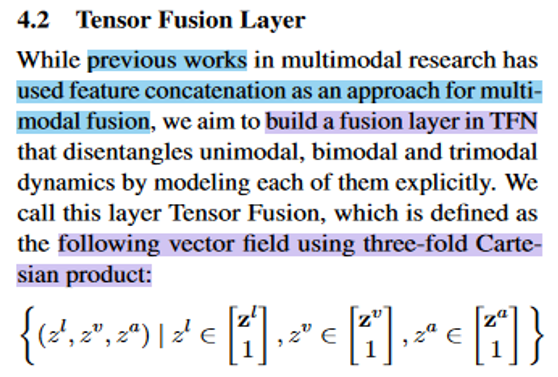

2) Tensor Fusion Network

- 모든 modality-specific feature vector를 외적을 통해 수행된다.

- TFN(Tensor Fusion Network) 에서 tensor fusion layer는 modality- embedding 에서 3-fold Cartesian product(데카르트 곱)을 사용하여 single-modal, bi-modal , tri-modal의 상호 작용을 모델링

problem. 외적 계산의 연산량 많이 든다.

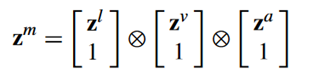

3) Multimodal Compact Bilinear Pooling (MCB)

[ Multimodal compact bilinear pooling for visual question answering and visual grounding – 2016 ]

- Count Sketch projection function 을 통해 차원을 축소 후 외적하고 연산량을 줄임

problem . 차원을 축소하면서 일부 modal에서 데이터 일부 손실 문제로 down stream 성능에 영향

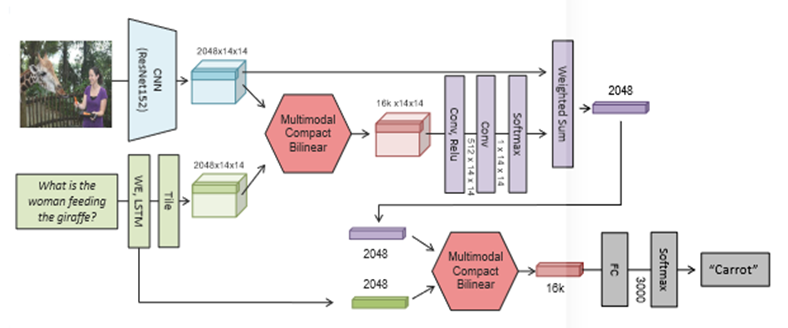

4) Statistical Regularization

- 누락 데이터 처리에 사용되는 트레이닝 트릭으로 Cross-modal CNN을 정규화를 통해 modality agnostic한 representation 방법을 제시

- Modality 간의 분포의 유사성을 가질 수 있도록 하는 hidden layer의 활성 함수로 statistical regularization을 이용

- Modality-invariant(모달의 불변성)이 증대

5) VATT

- VATT 이전 모델들은 task를 위해 연산량을 효과적으로 줄이고 원하는 scene을 추출해야 하는데, 기존에는 모달별로 backbone을 다르게 진행 후 feature space에 투영하여 연산량 증가문제와 데이터 통합문제를 야기했다.

- 이에 VATT에서는 연산량을 효과적으로 줄이고 raw 데이터에 대해 modality agnostic하게 하여 성능 향상시켰다.

Previous study : MMV: Multi-Modal Versatile Networks

- Video, audio, text의 input에 각각 feature extractor가 있다.

- 각 모달리티별로 feature를 추출하고 contrastive learning을 진행하는데, 오디오와 비디오는 CNN, 텍스트는 트랜스포머를 backbone으로 사용했다.

- 각 모달리티에 적합한 아키텍쳐를 갖추고 있다.

problem . Data integrated와 computing cost 에 대한 문제를 가짐

3. Architecture

(1) Overall

Technique :

- Tokenization

- Positional Encoding

- DropToken

- TR Backbone

- Common Space Projection

- Multi-modal Contrastive Learning

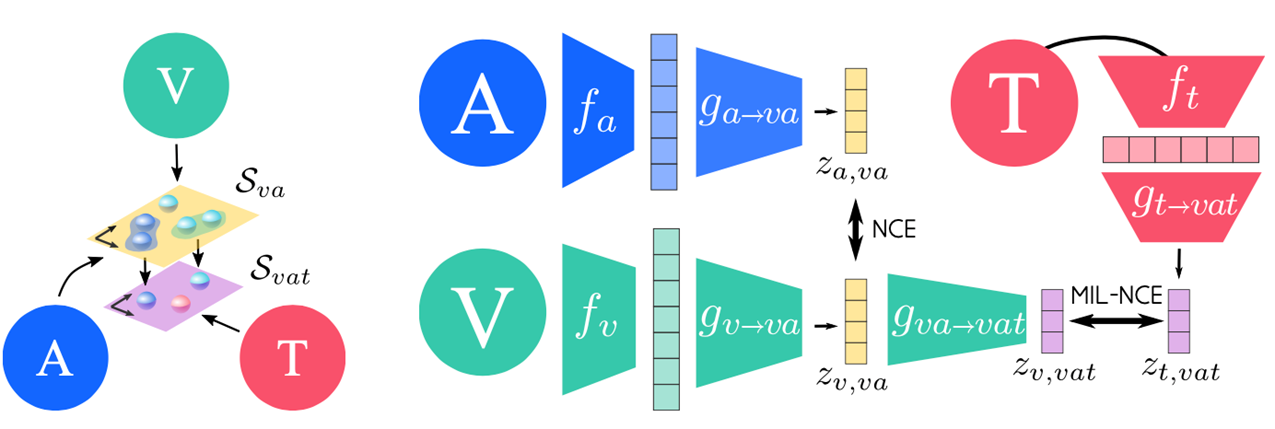

Raw 데이터인 video, audio, text를 트랜스포머의 인풋으로 넣기 위해 patch, tokenization 과정을 진행해서 sequence하게 만들어준다. 그 후 positional encoding을 진행하여 위치 정보를 더해준다. 이 과정에서 Droptoken이라는 간단한 과정을 추가하여 연산량을 줄인다. 세 인풋은 다른 모달리티이므로 같은 feature space로 보내어 대조 학습을 진행한다. 이렇게 학습된 VATT에서는 transformer encoder를 1개씩 각각 모달리티별로 아키텍쳐를 사용하는 modality-specific과 transformer encoder 1개를 사용하여, 모달리티에 상관없이 아키텍쳐를 쓸 수 있는 modality-agnostic을 실현했다.

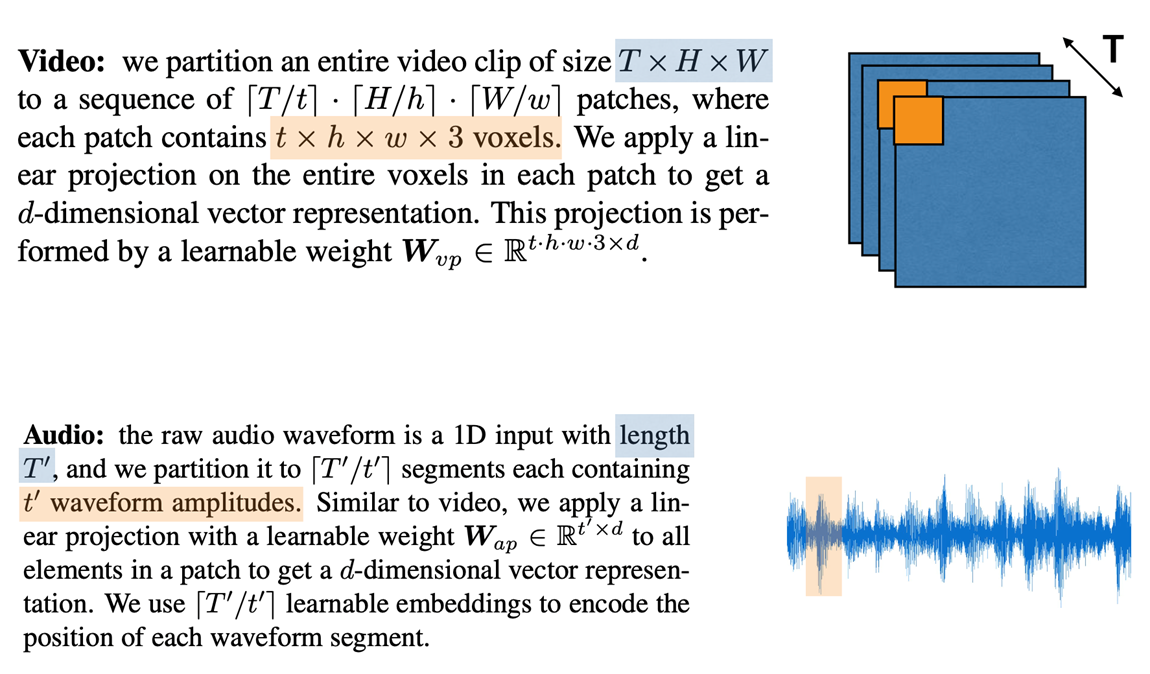

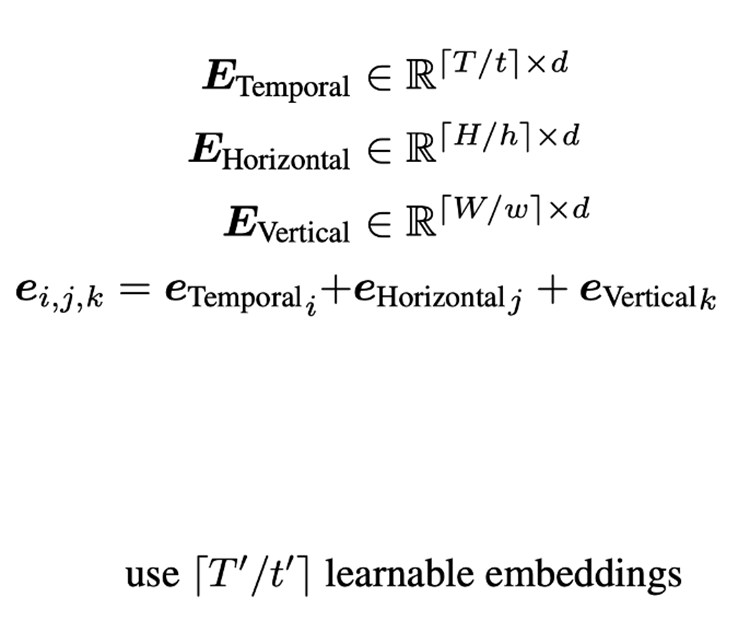

(2) Tokenization + Positional Encoding (Video, Audio)

비디오의 클립사이즈를 파랑색 사각형처럼 T, H, W(time, height, width)라고 하고, 비디오 패치를 주황색 사각형처럼 t,h,w라고 하면 클립을 patch로 나누어 seqence로 분할한다. 이후 patch마다 transformer의 d차원으로 linear-mapping을 진행한다. 각각의 patch에 대한 PE를 구하고, temporal, horizontal, vertical 3개 축에 PE를 learnable하게 만든다.

오디오는 그림과 같은 waveform에서 길이 T’을 진폭인 t’로 segment를 나누어 patch sequence로 분할한 후 비디오에서의 포지셔널 인코딩 과정을 진행한다.

(3) Positional Encoding (text)

- 기존 position encoding 대신에 relative positional encoding 사용

- Relative positional encoding :

Attention score를 구하는 과정에서 key, query의 상대적인 거리를 더해주는 방법

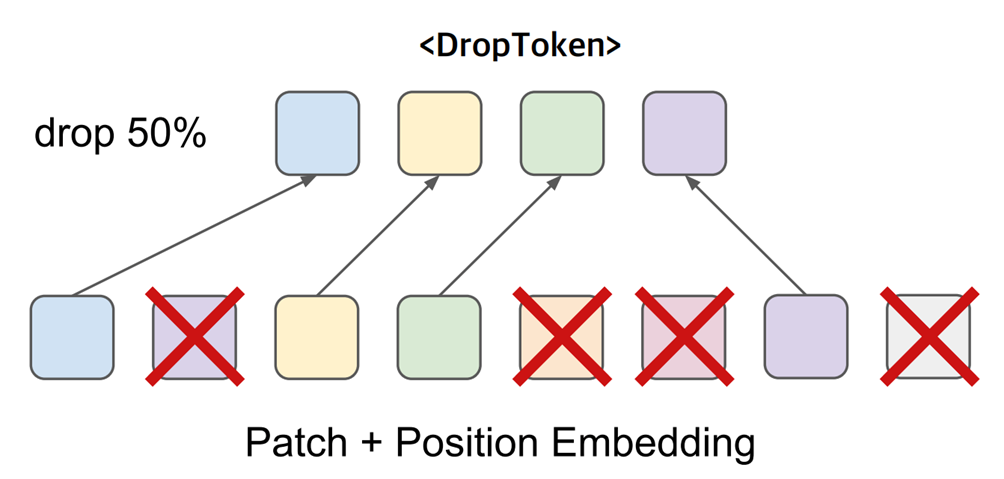

(4) Droptoken

각 모달리티마다 linear mapping과 positional encoding을 하고 난 후, 비디오와 오디오의 patch에 대해 droptoken을 진행한다. 비디오는 시간축, 해상도 오디오는 sample rate가 높아 patch 수가 많다. Transformer의 seqence가 길어지므로 연산량이 seqence의 제곱으로 많아져, 이를 해결하기 위해 두 patch를 합치고 random drop한다. 비디오와 오디오는 중복되는 구간이 있어 random drop을 해도 성능에 크게 영향을 받지 않는다. 간단한 방법을 통해, train 과정에서 효과적으로 연산량을 줄였다.

(5) Common Space Projection

앞선 과정에서 각 모달리티마다 피쳐를 추출했다. 모달리티가 다르면 sementic layer가 달라 비교를 할 수 없기 때문에, 서로 다른 모달리티를 비교하기 위해서 같은 feature space로 보내 비교한다. 비디오와 오디오의 경우, 연속적인 특성이 있어 의미가 떨어져도 representation이 빽빽해, 같은 차원으로 간주한다. 그러나 text는 input 자체가 symbolic하므로 token마다 representation이 떨어져 있어 low demension으로 간주한다.

Common feature space에 같은 512차원인 비디오, 오디오를 linear mapping을 하고 , loss function인 NCE loss를 줄여가며 대조학습(https://data-newbie.tistory.com/879)을 진행한다. Video-audio feature를 text와도 비교하기 위해 차원을 1/2 축소하여 linear mapping을 진행한다. 이후 video feature와 text feature의 MIL-loss를 줄여가며 대조학습을 진행한다. 이 과정을 통해 video-audio feature와 video-text feature 의 cosine similarity를 비교할 수 있고, 이를 통해 모달리티마다 의미적 단위(the granularity of different modalities)의 레벨이 달라도 비교할 수 있다.

(5) Common Space Projection

Self-supervised learning에 contrastive learning을 사용

- Vision & Audio : Noise-Contrastive Estimation (NCE) loss

- Vision & Text : Multiple-Instance-Learning-NCE (MIL-NCE) loss

1) NCE Loss : Vision & Audio

여기서 NCE loss는 기존 대조 학습에서 자주 쓰이는 loss로, 비디오, 오디오 모달리티간 스트림에서 일치하는 부분을 positive pair, 아닌 부분을 모두 negative pair라고 정의하고, 두 모달리티의 positive pair와 negative pair의 유사도를 코사인 유사도로 구한 loss이다.

분자에는 positive pair, 분모에는 모든 pair가 들어간다. 여기에 –log를 취해 분자가 최대 분모가 최소가 되도록 학습을 시켜 loss를 최적화시킨다.

2) MIL-NCE(Multiple-Instance-Learning-NCE) loss : Vision & Text

앞서 설명한 NCE Loss는 positive pair 한 쌍에 대해 loss를 줄여가는데, 비디오-텍스트 영역에서는 여러 개의 positive pair에 대해 MIL-Loss를 이용해 train을 진행한다. 텍스트는 비디오에 대한 나레이션을 바탕으로 만들기 때문에, noise가 존재하고, sync(동조)가 맞지 않을 수 있다.

예시처럼, 7분 34초라는 시간대에 그림에 있는 sander를 나타내는 정확한 나레이션이 나올 확률이 낮기 때문에

7분 34초를 중심으로, 앞 뒤 시간에 있는 text에서 sander를 나타내는 것을 positive sample이라고 가정하고 MIL-NCE loss를 학습한다.

이렇게 같은 feature common space에서 대조 학습을 통해 각 모달리티의 가중치를 공유하게 된다.

4. Experiment

[논문리뷰] VATT: Transformers for Multimodal Self-Supervised Learning from Raw Video, Audio and Text

논문: https://arxiv.org/pdf/2104.11178.pdf IDEA - 라벨링되지 않은 데이터를 사용하여 multimodal representation을 학습하는 프레임워크 - VATT는 raw signal들을 인풋으로 받아 다운스트림 태스크에 적용할 수 있는

littlefoxdiary.tistory.com

(1) Experimental Setup

1) Pre-train

Internet Videos

- 120만 개 영상

- 각각은 오디오, 내레이션 스크립트(자동 음성인식기로 전사)가 있는 여러 개의 클립들로 구성

- 1억 36만 쌍의 {비디오-오디오-텍스트}가 존재

AudioSet

- 유튜브에 있는 200만 개의 영상에서 샘플링한 10초가량의 오디오 클립들로 구성

- 다양한 오디오 이벤트와 그에 대한 영상이 존재하지만, 전사(딕테이션된) 텍스트는 부재

Dataset에 대한 labeling 작업은 이루어지지 않았다. AudioSet은 텍스트가 없기 때문에 텍스트 인풋을 0으로 채웠고, 여기서 나온 샘플에 대해서는 MIL-NCE loss 사용하지 않았다.

(2) Downstream Tasks

Video action recognition

- UCF101 (101개 클래스, 13,320개 비디오)

- HMDB51 (51개 클래스, 6,766개 비디오)

→ 이 두 데이터셋은 모델 사이즈에 비해 데이터가 적기 때문에 vision 백본을 freeze하고 linear classifier만 학습

- Kinetics-400 (400개 클래스, 234,584개 비디오)

- Kinetics-600 (600개 클래스, 366,016개 비디오)

- Moments in Time (339개 클래스, 791,297개 비디오)

→ vision 백본으로 모델을 initialize한 후 해당 데이터들에 대해 fine-tuning을 진행함

Audio event classification

- ESC50 (50개 클래스, 2000개 오디오 클립)

→ audio Transformer을 freeze하고 linear classifier만 학습

- AudioSet (527개 클래스, 200만 개가량의 오디오 클립)

→ audio Transformer로 초기화한 후 fine-tuning 진행

Zero-shot video retrieval

- YouCook2 (3100개 영상-텍스트 쌍)

- MSR-VTT (1000개 영상-텍스트 쌍)

이 실험은 영상-텍스트 간의 common space representation이 잘 학습되었는지 평가하기 위해 진행한 것

형가 척도로는 Recall at 10 (R@10)을 측정함

Image classification

- 영상과 이미지 사이에는 도메인 차이가 존재하지만, VATT 사전학습으로 얻은 vision Transformer을 이미지 도메인에 적용했다.

- ImageNet에 바로 실험을 해보았고, 아키텍처나 tokenization 파이프라인에 수정을 가하지 않았다.

(3) Experimental Setup

1) Input

- 비디오 :

사전학습 동안에는 두 개의 사전학습 데이터로부터 10 fps로 32 프레임을 샘플링. 이 프레임들에 대해 랜덤하게 시간적으로는 일관성 있도록 공간상에 크롭을 진행함 (relative area in [0.08, 1] / aspect ration [0.5, 2]) 이후 크롭된 영상은 224x224로 리사이즈하고, 이후 horizontal flip과 color augmentation 적용 / RGB 값은 [0,1] 사이에 있도록 값을 clipping하고, 인풋이 [-1, 1]에 있도록 normalize / 패치 사이즈는 4x16x16 사용

- 오디오 :

비디오 프레임과 싱크가 맞도록 48kHz로 샘플링. 인풋이 [-1, 1]에 있도록 normalize / 패치 사이즈 128 사용

- 텍스트 :

vocabulary 사이즈는 2^16 (word2vec과 동일 ㅎㄷㄷ...). 시퀀스는 최대 16개 단어 포함하도록 함

사전학습 과정에서는 DropToken 50% 적용.

비디오 fine-tuning과 평가에 있어서는 32 frame + temporal stride 2로 25 fps로 샘플링 (2.56초) , 320x320 크롭

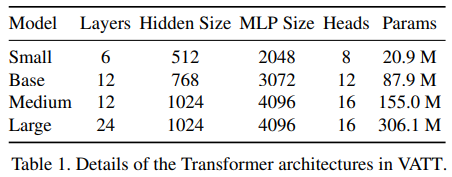

2) Network setup in VATT

- VATT-MA : modality agnostic 버전 - Medium 사이즈 사용

- Modality specific한 실험에서는 텍스트는 Small , 오디오는 Base 사이즈 사용

→ 이 설정 값에 따라 비디오-오디오-텍스트 백본에 대해 3가지 변형 모델 확보

→ Base-Base-Small (BBS), Medium-Base-Small (MBS), Large-Base-Small (LBS)

3) Projection heads and contrastive losses

- d_va(비디오-오디오 공간) = 512 / d_vt(비디오-텍스트 공간) = 256으로 설정

- NCE와 MIL-NCE 계산 전에 벡터를 normalize하고 temperature=0.07, lambda=1 사용

4) Pre-training setup

- Adam 옵티마이저를 사용해 VATT를 from-scratch로 사전학습

- 초기 learning rate = 1e-4 , 10k 스텝 동안 warmup 진행, 총 500k step동안 학습(배치사이즈=2048)

- quarter-period cosine schedule을 사용해 learning rate를 1e-4에서 5e-5까지 떨어뜨림

- 추가 탐색 실험에서는 배치 사이즈 512 사용

- TensorFlow v2.4에서 모델을 구현하였고, TPUv3 256개에서 3일간 학습

(4) Results

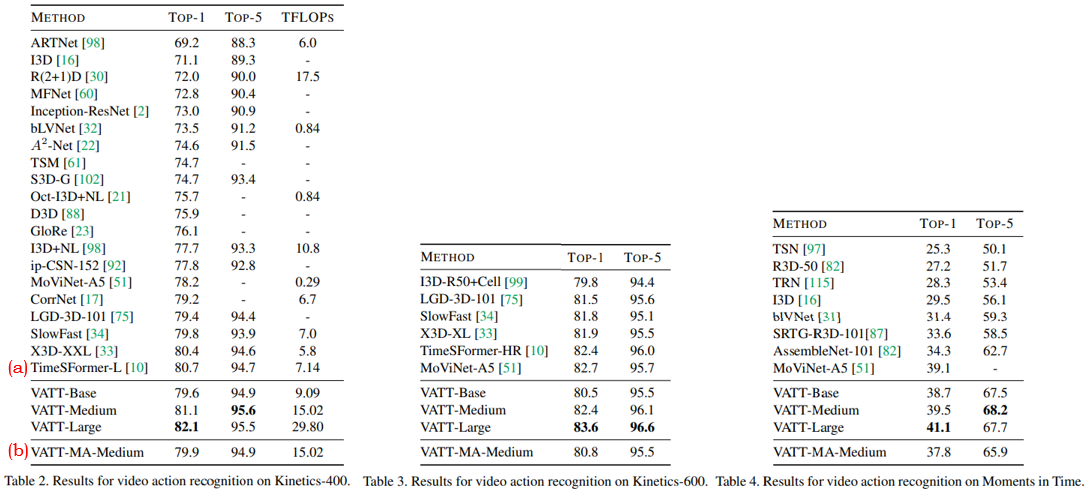

1) Fine-tuning for video action recognition

- 모든 데이터셋에 대해 TimeSFormer을 포함한 기존 연구보다 높은 정확도를 얻음

- (a) 이 중 TimeSFormer은 지도학습기반 사전학습을 한 ViT로 초기화한 모델에 대해 fine-tuning을 진행한 모델임

- VATT는 사전학습에 있어 사람이 만든 라벨이 전혀 필요하지 않았음에도 좋은 모델을 만들었다는 점에서 유의미함

- VATT는 multimodal 비디오에 대해 self-supervision을 사용한 첫 번째 사례이며, from-scratch로 Transformer 모델을 학습한 것에 비해 획기적인 성능 향상을 보였다는 점에서 논문에서 제안한 사전학습 기법이 유의미하다.

- (b) 뿐만 아니라, VATT-MA-Medium 결과를 볼 때, modality에 국한되지 않고 비디오-오디오-텍스트 간에 백본을 공유하는 모델이 modality-specific 한 VATT-Base에 비견할만한 성능을 보임. 즉, 데이터 modality를 통합하여 단일 트랜스포머 백본을 사용할 수 있는 가능성을 보인 실험 결과로 해석.

2) Fine-tuning for audio event classification

Multi-label 오디오 이벤트 분류 데이터셋인 AudioSet에 평가하고, mAP와 AUC, d-prime 점수를 계산

- (a) 현존하는 CNN 기반의 모델 대비 모든 metric에 대해 성능이 우월함

- (b) modality agnostic 한 백본의 성능이 modality 특수성을 가지는 모델과 거의 동등한 성능을 보임

- VATT는 오디오 이벤트 분류 태스크에서 트랜스포머 모델로 CNN 기반 모델을 이긴 첫 번째 사례.

- 특히, 수작업으로 생성한 feature가 아닌 raw waveform을 인풋으로 사용한다는 점에 주목할만함.

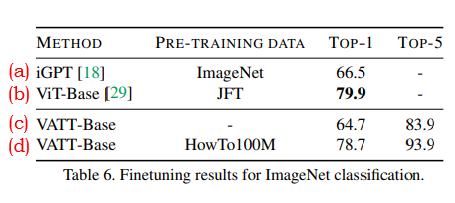

3) Fine-tuning for image classification

이 실험은 multimodal 영상 도메인에서 학습한 지식을 이미지 도메인에 tranfer 할 수 있음을 보여준다.

결과표는 백본 구조를 수정하지 않은 채 VATT를 ImageNet에 fine-tuning 한 성능을 보여준다.

다만, VATT는 본래 voxel-to-patch 레이어가 있기 때문에, 이미지를 time에 맞게 4번 복사해 넣어주었다.

- (c)와 (d)를 볼 때, 영상 도메인에 대한 사전학습으로도 from-scratch 대비 크게 성능이 향상되었다

- 심지어 대량의 이미지 데이터에 대해 사전학습한 것(b)에 비견할만한 성능을 보였다.

4) Zero-shot retrieval

VATT-MBS 모델에 비디오와 텍스트 쌍을 인풋으로 넣고, S_vt 공간상에서 representation을 추출하였다.

이후 YouCook2와 MSR-VTT 데이터에 있는 각각의 비디오-텍스트 쌍 사이의 유사도를 계산하였다.

텍스트 쿼리가 주어질 때 영상과 쿼리의 유사도를 기반으로 영상의 랭킹을 매겼고, top-10으로 뽑힌 영상에 정답 영상이 있는지를 체크한 R@10 점수를 계산하였다. 또한, 정답 영상의 rank에 대한 중간값을 매겨보았다. 이러한 실험 결과를 기존의 두 가지 베이스라인 결과와 비교해 보았다.

- (b)~(c) zero-shot retrieval 성능은 배치사이즈와 epoch 수의 영향을 크게 받는다. (MMV에서도 밝혀진 연구 결과) 하지만 VATT(c)는 에폭 수와 배치 사이즈가 MMV 모델(b)의 절반임에도 불구하고, 그에 비견할만한 성능을 보였다.

- 더 큰 배치사이즈(8192)를 사용해서 더 오랜 에폭 동안(6 에폭) 학습하자, VATT의 성능은 YouCook2에서MIL-NCE와 완전히 성능을 얻었고, MSRVTT에서 R@10 29.2 / MedR 42를 얻었다.

- 전사 텍스트가 noisy 데이터여서 그런지, VATT와 같이 정교한 언어 모델은 성능이 떨어지는 것을 관측했다.

- 간단한 linear projection만으로 모델이 잘 작동하였기 때문에, 향후 더 높은 품질의 텍스트 데이터를 탐구해볼 만할 것으로 예상한다.

5) Linear Evaluation

VATT의 백본 웨이트를 고정한 상태에서도 다른 데이터들에 대해 일반화를 잘하는지 테스트해 보았다.

이 실험은 비디오와 오디오 modality에 초점을 맞추었고, 백본을 freeze한 상태에서 선형 분류기만 fine-tuning한다.

또한, Low-rank classifier에 더해서 SVM 결과를 테스트해보았다.

그 결과 VATT는 MMV에서 사용한 최고 성능의 CNN기반 모델보다 좋은 성능을 내지 못했지만, 다른 베이스라인 모델과는 비견할 만한 성능을 보였다. 이 결과로 미루어볼 때, VATT의 백본은 선형적으로 분리 가능한 feature을 덜 학습한 것으로 보인다. 특히 contrastive estimation head가 비선형적인 projection을 사용할 때 이런 결과는 확연했다.

6) Feature visualization

- 영상 인풋에 대한 representation이 클래스에 따라 잘 분리되었다.

Kinetics-400 데이터에 대해 fine-tuning된 modality-specific 모델과 modality-agnostic 모델을 사용하여 그 결과로 나오는 feature representation을 t-SNE를 사용해 시각화해 보았다. 결과 비교를 위해 vision Transformer을 Kinetics-400 데이터에 대해 from-scratch로 학습한 모델의 시각화 결과도 보았다.

- (b)~(c) : Fine-tuning된 VATT 모델이 from scratch로 학습한 모델보다 더 좋은 분리 형태를 보인다

- 영상 모드에 최적화된 모델(b)과 modality에 무관하게 학습된 모델(c)의 representation 차이에 큰 차이가 없다

- modality-agnostic 모델은 영상과 텍스트의 신호를 비슷한 concept로 매핑한다.

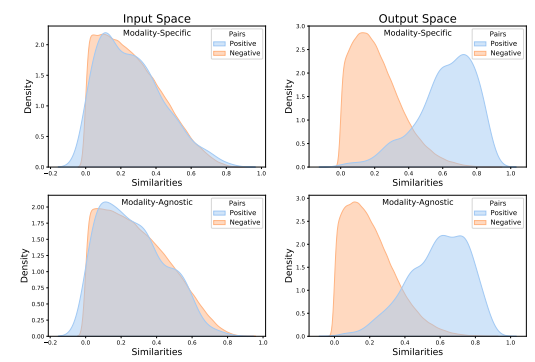

더불어 VATT 백본을 fine-tuning 없이 조사해보았다.

YouCook2의 영상 중 1000개의 영상을 랜덤 추출하고, VATT 모델이 추출한 representation 두 가지를 저장해보았다.

(1) tokenization layer을 거친 직후의 feature (Transformer의 인풋 스페이스)

(2) common space projection 이후의 feature (아웃풋 스페이스) -> 이 결과로 loss를 계산하게 됨

- modality agnostic 세팅에서는 modality specific한 모델에 비해 representation이 더 섞여 있다

즉, modality agnostic 모델은 다른 modality에서 온 다른 신호(symbol)를 같은 개념(concept)을 묘사하는 것으로 받아들인다는 것이다. 이 결과는 NLP에서 하나의 언어 모델이 여러 개의 언어를 처리할 수 있는 것과 같은 현상으로 해석된다.

VATT가 알맞게 짝지어진 <비디오-텍스트> 쌍과 랜덤하게 짝지어진 쌍을 잘 구분하는지 보기 위해 모든 가능한 조합에 대해 pairwise 유사도를 계산하고, Kernel Density Estimation(KDE)을 통해 positive vs negative pair 간의 유사도 분포를 시각화했다.

(5) Ablation study

1) Inputs

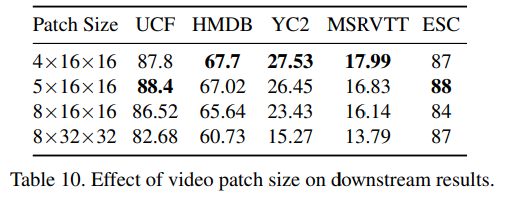

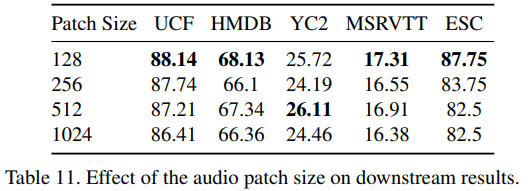

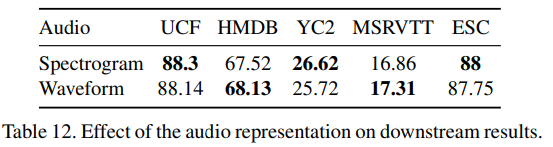

VATT는 raw multimodal signal을 인풋으로 받기 때문에 인풋 크기와 패치가 성능에 큰 영향을 줄 수 있다.

이 부분을 조사하기 위해 먼저 비디오에서 샘플링한 프레임의 개수와 크롭 사이즈를 변경하되, 패치 크기는 5x16x16으로 유지해 실험해보았다. 그 결과, 크롭 사이즈를 작게 하거나 프레임 수를 크게 하면 영상 관련 태스크 성능 저하를 가져왔으나, 오디오 분류에는 영향이 크게 없는 것으로 나타났다.

위 실험에서 가장 좋게 나온 프레임 크기를 유지한 채, 비디오 패치 크기를 변경해보았다. 시간, 혹은 공간 차원에 있어 4x16x16을 넘어가는 패치를 사용하는 것은 성능에 있어 좋지 않았다. 이 패치 크기보다 작게 할 경우, 실험 시간이 너무 오래 걸리기 때문에 그런 실험은 하지 않았다.

마지막으로 오디오 패치 크기가 성능에 미치는 영향에 대해 실험하였다. 그 결과, 패치 크기는 128을 사용하는 것이 가장 좋았다.

또한 raw waveform 대신 handcrafted spectogram을 인풋으로 사용하는 실험을 진행해보았다. (MEL spectrogram with 80 bins, the STFT length of 42 ms, and the STFT step of 21 -> 이는 MMV 모델 셋팅을 참고한 결과) 그 결과, Spectogram을 사용한다고 해서 성능이 유의미하게 향상되지는 않았다. 이 결과로 미루어볼 때, VATT는 raw audio로부터 semantic representation을 학습할 능력이 있는 것으로 보인다.

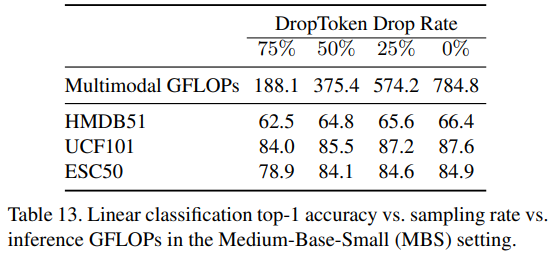

2) DropToken

DropToken에 사용하는 drop rate를 바꾸어가며 실험을 진행해보았다. 50%의 토큰을 drop하는 결과는, 이와 같이 라지 스케일로 사전학습을 진행함에 있어 GFLOPs와 성능 사이의 trade-off 측면에서 적정 수준인 것을 알 수 있었다.

또한, 50% DropToken을 적용한 VATT의 마지막 체크포인트를 사용해 Kinetics-400 데이터에 대해 각기 다른 DropToken 비율을 사용해 실험을 진행해 보았다. 이 실험은 높은 해상도를 가지는 인풋에 DropToken을 적용한 것과, 낮은 해상도를 가지지만 DropToken을 하지 않은 것에 대해 fine-tuning 과정에서 어떤 차이가 있는지 보기 위함이다. 일반적으로 학습 과정에서 계산 비용을 줄이기 위해서는 후자의 방법, 즉 저해상도의 인풋을 사용하는 방법을 선택한다. 하지만 이 실험 결과는 고해상도의 인풋을 그대로 사용하면서 DropToken을 사용하는 전자의 방법이 성능과 학습 비용 측면에서 비견할만하거나 좋다는 것을 제시한다.

5. Conclusion

트랜스포머 아키텍처를 사용해 self-supervised multimodal representation learning을 수행하는 프레임워크를 제안했다.

Attention만을 사용한 모델을 multimodal 영상 인풋에 대해 학습을 시켰고, 이러한 large-scale의 self-supervised learning 기반 pre-train 방법이 트랜스포머 기반의 모델을 학습함에 있어 데이터 확보에 대한 부담을 덜어줄 수 있다는 가능성을 제시했다.

DropToken 방식을 사용해 트랜스포머가 가지는 quadratic training complexity 문제를 완화했다. Video action recognition와 audio event classification에 있어 SOTA 성능을 달성하였고, 이미지 분류와 video retrieval에서도 기존 연구에 비견할만한 성능을 보여 SSL을 통해 학습한 representation을 각기 다른 modality에 대해 일반화, 전이 가능함을 보였다.

향후 학습에 있어 data augmentation 기법을 좀 더 탐색하고, modality-agnostic한 backbone에 대해 모델을 적절하게 regularize할 수 있는 방법을 연구할 계획이다.