https://arxiv.org/abs/2205.01917

CoCa: Contrastive Captioners are Image-Text Foundation Models

Exploring large-scale pretrained foundation models is of significant interest in computer vision because these models can be quickly transferred to many downstream tasks. This paper presents Contrastive Captioner (CoCa), a minimalist design to pretrain an

arxiv.org

Intro

문제

- Captioning과 Contrastive Learning을 하나의 모델에서 효율적으로 결합하기 기술적으로 어렵다.

- Captioning : 이미지에서 세부적이고 정밀한 텍스트를 생성. 문맥과 정확성이 중요.

- Contrastive Learning : 이미지와 텍스트의 글로벌 표현을 학습해 유사성을 높이는 작업. 단순한 매핑과 추상적 표현이 중요.

- 이는 둘의 손실 함수(Contrastive Loss, Captioning Loss)가 서로 충돌할 가능성이 있기 때문에 이 둘을 동시에 학습하기 어려웠음

아이디어

- Contrastive Encoder + Generative Decoder

- Contrastive Encoder에서 학습된 글로벌 표현이 Generative Decoder에서도 활용되어 두 작업 간 정보를 공유하기 때문에 상호 보완적으로 작동이 가능하다.

- 각 손실 함수의 균형을 조절하여 두 가지 작업을 조화롭게 최적화

- 학습 초기에는 Contrastive Loss를 우선적으로 학습하여 강력한 글로벌 표현을 생성

- 후반부에는 Captioning Loss를 강화하여 텍스트 생성 성능을 최적화

Method

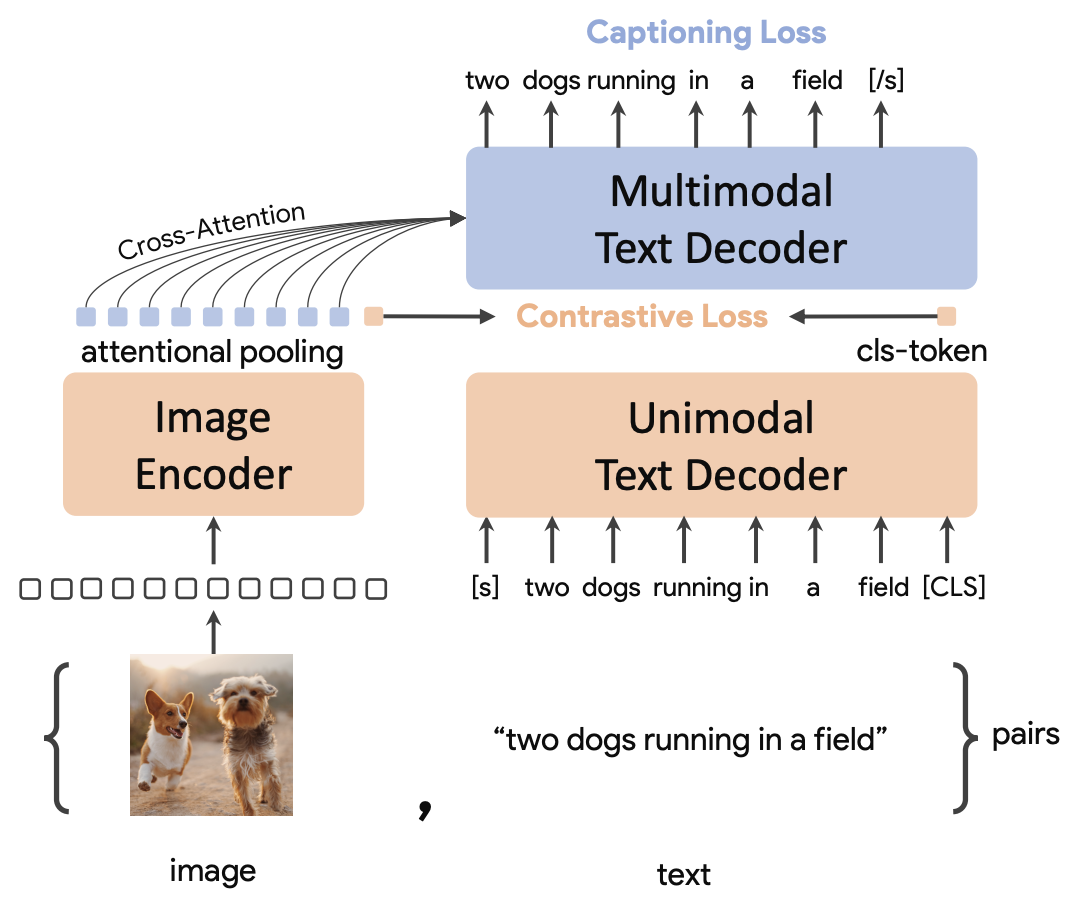

CoCa 모델 아키텍처는 크게 3개의 컴포넌트로 이루어져 있다.

- Image Encoder

- Unimodal Text Decoder

- Multimodal Text Decoder

먼저, Image Encoder는 Vision Transformer(ViT) 구조를 기반으로 이미지 데이터를 인코딩한다. 이미지의 글로벌 표현(global representation)을 생성하며, 이는 Contrastive Learning 및 Captioning에 사용된다. 출력은 Attention Pooling을 통해 토큰 표현으로 변환된다.

Unimodal Text Decoder의 경우, 텍스트 데이터를 인코딩하고 이미지와의 유사성을 학습하는 Contrastive Learning에 사용된다. 텍스트 입력의 최종 토큰(cls-token)은 이미지 인코더의 출력과 비교되어 Contrastive Loss를 계산한다. 텍스트만을 대상으로 하는 작업에서 주로 사용된다.

Multimodal Text Decoder는 이미지와 텍스트를 결합하여 텍스트를 생성하는 캡셔닝 작업에 사용된다. 구체적으로는, 이미지 인코더의 출력(글로벌 표현)을 입력받아 Cross-Attention 메커니즘을 활용해 이미지 특징을 참조하여 텍스트 시퀀스를 생성한다. Captioning Loss를 최적화하는 데 사용된다.

CoCa 모델은 pretraining 과정에서 Contrastive Loss와 Captioning Loss를 최적화하며, 이후, 다양한 방식으로 다운스트림 작업에 사용될 수 있다.

- Zero-shot

- Frozen-feature

- Finetuning 등

Result

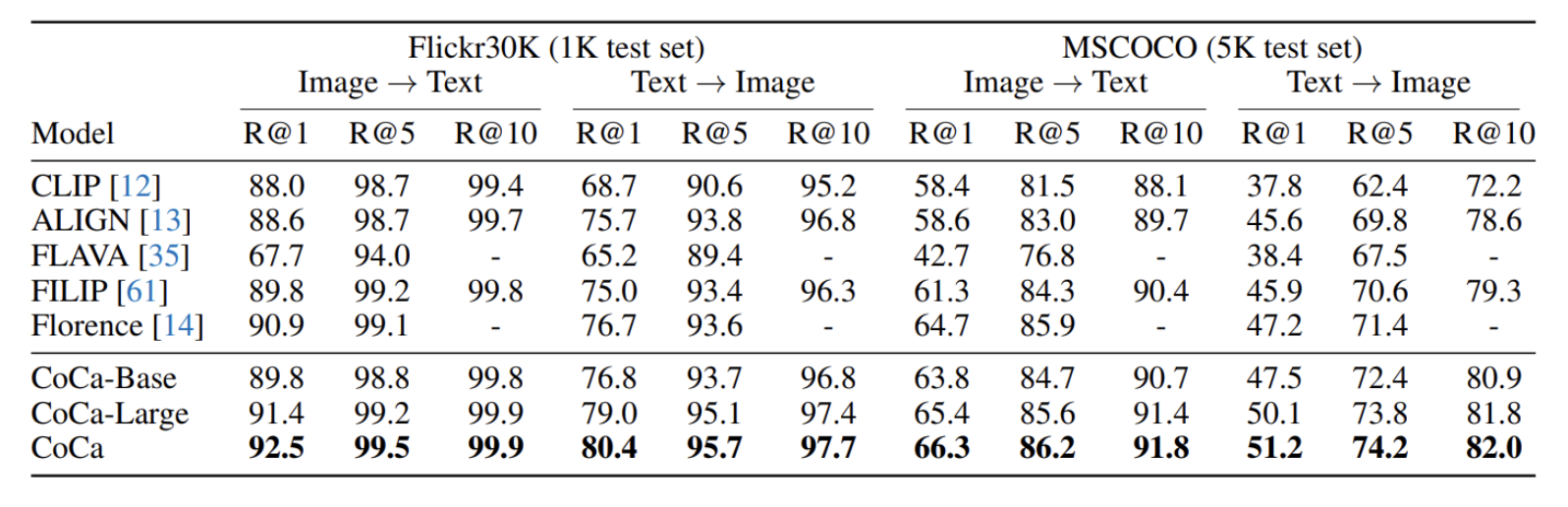

위 표를 참고해보면, 이미지-텍스트 검색 작업에 대해 MS-COCO 및 Flicker30K 데이터셋에서 SoTA 성능 달성한 것을 확인할 수 있다.

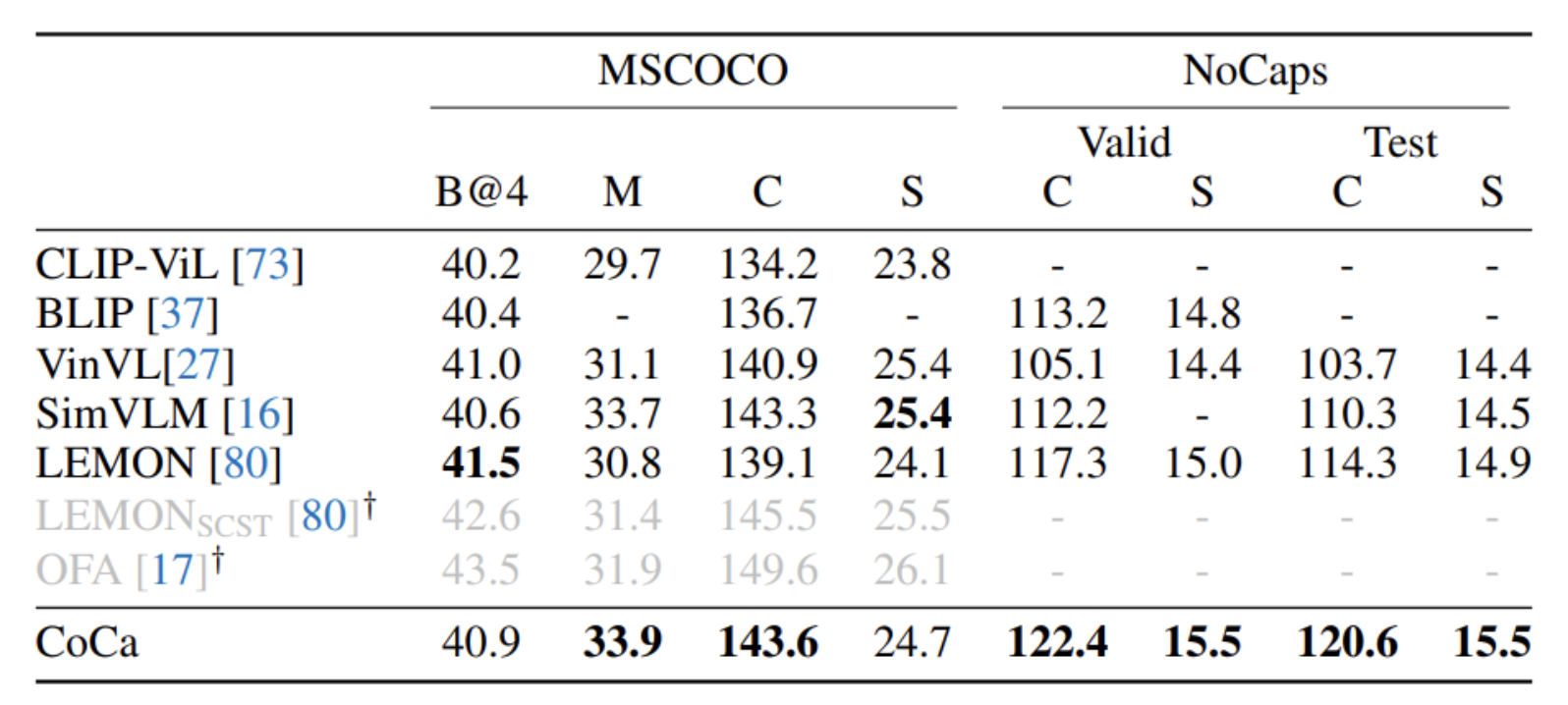

이번엔 이미지 캡셔닝 작업에 대한 성능을 비교한 표다. MSCOCO와 NoCaps 데이터셋에서 CoCa는 전반적으로 가장 높은 CIDEr(C) 점수를 보인 것을 확인할 수 있다. 특히 NoCaps에서 CoCa는 Zero-shot 학습 환경에서도 뛰어난 성능을 보여준다. 다양한 지표에서 고르게 높은 성능을 보인다는 것을 통해 기존 모델들 보다 범용성이 있다는 것을 보여준다.