FLIP(Fast Language Image Pre Training)

개요

CLIP을 간단하고 효율적으로 학습하는 방법으로 제안하였다. 학습 중 이미지 패치의 대부분을 무작위로 마스킹, 학습 데이터 역시 LAION 400M으로 학습한다

⇒ 동일 시간 내에 더 많은 이미지-텍스트 쌍 학습 가능.

⇒ 동일 메모리 사용으로 더 많은 샘플 한번에 Contrast 가능.

4백만개의 이미지-텍스트 쌍에서 마스킹 사용하지 않았을 때보다 정확도와 학습 속도 모두 개선됨을 보였다.

1. Introduction

CLIP은 자연어 감독을 통해 4억개의 이미지-데이터 쌍에서 높은 성능을 기록했으나 컴퓨팅 자윈에서 한계가 있다.

FLIP은 Masked Autoencoder에서 영감을 받아, 학습 중 이미지 패치의 상당 부분을 무작위 제거했다.

“한 쌍의 샘플을 얼마나 정밀하게 보는가 + 얼마나 많은 샘플 쌍을 처리할 수 있는가” 의 Trade Off가 본 연구에서 가장 핵심이 되는 주제이다.

⇒ 동일한 실제 학습 시간 안에 더 많은 샘플 처리

⇒ 유사한 메모리 사용량 하에 각 단계에서 더 많은 샘플을 비교/대비

50~75%의 패치를 제거함으로써 2~4배 더 큰 배치 사용 가능, 대조 학습의 특성 덕분에 정확도 향상으로 이어졌음을 실험을 통해 확인했다.

확장 실험 방식 : 모델 크기 확장 / 데이터셋 크기 확장 / 학습 스케줄 길이 확장

2. Related Research

- Denosing Autoencoders : 마스킹 노이즈를 활용한 비지도 표현 학습 방법. BERT 등. 컴퓨터 비전 분야에서도 결측치 복원과 픽셀 시퀀스 등에서 활용되고 있다.

- Masked Autoencoder(MAE): 시간과 메모리를 획기적으로 줄일 수 있는 방법이다. 보이는 영역(visible content)에만 ViT 인코더를 희소하게 적용하며, 높은 마스킹 비율이 정확도 향상에 기여한다. 그러나 본 연구는 디코딩에 많은 자원을 투입하지 않고 속도 향상을 위해서만 사용한다.기존에도 유사 연구가 있었으나 학습 규모 면에서 한계가 있었다.

- 자연어 지도학습: CLIP 등 이전의 선행 연구에서 자연어와 이미지 쌍을 비교하는 contrastive learning 방식을 대중화했으며, 이는 Contrastive Loss와 결합되어 사용된다.

3. Method

CLIP 방식에서 단순히 입력 데이터를 마스킹함으로써

=> 동일한 학습 시간 내에 더 많은 데이터 학습 가능 / 동일한 메모리 내에서 더 큰 배치 학습 가능함을 보였다.

Image Masking

Visual Transformer를 이미지 인코더로 사용.

이미지는 겹치지 않는 패치들로 분할되며, 50 또는 75%의 패치를 무작위 마스킹.

마스킹 비율이 50%일때는 시간 복잡도 절반, 75%일때는 3/4 감소, 메모리 사용량도 비례해서 감소함을 보였다.

Text Masking

텍스트 인코더는 소거 실험을 위한 도구

Objective

높은 정확도를 위해서 충분한 양의 음성 샘플은 필수적이다.

복원을 하지 않아도 다양한 이미지 텍스트 쌍을 비교하며 일반화 성능 향상 가능. ⇒ 제로샷 성능 up, 복원을 생략함으로써 연산량 down

Unmasking : Test 상황에서는 완전한 이미지 사용 가능하고, 파인튜닝을 위해서 마스킹되지 않은 이미지 쓸 수 있다.

Implementation

기본적으로 CLIP의 구현을 따르나 ViT에서 Layer Norm 사용하지 않는다.

토큰을 순차적으로 예측하는 것이 아닌 BERT처럼 전체 시퀀스를 한 번에 인코딩 / 시퀀스 길이, 토큰 길이, 토크나이저가 CLIP과 다르나 큰 의미는 없다.

CLIP과 동일하게 이미지 인코더와 텍스트 인코더가 각각 같은 차원의 공간으로 임베딩, 이 임베딩간의 코사인 유사도를 사용한다.

프롬프트 등 그 외 요소들은 대부분 동일하게 적용되었다.

4. Experiments

Ablations

마스킹 비율

50% → CLIP 대비 정확도 1.2% 향상, 학습 속도 CLIP 대비 50%

75% → 향상 없음, 학습 속도 CLIP 대비 33%

배치 크기

배치 크기와 정확도는 비례.

마스킹 자체가 regularization 효과를 주기 때문에 정보 손실과 오버피팅을 방지할 수 있었다.

FLIP은 큰 배치를 자연스럽게 유도, 마스킹 비율이 달라졌을 때도 마찬가지.

텍스트 마스킹

랜덤으로 50%를 마스킹 했을 때, 무의미한 정확도 감소를 보임.

원래 모델 자체도 엄청 헤비하지 않아서 학습속도/메모리 사용량에 큰 감소를 보이지 않았다.

추론 시 마스킹 여부

추론 시 이미지에 마스킹을 적용했을 경우 오히려 정확도가 떨어지는 모습을 보였다.

Unmasked Tuning

앞서 언급했다시피 기본적으로는 Masked Training을 진행하지만 Unmaksed Data를 통해서 Fine Tuning이 적용될 수 있다. 그러나 유의미한 결과를 보이지는 않았다.

MAE의 설계를 따라 복원 구조를 추가했으나, 실험 결과 복원을 추가했을 경우 제로샷 정확도에서 약간의 부정적인 영향을 보였다.

또한 모델의 복잡도에도 불리하기 때문에 복원은 적용하지 않는다.

Trade off

FLIP은 CLIP보다 약 3배 빠른 속도로 같은 결과를 얻을 수 있었다.

CLIP의 Baseline Model이 10일 걸리는 작업을 FLIP은 2~3를 줄일 수 있음.

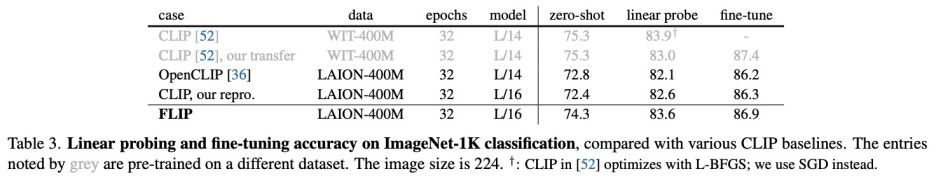

CLIP과의 비교

(CLIP은 비공개 데이터셋으로 학습되었기 때문에 본 연구진들이 공개된 LAION-400M 데이터셋으로 다시 재현하였다)

- ImageNet zero-shot transfer

- ImageNet linear probing & Fine Tuning

CLIP은 FLIP에 비해 fine tuning시 더 큰 성능 향상폭을 보였다.

- 기타 Dataset에서 zero shot 성능도 FLIP이 일반적으로 더 높은 것을 볼 수 있다

- zero shot retrival

- zero shot robustness

: 같은 CLIP 모델 안에서는 WIT보다 LAION으로 사전학습 한 모델이 더 높은 성능을 보였고, Robustness 역시 FLIP모델이 더 높은 성능을 보였다. 저자는 그 이유로 마스킹이 일종의 노이즈이자 정규화 방식으로 역할을 했다고 추측한다.

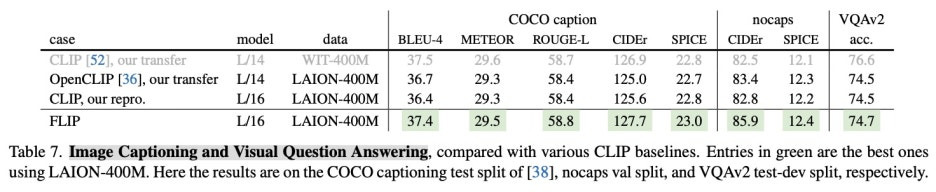

- Image Captioning and Visual Question Answering

: Captioning은 단순 분류보다 훨씬 복잡한 Task이다. 모델 뒤에 자연어를 생성하는 Autoregressive Decoder가 필요하기 때문에 새롭게 본 묘듈을 추가한다. 위 실험에서 FLIP은 마스킹을 통해 훨씬 더 일반화 성능을 갖추었기 때문에 높은 성능을 보인다.

: Visual Question Answering은 이미지와 자연어 질문을 입력으로 받아서 정답을 출력하는 형태이다. 따라서 원본 FLIP 모델에 이미지 임베딩과 자연어 임베딩을 결합해 추론할 수 있는 Multimodal Fusion Transformer와 정답을 고르는 Answer Classifier를 추가했다.

C. Scaling Behavior

: 이렇게 경량화한 모델을 바탕으로 모델, 데이터, 스케줄 세 가지를 각각 확장 실험했다. 모델의 경우는 파라미터 2배, 데이터는 사전학습되는 양을 4억개에서 20억개로, 스케줄 역시 2배 확장했다.

다음 표에서 볼 수 있듯이, 데이터에 스케일링을 적용했을 때는 제로샷 환경에서, 모델에 스케일링을 적용했을 때는 전이학습에서 성능 개선을 볼 수 있었다.

Conclusion

자연어 지도 학습(Natural Language Supervision Learning)은 일반적인 지도 학습에 비해 훨씬 월등한 성능을 보인다. 본 연구에서 제안한 FLIP 모델은 CLIP모델에 Masking을 가함으로써 모델의 경량화를 이끌어냈고, 이렇게 경량화된 모델을 바탕으로 Scaling을 적용해 훨씬 높은 성능을 보였다.

한계점으로는 LLM 모델이 항상 가질 수 있는 편향과 환경적인 요인을 지적하며 이 글을 마무리한다.

GitHub - facebookresearch/flip: Official Open Source code for "Scaling Language-Image Pre-training via Masking"

Official Open Source code for "Scaling Language-Image Pre-training via Masking" - facebookresearch/flip

github.com

본 논문의 구현 코드는 깃허브를 통해 공개되어 있다.