State-of-the-art computer vision systems are trained to predict a fixed set of predetermined object categories. This restricted form of supervision limits their generality and usability since additional labeled data is needed to specify any other visual concept. Learning directly from raw text about...

arxiv.org

Learning Transferable Visual Models From Natural Language Supervision

State-of-the-art computer vision systems are trained to predict a fixed set of predetermined object categories. This restricted form of supervision limits their generality and usability since additional labeled data is needed to specify any other visual co

arxiv.org

본 논문은 지난 2021년 Chat GPT를 운영중인 Open AI에서 발표한 논문이다.

위 연구를 한 줄로 요약하자면 이미지와 텍스트 레이블을 Pre Training 방식을 통해 Pairing하는 모델이라고 할 수 있다.

- Introducion & Motivation

그동안 GPT계열, Bert계열 모델을 비롯해 NLP분야에서는 사전 학습된 모델(Pre-trained Model)이 높은 성능을 보였고 Mainstream으로 자리잡았다.

그러나 여전히 컴퓨터 비전 Task에서는 아직까지 사람이 직접 레이블링한 데이터로 학습하는 경우가 일반적이었다. 따라서 이러한 점에 착안해, 이미지 라벨링 역시 웹 텍스트를 통해 학습하고자 하는 시도가 진행되었고, 이는 본 연구의 핵심인 자연어 감독(Natural Language Supervision)으로 이어졌다. 웹 텍스트를 통해 사전 학습을 진행하게 되는 이유는 훨씬 더 많은 양의 데이터를 답습하기 위함이다. 이어지는 실험에서도 약 4억건의 데이터를 통해 진행하였다.

2. Approach

- 자연어 감독(Natural Learning Supervision)

자연어 감독이란 이미지에 대한 라벨링을 사람이 하는 대신, 이미 기존에 있는 이미지에 해당하는 캡션을 라벨로 사용하는 것이다. 예를들어 사진 제목, 웹 자막 등에 있는 문장을 Text Encoder를 통해 벡터로 변환하고, 이미지와 매핑시키는 방식이다.

예를 들어 강아지 사진이 있고 "Pepper the aussie pup" 이라는 문장과 매핑을 시키게 되면 강아지의 시각적 특징과 단어가 같은 공간에서 매칭된다. 이러한 방식은 한 이미지에 대해 하나의 라벨만 이어지는 기존의 방식과 달리 훨씬 더 넓은 개념을 학습할 수 있기 때문에 Zero-Shot 상황에서 유리하다.

- WIT Data Set

기존의 데이터셋은 품질이나 그 양이 충분하지 않아 한계가 명확했다. 따라서 WIT(WebImage Text)라는 새로운 데이터셋을 구축했다. 이는 인터넷에서 수집한 약 4억개의 이미지 - 자연어쌍이다.

- Selecting Pre - Training Method

본 연구에서는 Contrastive Learning(대조학습) 방식을 채택했다. 외에도 Caption‑Prediction LM, BoW등의 방식이 시도되었으나 본 연구에서 비효율적이라고 판단되었다. 다음은 Contrastive Learning에 대한 간략한 구조이다.

하나의 Batch는 N개의 이미지 자연어 쌍으로 이루어지고 모든 쌍을 반복 검증하게 되면 N개의 옳은 쌍과 N^2-N개의 잘못된 쌍을 얻게 된다. 여기서 옳은 쌍은 이미지와 자연어의 코사인 유사도를 최대한 가깝게 하고 옳지 않은 이미지는 반대로 하는 방식으로 학습한다.

다음 그림의 Contrastive Pre Training 부분을 보면 보다 직관적으로 이해할 수 있다.

각각 이미지와 자연어는 Text Encoder, Image Encoder로 벡터화된다. Encoder에 관해서는 잠시후에 더 자세히 다룬다. 이렇게 생성된 벡터를 대상으로 Multimodal Matrix를 만든다. 해당 Matrix의 대각성분이 옳은 쌍이 되고 나머지가 잘못된 쌍이 된다.

다음은 논문에서 언급된 의사 코드이다.

- Choosing, Scaling Model & Training

위애서 사용된 Image Encoder와 Text Encoder는 각각 ResNet-D와 Visual Transfromer, Text Transformer를 사용하였다. 각 모델은 스케일을 다르게 해 사용하였다. 모델의 Task 수행 과정은 다음과 같다.

(2) 그림을 보면 주어진 템플릿 'A photo of a {object}' 의 빈칸에 각 레이블에 해당하는 단어를 넣고 Text Encoder를 통해 벡터화 시킨다(T1 ~ Tn). (3)에서는 Zero shot 이미지를 인코딩 한 후 각 텍스트와 매칭시킨다. 그 중 가장 유사도가 높은 레이블을 이미지의 클래스로 예측한다.

3. Experiments

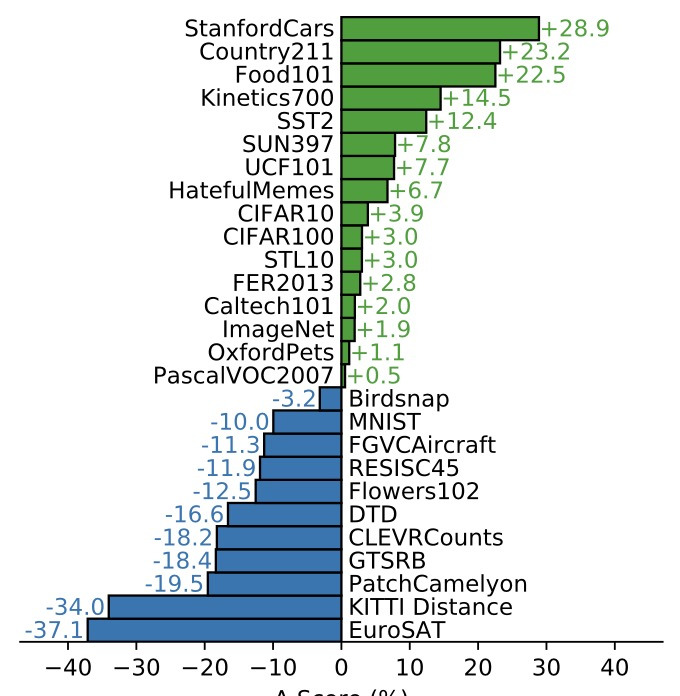

실험 결과 일부 데이터셋의 이미지 분류 Task의 높은 Zero shot성능을 보였다.

총 27개의 데이터셋 중 16개에서 기존의 Baseline Model보다 정확도가 높게 나타난 반면 인공위성 이미지 분류와 같이 지엽적인 분류에서는 한계가 있었다. 아무리 대규모의 사전 학습을 진행했더라도 다소 지엽적인 이미지는 학습이 덜 되었음을 추측할 수 있다.

또한 앞서 언급한 템플릿(프롬프트)를 적절히 설정해주었을 때 더 높은 성능을 보였다.

다음은 CLIP에서 Zero-shot 모델을 다른 모델의 Few shot 모델과 비교한 결과이다. 타 모델은 최소 16-Shot 모델이 되었을 때 Zero-Shot Clip과 성능이 유사해졌다.

- Robustness to Natural Distribution Shift

Image Net에서는 이미지의 각도나 배경 등 분포가 살짝만 달라져도 정확도가 훨씬 떨어지는 문제가 발생했다.

이러한 문제에서 CLIP은 4억쌍의 방대한 양의 Pre Training Data로 학습하기 때문에 특정 배경, 각도 등에 덜 치우치게 된다. 또한 고양이의 귀, 꼬리, 수염 등 핵심 특징을 언어로 학습하기 때문에 이러한 문제에서 보다 Robust하게 나타났다.

우측 그림에서는 같은 바나나임에도 불구하고 각 사진은 모두 다른 형태를 띄고 있다. 다음 그래프를 보면 CLIP계열 모델이 이러한 상황에서 훨씬 Robust함을 볼 수 있다.

사람과 비교했을 때 조차도 더 높은 정확도를 보였다.

4. Limitations

Zero shot CLIP 모델이 ResNet과 같은 Baseline Model에 비해서는 성능이 좋으나, 모든 분야에서 SOTA를 달성하기 위해서는 약 1000배의 컴퓨팅 자원이 필요하다. 또한 앞선 실험 결과에서 볼 수 있듯이 인공위성과 같은 추상적인 이미지 분류에서는 낮은 성능을 보이기도 했다. 따라서 이러한 부분에 있어서는 일부 few shot 학습의 적용을 고려할 수 있다. 또한 사전 학습된 모델인 만큼 이 사전 학습에도 굉장히 영향을 많이 받는다. 분류 해야하는 이미지가 사전 학습 데이터셋에 존재하지 않을 경우 성능에 문제가 생길 수 있다.