논문 링크: https://arxiv.org/abs/2112.10752

High-Resolution Image Synthesis with Latent Diffusion Models

By decomposing the image formation process into a sequential application of denoising autoencoders, diffusion models (DMs) achieve state-of-the-art synthesis results on image data and beyond. Additionally, their formulation allows for a guiding mechanism t

arxiv.org

<전체적인 맥락 이해>

확산모델(Diffusion)의 고성능은 유지하면서 계산비용(학습/생성)을 크게 줄이는 방법을 이해하는 것이 핵심. 핵심은 이미지를 픽셀에서 직접 다루지 않고 오토인코더로 ‘사람 눈에 중요하지 않은 디테일은 덜어낸’ latent(압축) 공간을 만든 다음 그 공간에서 확산모델을 학습/샘플링하는 Latent Diffusion에 cross-attention을 붙여서 텍스트/레이아웃/세그맵 같은 다양한 조건을 생성 과정에 자연스럽게 주입할 수 있게 만든 게 포인트이다. 결과적으로 더 빠르고 가벼운데도 텍스트-투-이미지, 초해상도, 인페인팅 같은 여러 조건부 생성에서 경쟁력 있는 성능 확인이 가능하다.

0. Abstract

- 픽셀 공간에서 비싼 확산모델(DM)을 ‘잠재공간(latent space)’으로 옮겨 계산비용을 크게 줄이면서도, 품질·유연성(조건부 생성)을 유지/향상시키는 Latent Diffusion Models(LDM)을 제안한다.

1. Introduction

1) 문제 제기: 고해상도 이미지 합성의 “성능 vs 비용” 딜레마

최근 이미지 합성 흐름

- 고해상도·복잡한 자연 장면 합성은 주로 likelihood-based 모델을 스케일업하는 방향

- 특히 거대 autoregressive(AR) transformer가 지배적(수십억 파라미터 규모 가능)

GAN의 한계

- GAN은 성과가 있었지만, 학습 방식(적대적 학습)이 복잡하고 multi-modal한 분포로 잘 스케일되지 않아

→ 변동성이 제한된 데이터에서만 성능이 잘 나오는 경향이 드러남.

Diffusion Model의 부상

- denoising autoencoder 계층 구조 기반인 diffusion model이 이미지 합성뿐 아니라 다양한 태스크에서 인상적 성과

- 클래스 조건부 생성, 초해상도 등에서 SOTA로 자리잡음.

- inpainting, colorization, stroke-based synthesis 등으로 쉽게 확장 가능

2) Diffusion Model의 강점

- likelihood-based라서 GAN처럼 mode collapse / 학습 불안정성이 덜함.

- 파라미터 공유(parameter sharing)로 매우 복잡한 자연 이미지 분포도 모델링 가능

→ AR처럼 “수십억 파라미터”까지 가지 않아도 됨

3) 핵심 한계: democratizing 를 막는 계산비용

왜 비싼가?

- DM은 likelihood-based 모델 특성상 mode-covering 성향

→ 사람이 못 느끼는 비가시적 디테일(imperceptible details)까지 모델링하는 데 용량/연산을 과도하게 쓸 수 있음 - 학습·평가가 RGB 픽셀 고차원 공간에서 반복적 함수 평가(및 그라디언트 계산)를 요구

- 추론도 노이즈가 낀 입력 공간에서 반복 평가가 필요해 비쌈

결과(커뮤니티 관점의 문제)

- 학습: 수백 GPU-days 수준 → 소수 연구집단만 가능 + 탄소 발자국 문제

- 추론: 샘플 생성 자체가 느림 + 메모리/시간 소모 큼(수십~수천 스텝의 순차 실행)

4) 해결 방향: Latent Space

- likelihood-based 모델 학습은 대략 두 단계로 나뉨:

- Perceptual compression: 고주파 디테일 제거(지각적 압축), 아직 의미적 다양성은 적게 학습

- Semantic compression: 의미/개념적 구성(semantic & conceptual composition)을 학습하는 진짜 생성 단계

목표

- “지각적으로 동등(perceptually equivalent)하지만 계산적으로 더 유리한 공간”을 찾고

→ 그 공간에서 확산모델을 학습하자.

5) 제안 방법 개요: 2단계 학습(오토인코더 → latent diffusion)

Phase 1: 오토인코더 학습

- 저차원 잠재표현을 제공하는 autoencoder를 먼저 학습

- 목적: 데이터 공간과 지각적으로 동등한 효율적 표현 공간 확보

Phase 2: 잠재공간에서 DM 학습

- diffusion model을 픽셀이 아니라 학습된 latent space에서 학습

- 기존 일부 연구와 달리 과도한 공간 압축(spatial compression)에 의존하지 않아도 됨

- latent에서 학습하는 DM이 공간 차원에 대해 더 좋은 scaling을 갖는다고 주장

- 이 모델군을 Latent Diffusion Models (LDMs)로 명명

추가 장점

- 오토인코더는 한 번만 학습하고 여러 diffusion 학습/태스크에 재사용 가능

→ 다양한 image-to-image / text-to-image로 효율적 확장 가능 - 텍스트 조건부를 위해: transformer를 DM의 UNet backbone과 연결하는 구조를 설계

6) 기여점

(i) 스케일링 및 고해상도

- transformer-only 접근보다 고차원 데이터로 더 자연스럽게(scale gracefully) 확장

- 더 충실하고 디테일한 재구성을 제공하는 압축 레벨에서도 동작

- 메가픽셀급 고해상도 합성에 효율적으로 적용 가능

(ii) 비용 절감 + 성능 경쟁력

- unconditional synthesis, inpainting, stochastic super-resolution 등에서 경쟁력 확보

- 학습 비용 크게 절감, 픽셀 기반 DM 대비 추론 비용도 감소

(iii) 재구성 vs 생성 간 가중치 튜닝 필요 감소

- encoder/decoder + prior를 동시에 배우는 방식과 달리

→ 재구성과 생성 능력 사이의 섬세한 가중치 조절이 필요 없다고 주장 - 결과: 재구성이 매우 충실하고 latent space 정규화 요구가 적음

(iv) 조밀 조건(dense conditioning) 태스크에서의 convolutional 적용

- super-resolution / inpainting / semantic synthesis 같은 조밀 조건 작업에서

→ convolutional 방식으로 적용 가능, 매우 큰(약 1024² px 규모) 일관된 이미지 렌더링 가능 주장

(v) 범용 conditioning 메커니즘

- cross-attention 기반의 일반 목적 conditioning 설계

- class-conditional, text-to-image, layout-to-image 등 멀티모달 학습에 활용

(vi) 사전학습 모델 공개

- pretrained latent diffusion 및 autoencoder 모델을 공개(재사용 가능성 강조)

2. Related Work

1) 이미지 합성 생성모델 계열 비교

이미지의 고차원성 때문에 생성모델링이 어렵다는 전제에서 출발

1.1 GAN 계열

- 장점: 고해상도에서 샘플링이 효율적이고 지각 품질(perceptual quality)이 좋음

- 한계:

- 최적화가 어렵고

- 전체 데이터 분포를 충분히 포착하는 데 약함(분포 커버리지 이슈)

1.2 Likelihood-based 계열 (밀도추정 중심)

- 공통점: density estimation을 중시 → 최적화가 상대적으로 “잘 behaved”

- VAE / Flow

- 장점: 고해상도 합성 가능(효율적 synthesis 언급)

- 한계: 샘플 품질이 GAN만큼은 아님

- Autoregressive Models (ARM)

- 장점: density estimation 성능 강함

- 한계:

- 구조가 계산적으로 무겁고

- 샘플링이 순차적(sequential)이라 느림 → 결국 저해상도에 머무는 경향

1.3 픽셀 기반 maximum-likelihood 이 느린 이유

- 픽셀 표현에는 사람이 거의 인지 못 하는 고주파 디테일(high-frequency details)이 많음

→ maximum-likelihood 학습이 그 디테일 모델링에 불균형하게 용량을 소모

→ 학습 시간이 길어짐

1.4 해결: 2-stage(잠재공간) + AR

- 고해상도로 스케일하기 위해 여러 2-stage 접근이 raw pixel 대신 압축 latent space를 두고, 그 latent에 AR prior를 학습하는 방식 사용

2) Diffusion Model의 위치와 한계

2.1 DM의 강점

- 최근 density estimation + sample quality 모두에서 SOTA 수준 성과

- 이미지 데이터에 잘 맞는 귀납편향은 보통 UNet backbone으로 구현될 때 강화됨

- 학습에서 reweighted objective가 종종 최고 품질을 만들어냄

- 이 경우 DM을 일종의 lossy compressor로 해석 가능

- 품질 ↔ 압축 능력 트레이드 가능

2.2 픽셀 공간 DM의 병목

- 픽셀 공간에서 최적화/평가해야 하므로

- 추론 속도(inference speed)가 낮고

- 학습 비용(training cost)이 매우 큼

- 샘플링 가속(advanced sampling strategies), 계층적 접근(hierarchical approaches)으로 추론 일부는 개선 가능하지만 고해상도 학습은 여전히 비싼 gradient 계산이 필요

2.3 LDM이 제시하는 해결 포인트

- LDM은 저차원 압축 latent space에서 DM을 학습

→ 학습이 계산적으로 저렴

→ 추론도 빨라짐

→ 합성 품질 저하는 거의 없이 달성한다고 주장

3) 2-stage 이미지 합성 계열 정리 (Two-Stage Image Synthesis)

여러 방법의 단점을 완화하기 위해 “2-stage 조합” 연구가 많았다.

3.1 VQ-VAE / VQGAN 계열

- VQ-VAE: discretized latent space 위에 AR prior 학습

- 텍스트-투-이미지 확장: 이미지·텍스트를 함께 discretize해 joint distribution을 학습하는 방향도 존재

- VQGAN: 1단계에서 adversarial + perceptual objective로 더 큰 이미지까지 AR transformer를 확장

3.2 이 계열의 핵심 trade-off(논문이 비판하는 지점)

- ARM 학습을 가능하게 하려면 압축률(compression rate)이 커야 함

- 그 결과 AR 쪽 파라미터가 수십억 규모로 커지거나

- 압축을 덜 하면 계산비용이 다시 커짐

→ 즉, 가능한 학습을 위한 압축이 전체 성능을 제한하는 구조

3.3 LDM의 주장

- LDM은 컨볼루션 기반 UNet backbone 덕분에 더 고차원 latent space로도 “완만하게(gently)” 스케일 가능

- 따라서 압축 수준을 더 자유롭게 선택 가능:

- 1단계(오토인코더)가 충분히 강력한 재구성을 제공하면서도

- generative diffusion이 떠안는 “지각적 압축 부담(perceptual compression)”을 줄이고

- high-fidelity reconstruction을 보장하는 지점을 찾을 수 있다고 주장

3.4 Jointly learning encoder/decoder + score prior 접근과의 비교

- encoder/decoder와 score-based prior를 동시에 학습하는 접근도 있지만

- 재구성 능력 vs 생성 능력 사이의 가중치 조절이 어렵고

- LDM 접근이 더 낫다

3. Method

- 확산모델은 loss term을 undersampling해서 지각적으로 중요하지 않은 디테일을 어느 정도 무시할 수 있지만, 여전히 픽셀 공간에서의 함수 평가(function evaluations) 자체가 매우 비싸서 학습에 필요한 시간/에너지 자원이 과도하다는 한계가 남는다.

2) 핵심 아이디어: 압축 단계와 생성 단계의 명시적 분리

목표

- 고비용의 픽셀 공간 계산을 피하면서 고해상도 합성을 가능하게 하는 학습 구조.

방법

- 학습을 두 단계로 분리

- Compressive learning phase: 오토인코더로 이미지 → latent 표현 학습

- Generative learning phase: latent space에서 확산모델 학습/샘플링

핵심 전제

- 오토인코더가 학습하는 latent space는

- 원래 이미지 공간과 지각적으로 동등하면서도 계산 복잡도는 유의미하게 감소해야 한다.

3) 장점(논문이 명시한 (i)~(iii))

(i) 계산 효율: 저차원 공간에서의 샘플링

- 고차원 이미지 공간을 떠나 저차원 latent space에서 샘플링 → diffusion 학습/생성의 계산 효율이 크게 개선.

(ii) UNet의 귀납편향 활용 → 과도한 압축 불필요

- DM은 UNet 아키텍처에서 오는 공간 구조(spatial structure)에 대한 귀납편향을 강하게 갖는다.

→ 이미지처럼 공간적 구조가 있는 데이터에 특히 효과적

→ 따라서 기존 2-stage(특히 AR 기반) 방식처럼 - 학습 가능성을 위해 공격적(quality-reducing) 압축을 강요할 필요가 줄어든다고 주장.

(iii) latent space 재사용 가능

- 오토인코더는 general-purpose compression model로 기능

→ 같은 latent space를 가지고- 여러 생성모델을 학습할 수 있고

- 다른 다운스트림 응용(예: single-image CLIP-guided synthesis)에도 활용 가능

3.1. Perceptual Image Compression

1) 목표

- 픽셀 기반 손실(L2/L1)만 쓰면 재구성이 blurry해지기 쉬움.

- 따라서 재구성이 이미지 매니폴드(image manifold) 안에 머물도록 유도하는 압축기가 필요.

2) 모델 구성: Perceptual + Patch-based Adversarial Autoencoder

- 이전 연구를 바탕으로 한 오토인코더(encoder–decoder)

- Perceptual loss + patch-based adversarial objective

- Perceptual loss: “사람이 느끼는” 시각적 유사성을 더 잘 반영

- Patch-based adversarial: 전역이 아니라 국소(local) 패치 단위의 사실성(local realism)을 강제

→ 재구성이 “진짜 이미지 같은 질감/디테일”을 유지하도록 유도

→ 결과적으로 L1/L2만 썼을 때 생기는 흐림을 완화

3) 수식/표현: 인코딩과 복원 과정

4) 다운샘플링(압축 수준) 설계: factor (f)

- 인코더는 공간 해상도를 다운샘플링:

- 다양한 압축 수준을 실험:

- 포인트: 이후 확산모델이 latent의 2D 구조를 활용하도록 설계되어 있어서 너무 강한 압축 없이도 좋은 재구성이 가능하다는 전제와 연결됨.

5) Latent 정규화(regularization) 2종 비교

잠재공간이 임의로 분산이 커지는(high-variance) 문제를 막기 위해 두 종류를 실험

(A) KL-reg

- 학습된 latent가 표준정규에 가깝도록 약한 KL penalty 부여

- VAE 스타일의 정규화(“slight KL-penalty”, standard normal)

(B) VQ-reg

- 디코더 내부에 vector quantization layer 사용

- 논문 해석상: VQGAN과 유사하지만, quantization layer가 디코더에 흡수된 형태로 설명

6) 기존 2-stage(AR 기반) 접근과의 차별점

- 이후 diffusion 모델이 latent의 2D 구조를 그대로 다루기 때문에, 비교적 mild compression에서도 재구성이 매우 좋다.

- 일부 기존 연구는 latent (z)를 1D 순서로 펼쳐(임의의 1D ordering)

→ autoregressive로 분포를 모델링

→ 그 과정에서 (z)가 가진 공간적 구조를 상당 부분 무시하므로 디테일 보존이 상대적으로 약해질 수 있음

결론적 주장

- 본 압축 모델이 (x)의 디테일을 더 잘 보존한다.

3.2. Latent Diffusion Models

1) Diffusion Model 기본: 역마코프 과정 학습

- Diffusion Model(DM)은 데이터 분포 (p(x))를 학습하기 위해

- 정규분포 변수를 점진적으로 denoise하는 방식으로 생성

- 이는 길이 (T)의 고정된 Markov chain의 역과정(reverse process)을 학습하는 것과 대응됨.

2) 학습 목표: reweighted variational bound ↔ score-matching 관점

- 이미지 합성에서 성능이 좋은 DM들은 (p(x))에 대한 변분 하한(VLB)의 reweighted variant를 사용

3) DM을 “denoising autoencoder들의 시퀀스”로 해석

- 모델은 시간 에 대해 denoising 네트워크(오토인코더 역할)를 연속적으로 적용하는 것으로 볼 수 있음

- 네트워크는 입력 (x_t)로부터 “denoised variant”를 복원하는 방향으로 학습됨(구현적으로는 노이즈 예측 형태).

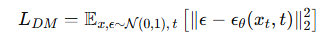

4) 픽셀 공간 DM의 단순화된 목적식

- t는 {1,...,T}에서 균등 샘플링

- 핵심: 네트워크 주입된 노이즈 (\epsilon)을 맞히도록 학습

5) LDM의 전환점: “latent representation”에서 생성모델링

전제

- 3.1에서 학습한 압축 모델 (E, D)로

- 효율적인 저차원 latent space 확보

- 고주파·비가시적 디테일(imperceptible details)이 추상화(abstracted away)됨

왜 latent가 더 적합한가 (likelihood-based 관점)

- 픽셀 고차원 공간보다 latent 공간이

- 모델이 의미적(semantic) 정보에 더 집중할 수 있고

- 차원이 낮아 계산 효율이 크게 좋아짐

6) 기존 “discrete latent + AR transformer”와의 대비

- 이전 접근들은 매우 압축된 discrete latent 위에서 autoregressive / attention 기반 transformer로 prior를 학습하는 경우가 많았음

- LDM은 이미지에 특화된 귀납편향을 적극 활용, 특히 UNet을 2D convolution 중심으로 구성할 수 있음

→ latent가 본래 갖는 2D 구조를 그대로 이용한다는 방향성이 강조됨

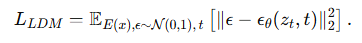

7) LDM의 목적식: latent에서의 reweighted bound

픽셀 대신 latent (z=E(x))에서 같은 형태의 학습을 수행:

- 학습 신호는 동일한 “노이즈 예측” 형태지만, 입력 공간이 latent로 바뀜.

3.3. Conditioning Mechanisms

1) 조건부 확산의 기본 형태

- 확산모델은 원리적으로 조건부 분포를 모델링할 수 있음.

- 구현은 조건부 denoising 네트워크로

- 이를 통해 생성 과정은 입력 (y)로 제어 가능

- 예: 텍스트, semantic map, 각종 image-to-image 변환 등

2) 기존 연구의 공백: “클래스 라벨 이상”의 conditioning은 덜 탐구됨

- 이미지 합성 맥락에서 DM의 generative power를

- class-label 조건, 혹은 입력 이미지의 blurred variant 같은 제한적 조건 너머로 확장하는 건 아직 under-explored라고 문제의식을 제시

3) LDM의 해법: UNet + Cross-Attention

핵심 제안

- DM의 UNet backbone을 cross-attention으로 확장

→ 다양한 모달 입력(텍스트 등)을 효과적으로 조건으로 활용.

왜 cross-attention인가

- 여러 입력 모달리티를 attention 기반으로 다루는 데 효과적이라고 설명.

4) 조건 입력 (y) 처리: 도메인별 인코더

- 입력 (y)는 모달리티가 다양할 수 있음(언어 프롬프트 등).

- 이를 위해 domain-specific encoder 를 둠

- 이 중간 표현을 UNet의 중간 층(intermediate layers)에 cross-attention으로 연결.

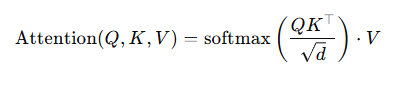

5) Cross-Attention 수식과 UNet feature 주입 방식

논문은 attention을 다음과 같이 정의:

여기서 각 구성은:

해석

6) 조건부 LDM 학습 목표

조건 입력을 포함한 목표식은:

- 픽셀 대신 latent 에서 확산을 수행한다는 골격은 동일

- 차이: denoiser가 (\tau_\theta(y))를 조건으로 받아 노이즈를 예측

- conditioning 메커니즘이 유연한 이유는 (\tau_\theta)를 입력 모달리티에 맞는 전문가 모델로 파라미터화할 수 있기 때문

- 예: (y)가 텍스트 프롬프트면 (\tau_\theta)로 (unmasked) transformer를 사용 가능

4. Experiments

4.1. On Perceptual Compression Tradeoffs

1) 실험 세팅: “압축률 (f)”만 바꿔서 비교

- 비교 대상: (f \in {1,2,4,8,16,32})

- 표기: LDM-(f)

- LDM-1 = 픽셀 기반 diffusion(DM)에 해당

- 공정 비교를 위한 통제:

- 모든 실험: 단일 NVIDIA A100

- 같은 파라미터 수, 같은 학습 스텝 수, 같은 계산 예산

2) 핵심 관찰 1: 작은 (f) (LDM-1,2)는 “학습이 느림”

- Fig. 5 관찰 요지:

- LDM-1(픽셀 기반)**은 같은 계산 예산에서 학습 진행이 현저히 느림(“substantially larger train times”)

- LDM-2도 유사하게 “작은 압축” 구간에서 진행이 느린 쪽

- 논문이 제시하는 이유:

- 압축이 약하면(작은 (f)) 지각적 압축(perceptual compression) 부담이 더 많이 diffusion 모델 쪽으로 넘어감

→ 고차원 공간에서 처리할 일이 많아져 비효율

- 압축이 약하면(작은 (f)) 지각적 압축(perceptual compression) 부담이 더 많이 diffusion 모델 쪽으로 넘어감

3) 핵심 관찰 2: 너무 큰 (f) (LDM-32)는 “품질이 일찍 정체”

- Fig. 5에서:

- (f)가 과도하게 크면(예: 32) 비교적 적은 학습 스텝 이후 fidelity가 정체(stagnating).

- 논문이 제시하는 이유:

- 1단계 압축이 지나치면 정보 손실(information loss)이 발생

→ diffusion이 아무리 학습해도 복원 가능한 품질의 상한이 낮아짐.

- 1단계 압축이 지나치면 정보 손실(information loss)이 발생

4) 결론 1: LDM-4~16은 “좋은 균형”, 특히 4~8이 핵심

- LDM-4~16이 효율과 지각적으로 충실한(perceptually faithful) 결과 사이 균형이 좋다고 정리

- 특히 ImageNet에서 픽셀 기반 LDM-1 대비 LDM-8이 2M 스텝 후 FID에서 큰 격차를 보였다고 강조

5) 샘플링 속도 vs 품질(FID): Fig. 6

- 평가 방식:

- DDIM sampler로 denoising step 수를 {10, 20, 50, 100, 200} 등으로 바꿔가며

- 샘플링 속도(throughput)**와 FID를 함께 비교

- FID는 5000 샘플 기준

- 결과 요약:

- LDM-4~8이 부적절한 압축비(너무 작거나 너무 큰 (f)) 모델들보다 전반적으로 우수

- 특히 픽셀 기반 LDM-1 대비:

- FID가 더 낮고(품질↑)

- 샘플 throughput이 더 높음(속도↑)

→ “더 빠른데 더 좋다”는 결론을 실험적으로 뒷받침

6) 데이터셋에 따른 함의: 복잡한 데이터는 압축을 과하게 하면 손해

- 논문은 ImageNet 같은 복잡한 데이터셋에서는 압축률을 너무 크게 하면 품질이 떨어지므로 “reduced compression rates”가 필요하다고 정리

- LDM-4와 LDM-8이 고품질 합성에서 가장 안정적인(best behaved) 구간에 위치

4.2. Image Generation with Latent Diffusion

1) 실험 목표 및 평가 지표

목표

- 256² 해상도에서 무조건부 이미지 생성 모델을 학습하고

- 샘플 품질(sample quality)

- 데이터 매니폴드 커버리지(coverage)를 함께 평가

학습 데이터셋

- CelebA-HQ

- FFHQ

- LSUN-Churches

- LSUN-Bedrooms

평가 지표

- FID (샘플 품질 중심)

- Precision-and-Recall (분포 커버리지/정밀도·재현율 관점)

2) 핵심 결과 1: CelebA-HQ에서 SOTA (FID 5.11)

- CelebA-HQ에서 FID = 5.11을 보고하며 새로운 SOTA라고 주장

- 비교 대상 측면에서:

- 기존 likelihood-based 모델들보다 우수

- GAN들보다도 우수하다고 서술

3) 핵심 결과 2: 데이터셋 전반 성능 + 예외(LSUN-Bedrooms)

- prior diffusion 기반 접근들과 비교해 LSUN-Bedrooms를 제외한 대부분에서 더 좋다고 주장

- LSUN-Bedrooms에서는:

- ADM에 근접한 성능이라고 언급

- 그럼에도 비교 우위로 제시하는 점: ADM 대비 파라미터 수는 절반, 학습 자원은 4배 덜 필요

4) Precision/Recall 관점 결론: likelihood-based의 mode-covering 이점 확인

- LDM이 Precision/Recall에서 GAN 기반 방법들을 일관되게 개선했다고 서술

- 논문의 주장:

- likelihood 기반 학습의 mode-covering 성질이

- adversarial 접근(GAN)의 한계(분포 커버리지 문제) 대비 장점으로 나타난다

5) 정성적(qualitative) 결과 및 조건부 생성 예시 연결

- Fig. 4에서 각 데이터셋에 대한 정성적 결과 제시

- Fig. 7 예시 언급:

- (상단) COCO에서 layout-to-image 샘플

- (하단) LAION-400M 기반 text-to-image 샘플

→ 이 절의 “image generation” 결과를, 이후 조건부/멀티모달 확장 사례와 시각적으로 연결해 보여주는 역할

4.3. Conditional Latent Diffusion

4.3.1 Transformer Encoders for LDMs

1) 조건부 LDM의 핵심

- cross-attention 기반 conditioning을 LDM에 넣으면

→ 기존 diffusion 모델에서 상대적으로 덜 탐구된 다양한 조건 모달리티(텍스트, 레이아웃 등)를 다룰 수 있게 된다고 정리

2) Text-to-Image: LAION-400M 기반 대규모 학습

학습 설정

- 텍스트-투-이미지 모델을 LAION-400M으로 학습

- 모델 규모: 1.45B 파라미터

- 토크나이저: BERT-tokenizer

- (\tau_\theta) 구현: Transformer

- 텍스트 프롬프트로부터 latent code(중간 표현)를 추론

- 이를 UNet에 cross-attention으로 주입

의미

- “언어 표현(도메인 전문가: transformer)” + “시각 합성(LDM)” 결합이

→ 복잡하고 사용자 정의적인 텍스트 프롬프트로도 일반화가 잘 되는 강력한 모델을 만든다

3) Text-to-Image 정량평가: MS-COCO val

- 선행연구 관행에 따라 MS-COCO validation set에서 텍스트-투-이미지 성능 평가

- 결과: 강력한 AR 기반 방법과 GAN 기반 방법 대비 개선을 보고

추가 관찰: classifier-free guidance를 적용하면 샘플 품질이 크게 향상된다고 명시

4) Layout-to-Image: semantic layout 조건 생성

- cross-attention conditioning의 유연성을 보이기 위해,

- OpenImages에서 semantic layout 기반 합성 모델 학습

- 이후 COCO로 finetune

5) Class-conditional ImageNet: f∈{4,8} 최고 모델 평가

- Sec. 4.1에서 성능이 좋았던 (f \in {4,8}) 기반의 class-conditional ImageNet 모델을 평가

- 결과 : SOTA diffusion 모델 ADM을 능가하면서 계산 요구량과 파라미터 수를 크게 줄였다고 주장

4.3.2 Convolutional Sampling Beyond 256²

1) 핵심 아이디어: “공간 정렬 조건”을 입력에 concat → 범용 I2I 모델

- (\epsilon_\theta) (denoiser)의 입력에

- spatially aligned conditioning information을 concatenate하면 LDM을 general-purpose image-to-image translation 모델로 활용 가능하다고 제시.

- 이 방식으로 학습/적용하는 태스크:

- semantic synthesis

- super-resolution

- inpainting

2) Semantic synthesis 실험 설정: f=4 + (semantic map ⊕ latent)

데이터

- landscape 이미지 + semantic map 페어(선행 연구에서 사용된 형태)

모델/표현

- (f=4) 모델의 latent 이미지 표현을 사용

- 여기서는 VQ-regularized 설정을 사용했다고 명시

- 조건 입력(semantic map)은

- 다운샘플된 버전을 만들어

- latent 이미지 표현과 함께 concat하여 입력 구성

학습 해상도

- 입력 해상도 256²로 학습 / 단, 원 데이터는 384²에서 crop한 256²를 사용

3) 관찰: 256² 학습 → 더 큰 해상도로 일반화

- 학습은 256²에서 했지만,

- 모델이 더 큰 해상도로 일반화하며

- convolutional manner로 평가하면 메가픽셀 수준까지 생성 가능

4) 확장 적용: super-resolution & inpainting에서도 큰 이미지 생성

- convolutional evaluation 성질을 이용해 4.4의 super-resolution 모델, 4.5의 inpainting 모델

에도 적용 - 결과적으로 512² ~ 1024² 범위의 큰 이미지를 생성하는 데 사용

5) 중요한 기술적 포인트: latent 스케일이 만드는 SNR 영향

큰 해상도 생성에서 결과 품질은 latent space 스케일이 유도하는 signal-to-noise ratio(SNR)의 영향을 크게 받는다고 강조

4.4. Super-Resolution with Latent Diffusion

1) 핵심 방법: 저해상도 이미지를 direct conditioning (concat)으로 사용

- Super-resolution을 위해 LDM을 학습할 때, 저해상도 입력 (y)를 UNet 입력에 concatenate하여 조건으로 줌(conditioning 아이디어를 concat 형태로 적용)

- 이 설정에서는 (\tau_\theta)가 별도 인코더가 아니라 identity(그대로 전달)로 동작한다고 명시.

2) 실험 1: SR3 설정을 따라간 ImageNet 64→256 (bicubic 고정 열화)

열화(degradation) 설정

- SR3를 따라, 열화를 bicubic interpolation + 4× downsampling으로 고정

학습 데이터/파이프라인

- ImageNet을 SR3의 데이터 처리 파이프라인대로 사용

오토인코더/latent 설정

- (f=4) autoencoding 모델 사용

- OpenImages에서 pretrained

- VQ-regularized

조건 주입 방식

- 저해상도 조건 (y)를 UNet 입력과 concat

- (\tau_\theta = \text{identity})

3) 결과 요약: LDM-SR vs SR3 vs “단순 회귀” 베이스라인

LDM-SR vs SR3

- Fig. 9, Tab. 4 기준으로

- LDM-SR이 FID에서 SR3보다 우수

- SR3가 IS에서는 더 우수

- 정성적 코멘트

- LDM-SR: 현실적인 텍스처 렌더링에 장점

- SR3: 세밀 구조(fine structures)의 일관성(coherence)이 더 좋을 수 있음

단순 이미지 회귀(image regression) 모델

- PSNR/SSIM은 가장 높게 나올 수 있다고 언급

- 주의점:

- PSNR/SSIM은 인간 지각과 잘 정렬되지 않음

- 특히 블러를 선호하고, 정렬이 완벽하지 않은 고주파 디테일을 불리하게 평가하는 경향이 있어(super-resolution 맥락에서 한계)

4) 사용자 연구(user study): 픽셀 베이스라인 vs LDM-SR

- SR3 논문 방식과 동일한 프로토콜을 사용: 피험자에게 저해상도 이미지 1장을 가운데 보여주고 양쪽에 고해상도 후보 2장을 제시한 뒤 선호(preference)를 선택하게 함

- 결과: LDM-SR의 성능이 좋다는 점을 선호 실험으로 확인했다고 서술

5) 추가 개선: post-hoc guiding으로 PSNR/SSIM 향상 가능

- PSNR/SSIM은 사후 가이딩(post-hoc guiding mechanism)으로 더 끌어올릴 수 있다고 언급

- 구현 방식: perceptual loss 기반의 image-based guider로 구현

6) 일반화 이슈와 대응: bicubic 열화의 한계 → LDM-BSR

- bicubic 고정 열화는 그 전처리를 따르지 않는 이미지에 대해 일반화가 약함

- 따라서 더 다양한 열화(degradation)를 사용해 generic 모델 LDM-BSR를 추가로 학습

- 결과는 뒤에 제시

4.5. Inpainting with Latent Diffusion

1) 태스크 정의: Inpainting

- inpainting = 이미지의 마스킹된 영역을 새로운 내용으로 채우는 작업

- 손상/오염된 부분 복구

- 또는 원치 않는 객체/부분을 대체

2) 평가 기준: LaMa 프로토콜(특화 SOTA와 비교)

- 조건부 이미지 생성에 대한 “일반적 접근”으로서 LDM이 더 특화된 SOTA inpainting 모델들과 어떻게 비교되는지 평가

- 비교 기준/프로토콜:

- LaMa(Fast Fourier Convolutions 기반 특화 아키텍처를 도입한 inpainting 모델)

- Places 데이터셋에서의 훈련/평가 프로토콜을 따름

3) 1단계(오토인코더) 설계 선택이 inpainting 효율에 미치는 영향 분석

비교 모델 구성

- LDM-1: 픽셀 기반 conditional DM

- LDM-4: latent 기반(LDM) — 여기서 1단계 정규화/구조를 다르게 비교

- KL-reg LDM-4

- VQ-reg LDM-4

- VQ-LDM-4 (1단계에 attention 없는 버전)

- 목적: 고해상도 디코딩 시 GPU 메모리 감소

공정 비교

- 모든 모델의 파라미터 수를 동일하게 고정

4) 효율/품질 지표

Tab. 6:

- 해상도 256², 512²에서의

- 학습 처리량(training throughput)

- 샘플링 처리량(sampling throughput)

- 에폭당 총 학습 시간(시간 단위)

- 6 에폭 후 validation split에서의 FID

핵심 결론(정량 요지)

- 픽셀 기반 vs latent 기반 비교에서:

- 최소 2.7× 속도 향상(speed-up)

- 동시에 FID는 최소 1.6× 개선(더 낮아짐)

5) LaMa와의 직접 비교

FID (품질)

- attention을 포함한 LDM이 LaMa보다 FID 기준 전체 이미지 품질을 개선

LPIPS (원본(비마스크 영역) 유사도)

- 비마스크 영역과 샘플 간 LPIPS가 LaMa보다 약간 더 높음(=덜 유사)

- 논문 해석(원인 설명):

- LaMa는 단일 결과만 생성 → 평균적인 이미지로 “복구”되는 경향

- LDM은 다양한 결과를 생성 → 평균에 덜 수렴하고 다양성이 커질 수 있음

- 사용자 선호 실험에서 사람들은 LaMa보다 LDM 결과를 선호

6) “더 큰 모델(big)” 실험: latent에서 확장 + 512² 파인튜닝으로 SOTA

확장 모델(big)

- latent space에서 더 큰 diffusion 모델을 학습

- 1단계는 VQ-regularized + (1단계) attention 없음 latent를 사용

- diffusion UNet 구조 특징(선행 방식 참고):

- feature hierarchy 3 레벨에 attention layers 사용

- BigGAN residual block으로 up/downsampling

- 파라미터 규모:

- 기존 215M → 387M

해상도 불일치 문제

- 학습 후 256²와 512²에서 샘플 품질 차이가 나타남

- 논문 가설: 추가 attention 모듈이 feature 통계 변화에 민감했을 가능성

해결: 512²에서 짧은 파인튜닝

- 512² 해상도에서 반 에폭(half epoch) 파인튜닝 / 새로운 feature 통계에 적응하도록 조정

- 결과:

- image inpainting에서 새로운 SOTA FID 달성

5. Conclusion

- LDM을 단순(simple)하고 효율적(efficient)인 방법으로 제시

- 목표 달성:

- denoising diffusion model의 training efficiency 향상

- sampling efficiency 향상

- 동시에 품질(quality) 저하 없이 성능 유지/개선

- LDM 자체의 효율성에 더해 cross-attention conditioning 메커니즘을 결합

- 그 결과 다양한 조건부 이미지 합성(conditional image synthesis) 태스크에서 SOTA 방법들과 비교해 유리한(favorable) 결과를 실험적으로 확인했다고 서술

- 성능을 낸 이유가 태스크별로 특수 아키텍처를 붙였기 때문이 아니라 task-specific architectures 없이도 광범위한 조건부 생성 과제를 커버했다는 점