논문링크: https://arxiv.org/abs/2010.02559

LEGAL-BERT: The Muppets straight out of Law School

BERT has achieved impressive performance in several NLP tasks. However, there has been limited investigation on its adaptation guidelines in specialised domains. Here we focus on the legal domain, where we explore several approaches for applying BERT model

arxiv.org

0. ABSTRACT

- 법률 도메인에 BERT를 적용하는 다양한 방법을 실험하고, 여러 법률 데이터셋에서 성능을 평가함

- 기존의 pre-training 및 fine-tuning 전략이 법률 도메인에 항상 잘 일반화되지 않음을 발견

- 따라서 전문 도메인에서의 BERT 활용 전략을 세 가지로 구분해 체계적으로 분석함

- 또한 downstream task를 위한 fine-tuning 시 hyperparameter 탐색 범위를 확장할 필요성도 강조함

1. Introduction

- BERT 및 그 변형 모델(RoBERTa, ALBERT 등)은 일반 NLP 벤치마크(GLUE, SQuAD 등)에서 최고 성능을 달성

- 일반적으로 NLP 작업은 두 단계로 구성됨:

- Pre-training: 대규모 일반 코퍼스에서 언어 모델을 사전 학습 (비용 큼)

- Fine-tuning: 다운스트림 작업에 맞게 조정 (비용 적음)

- 공개된 BERT 모델 덕분에 pre-training을 생략하고 바로 fine-tuning이 가능함

- 그러나 BERT는 일반 도메인(위키백과 등) 기반으로 학습되어, 법률·의료·과학 등 특수 도메인에선 성능 저하 현상이 있음

<연구 목적>

법률 도메인에서 BERT 적용 전략을 다음 3가지로 구분하여 체계적으로 분석

- (a) Out-of-the-box: 기존 BERT를 그대로 사용

- (b) Further Pre-training (FP): 기존 BERT를 법률 도메인 코퍼스로 추가 학습

- (c) From-scratch Pre-training (SC): 법률 도메인 코퍼스로 처음부터 BERT를 새롭게 학습 (vocab 포함)

<법률 언어의 특성>

- 법률 텍스트(법령, 판례, 계약서 등)는 일반 언어와 다르게

- 전문화된 어휘

- 형식적이고 복잡한 문장 구조

- 도메인 지식 기반 의미 해석

- 따라서 법률 언어는 종종 "하위 언어(sublanguage)”로 간주됨.

<주요 결과>

- (b) FP 및 (c) SC가 (a)보다 높은 성능을 보임

- Fine-tuning 시 hyperparameter 탐색 범위를 넓히는 것이 성능 개선에 효과적

- 작은 크기의 BERT 모델도 충분히 경쟁력 있음

- 법률 NLP 및 Legal Tech를 위한 LEGAL-BERT 모델군 공개

- ex) LEGAL-BERT-SMALL → 성능은 유사하지만, 연산 속도는 약 4배 빠르고 에너지 효율도 높음

2. Related Work

- 대부분의 BERT 도메인 적응 연구는 의료(biomedical) 또는 과학(scientific) 도메인에 집중

- 제안된 세 가지 전략 (a~c)에 대한 체계적인 비교 연구는 거의 없음

<기존 연구의 한계점>

- Pre-training step 수에 따른 영향 분석 부족

- Fine-tuning 시 hyperparameter 탐색 부재

- 경량 모델(small BERT)의 효율성 분석 없음

- 특수 도메인에서는 굳이 큰 모델이 필요하지 않을 수 있음

- 법률·의료 등은 문장 구조가 표준화, 주제 범위가 좁음, 어휘 중의성 낮기 때문

- 법률 도메인에 특화된 BERT 적응 연구는 전무함

- 기존 연구들은 legal NLP에서 BERT를 사용하긴 했지만, 도메인 적응(adaptation) 자체를 다루진 않음

3. LEGAL-BERT: A New Family of BERT Models for the Legal Domain

학습 데이터 (Training Corpora)

- LEGAL-BERT 시리즈를 학습하기 위해, 법률 도메인 텍스트 12GB 수집

- 자료 출처: 공개된 법령, 판례, 계약서 등 다양한 분야의 영문 법률 문서

1) LEGAL-BERT-FP (Further Pre-trained)

- BERT-BASE를 법률 코퍼스로 추가 사전학습 (FP 전략)

- Devlin et al. (2019)의 권장 기준(최대 100k step)을 참고

- 최대 500k step까지 추가 학습해, fine-tuning 시 장기 학습 효과를 실험

- 기존 BERT-BASE는 Wikipedia, Children's Books 등 일반 도메인 기반으로 사전학습 → 30k sub-word vocab이 일반 텍스트에 최적화되어 있음

- 따라서 법률 도메인에선 추가 학습이 필수적이라고 판단

2) LEGAL-BERT-SC (From-Scratch Pre-trained)

- 처음부터 법률 데이터로 BERT를 학습 (SC 전략)

- 구조는 BERT-BASE와 동일:

- 12 layers, 768 hidden units, 12 attention heads

- 총 110M 파라미터

- vocabulary도 새로 생성하며, 크기는 기존 BERT vocab과 동일 (30k sub-words)

3) LEGAL-BERT-SMALL (경량 모델 실험)

- SC 구조 기반의 경량화 모델도 실험

- 6 layers, 512 hidden units, 8 attention heads

- 총 35M 파라미터 (BERT-BASE의 약 32% 크기)

- 특징:

- 학습 속도 약 4배 빠름

- 하드웨어 자원 소모 적음

- 가설: 매개변수는 적지만 도메인 특화된 구조 덕분에 일반 BERT와 유사한 성능 가능

4. Experimental Setup

<Pre-training 설정>

- 총 학습 step: 1M step (약 40 epoch), BERT와 비교 가능하도록 설정

- Batch size: 256

- 토큰 길이 제한: 최대 512 SentencePiece 토큰

- Optimizer: Adam (learning rate = 1e−4)

- 학습 환경: Google Cloud TPU v3 (8 cores)

- 코드 베이스: 공식 BERT 코드 사용

<평가 대상 Legal NLP Tasks>

모델 성능은 텍스트 분류 및 시퀀스 태깅(task) 기준으로 평가함. 사용한 데이터셋은 아래의 3가지

- EURLEX57K

- EU 법령 문서 기반의 대규모 멀티라벨 분류 데이터셋

- Few-shot 및 Zero-shot 학습에도 적합

- ECHR-CASES

- 유럽인권재판소(ECHR) 판례 기반

- 이진 및 멀티라벨 분류 작업에 활용

- CONTRACTS-NER

- 미국 계약서 문서 기반 개체명 인식(NER) 데이터셋

- 3가지 하위 영역 포함: 계약 헤더, 분쟁 조항, 임대 상세

* 모든 데이터셋에 대해 Chalkidis et al. (2019) 방식의 fine-tuning 실험 재현

<Fine-tuning 전략: "Tune your Muppets!">

- 기존 Devlin et al. (2019)의 fine-tuning 설정은 다음과 같음:

- Learning rate ∈ {2e−5, 3e−5, 4e−5, 5e−5}

- Epochs ∈ {3, 4}

- Batch size ∈ {16, 32}

- Dropout = 0.1 (고정)

- 그러나 해당 범위는 과학적 근거가 부족하며, 대부분의 연구에서 그대로 따라만 옴

< LEGAL-BERT에서의 Hyperparameter 탐색 개선 >

- Batch size 범위를 {4, 8, 16, 32}로 확장 (데이터셋 크기가 작기 때문)

- Epoch 수 제한 없이 Early Stopping 적용

- 기존 최대 4 epoch로는 underfitting 발생하는 경우 있음

- 추가 실험 설정:

- Learning rate = 1e−5 도입 (local minima overshooting 방지)

- Dropout = 0.2 도입 (regularization 개선 목적)

Figure 4에 따르면, 이와 같은 grid-search 기반 튜닝 전략이 Devlin et al. (2019)의 기본 설정보다 성능에 유의미한 영향을 줌 → LEGAL-BERT 실험 전체에 이 전략을 채택함

5. Experimental Results

<Pre-training 결과>

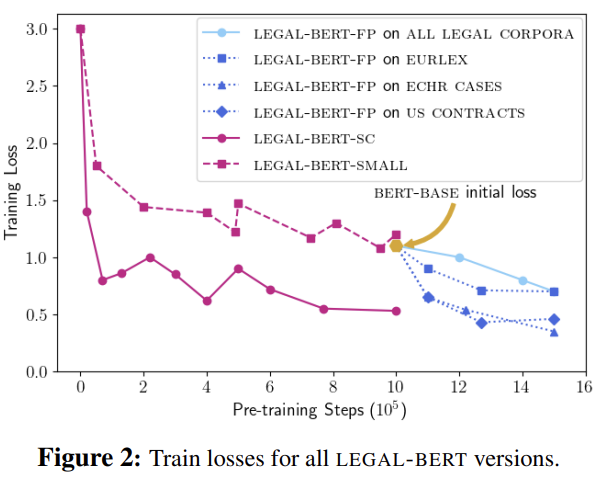

- Figure 2: LEGAL-BERT 전 모델의 pre-training loss 변화 시각화

1) LEGAL-BERT-SC

- 가장 낮은 pre-training loss 달성 → 가장 좋은 학습 품질

- LEGAL-BERT-SMALL보다 성능 우위, 이는 모델 크기 차이로 예상된 결과

2) LEGAL-BERT-SMALL

- 최종 pre-training 시점에서의 loss는 일반 도메인에서 학습된 BERT-BASE와 유사 → 경량 모델이지만 최소한의 도메인 적응 효과 있음

3) LEGAL-BERT-FP

- 전체 법률 코퍼스보다는 특정 서브도메인(ECHR, US contracts)에 대해 더 빠르게 적응함

- 일부 작업에서는 LEGAL-BERT-SC보다 높은 초기 적응력 보임

- 하지만 장기적으로는 LEGAL-BERT-SC가 더 낮은 loss 기록

< End-task 결과 >

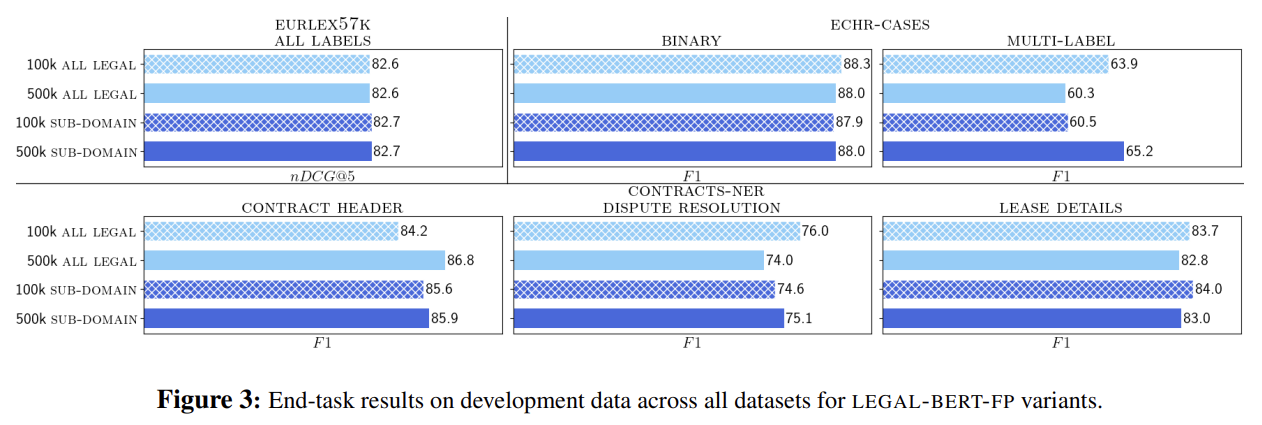

- Figure 3: LEGAL-BERT-FP 각 변형 모델의 개발용 데이터 성능 비교

- 각 데이터셋에 대해 가장 성능이 좋은 LEGAL-BERT-FP variant만 이후 실험에 사용

- Figure 4: 테스트 데이터 기준 perplexity & 성능 비교 (최소, 최대, 평균값 포함)

Task / Dataset LEGAL-BERT 효과 요약

| EURLEX57K | - 성능 향상 미미 (최대 +0.2%) - Perplexity 감소도 작음 (–2.7) → 일반 BERT도 꽤 잘 작동하는 도메인 |

| ECHR-CASES | - Binary 분류: +0.8% 향상 - Multi-label 분류: +2.5% 향상 - Perplexity 소폭 감소 (–1.1) → 도메인 적응의 효과 확인됨 |

| CONTRACTS-NER | - Perplexity 크게 감소 (–5.6) - F1 점수 향상: • 계약 헤더: +1.8% • 분쟁 조항: +1.6% • 임대 상세: +1.1% → LEGAL-BERT가 실질적으로 성능 개선에 기여 |

4) LEGAL-BERT-SMALL 성능 요약

- 대부분의 데이터셋에서 LEGAL-BERT와 유사한 성능 달성

- 장점:

- GPU 메모리 친화적

- 저사양 환경에서도 사용 가능

- 예: ECHR-CASES에 BERT를 계층 구조(hierarchical)로 적용 시 메모리 사용량 4배 증가

→ LEGAL-BERT-SMALL은 이런 구조에 효율적인 기반 제공 가능

<결론 요약>

- LEGAL-BERT는 도메인 특화 NLP 작업에 실질적인 성능 향상을 보여줌

- 특히 계약서 정보 추출, 다중 레이블 분류 등의 어려운 작업에서 도메인 적응 효과 큼

- 경량 모델(LEGAL-BERT-SMALL)도 강력한 대안으로, 자원이 제한된 환경에서도 활용 가능

6. Conclusions and Future Work

- 도메인 적응 전략은 일괄적으로 적용할 수 없음

- 상황에 따라 further pre-training (FP) 또는 from-scratch pre-training (SC) 중 선택 필요

- 우리는 법률 도메인 전용 BERT 모델군 LEGAL-BERT를 공개함

- 3개 legal NLP 작업에서 최신(state-of-the-art) 성능 달성

- 특히 복잡한 작업(ECHR의 multi-label 분류, 계약서 정보 추출)에서 도메인 적응의 효과가 큼

- LEGAL-BERT-SMALL도 함께 공개

- 모델 크기는 1/3 수준이지만, 성능은 LEGAL-BERT과 경쟁 가능

- 저자원 환경에서 쉽게 적용 가능

- Fine-tuning 시 확장된 grid search는 성능 향상에 중대한 영향을 미침

→ 향후 모든 BERT fine-tuning 시 적극 도입 권장

'NLP' 카테고리의 다른 글

| [2025-2] 박제우 - GRAPH ATTENTION NETWORKS (0) | 2025.07.13 |

|---|---|

| [2025-2] 정유림 - BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding (1) | 2025.07.13 |

| [2025-2] 김지원 - From Transcripts to Insights:Uncovering Corporate Risks UsingGenerative AI (0) | 2025.07.13 |

| [2025-1] 임준수 - Self-Adapting Language Models (0) | 2025.07.10 |

| [2025-1] 정유림 - Attention Is All You Need (0) | 2025.05.29 |