https://www.youtube.com/watch?v=S2dXWVzzK2Y&list=PL_iJu012NOxehE8fdF9me4TLfbdv3ZW8g&index=22

Markov Decision Process.

강화학습의 목표는 action의 반복을 통해 목표(Maximize Expected Return)에 다가가는 것이다. 즉, 기댓값이 최대가 되도록 하는 것이다. 이는 에이전트가 환경과 상호작용하면서 적절한 행동을 선택해 누적 보상을 최대화하려는 것으로 이해할 수 있다.

* 누적 보상 = 𝐺0 = 𝑅0 + 𝛾𝑅1 + 𝛾^2𝑅2 + …

Value-based의 목표.

Value-based는 상태(state) 또는 상태-행동(state-action) 쌍에 대한 값을 학습하는 데 초점을 두는 방법이다. 예를 들어 ①State Value 𝑉(𝑠)는 특정 상태 𝑠에서 시작해 최적으로 행동했을 때의 기대 보상을 의미하며, ②Action Value 𝑄(𝑠,𝑎)는 상태 𝑠에서 행동 𝑎를 수행했을 때의 기대 보상을 의미한다. 이처럼 Value-based 방법은 행동 정책을 명시적으로 나타내지 않고, 𝑄(𝑠,𝑎) 또는 𝑉(𝑠) 값을 기반으로 최적의 행동을 선택한다. 결론적으로 Value-based의 목표는 이러한 값을 정확히 학습해 최적의 정책을 간접적으로 도출하는 것이라고 이해할 수 있다. Value-based 방법의 대표적인 알고리즘 예시로는 Q-learning과 Deep Q-Networks(DQN) 등이 있다.

Policy-based의 목표.

Policy-based 방법의 목표는 정책을 직접 학습하는 것이다. 여기서 정책은 상태를 행동으로 매핑하는 함수 𝜋(𝑎∣𝑠;𝜃)으로 나타난다.

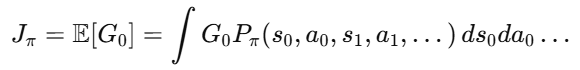

위 식은 주어진 정책 𝜋에 따라 에이전트의 기대 누적 보상을 나타내는 식으로, "강화학습에서 에이전트가 𝜋라는 정책을 사용할 때, 얻을 수 있는 모든 가능한 보상들의 평균값"으로 그 의미를 이해해볼 수 있다. 이 과정을 통해 에이전트는 주어진 환경에서 가장 높은 보상을 받을 수 있는 방법을 배우게 된다.

* G0: 시간 𝑡=0부터 시작해 에이전트가 수행한 행동으로 얻는 누적 보상

* Pπ(s0, a0, s1, a1, …): 정책 𝜋에 의해 결정되는 상태와 행동의 확률 분포

* ∫𝑑𝑠0𝑑𝑎0 …: 상태와 행동의 모든 가능한 경우를 고려해 기대값을 계산하는 과정

따라서 Policy-based 방법은 𝐽𝜋를 직접 최대화하는 데 초점을 두며, 이를 위해 정책의 매개변수 𝜃를 업데이트하며 최적화한다. Policy-based 방법의 대표적인 알고리즘 예시로는 REINFORCE와 Actor-Critic 등이 있다.

Policy Network.

Policy Network는 강화학습에서 행동 정책 𝜋(𝑎∣𝑠;𝜃)을 직접 학습하는 데 사용되는 신경망 구조이다. 이 네트워크는 상태(state)를 입력으로 받아 특정 행동(action)을 수행할 확률을 출력한다. Policy Network의 구조 및 작동 원리는 아래와 같다.

ⓐ입력: 현재 상태 𝑠𝑡가 주어진다.

ⓑ네트워크 처리: 상태를 입력받아, 최적의 행동 확률 분포 𝜋(𝑎∣𝑠;𝜃)를 출력한다.

ⓒ출력: 행동 𝑎𝑡를 샘플링하거나, 확률적으로 결정된 행동을 선택한다.

Policy Network의 장점으로는 ①연속적인 행동 공간 처리 가능, ②확률적 행동 학습(확률 분포를 학습하기 때문에 Exploration과 Exploitation을 자연스럽게 조절 가능), ③복잡한 정책 표현 가능(단순한 Value-based 접근법보다 복잡한 환경에서도 더 유연하게 작동) 등이 있다. Policy Network 방법의 대표 알고리즘으로는 REINFORCE(단순한 정책 그래디언트 방법), Actor-Critic, PPO(Proximal Policy Optimization) 등이 있다.

정리.

* 강화학습의 목표: 에이전트가 정책을 통해 적합한 행동을 학습하고, 누적 보상을 최대화.

* Value-based: 상태-행동 값을 학습해 최적 행동을 간접적으로 결정.

* Policy-based: 정책을 직접 학습하며 기대 보상을 최대화.

* Policy Network: 정책을 신경망으로 모델링해 행동을 확률적으로 출력.

'Miscellaneous' 카테고리의 다른 글

| [2025-1] 김은서 - Actor-Critic (0) | 2025.01.26 |

|---|---|

| [2025-1] 김지원 - Efficiently Modeling Long Sequences with Structured State Spaces (0) | 2025.01.25 |

| [2025-1] 정지우 - Dueling Network Architectures for Deep Reinforcement Learning (1) | 2025.01.22 |

| [2025-1] 김학선 - Policy Gradient (0) | 2025.01.20 |

| [2025-1] 노하림 - PER: Prioritized Experience Replay (0) | 2025.01.19 |