https://www.cs.toronto.edu/~hinton/absps/reluICML.pdf

- Restricted Boltzmann Machine(RBM)

- 보통 generative model이라고 하는데 ANN, DNN, CNN, RNN 등과 같은 deterministic model들과 다른 목표를 가짐 → deterministic model들은 타겟과 가설 간의 차이를 줄여서 오차를 줄이는 것이 목표 , generative model들의 목표는 확률밀도 함수를 모델링하는 것

- https://angeloyeo.github.io/2020/10/02/RBM.html

- RBM은 이렇듯 확률분포(정확하게는 pdf, pmf)를 학습하기 위해 만들어졌다고 할 수 있다

- RBM의 구조-> 많은 RBM의 연구에서 visible unit, hidden unit은 0 또는 1 상태만 갖는 RBM을 다룬다

- → RBM이 어떤 주어진 데이터를 잘 학습했다면 sampling을 통해 얻은 visible layer의 데이터가 원래 데이터와 거의 같아야 함

- Contrastive Divergence(CD)

- : visible layer에 데이터를 주고 hidden layer의 node 값을 샘플링, 그런 다음 다시 visible layer의 데이터를 다시 예측하도록 하는 과정에서 처음 주어진 visible layer의 데이터와 다시 획득한 visible layer의 데이터가 얼마나 차이가 있는지를 말하는 것 → 결국 RBM에게 학습이란 CD를 줄이는 것

- weight & bias : https://jh2021.tistory.com/3

- Translation equivariance & invariance : https://aibroker.tistory.com/entry/Paper-Reading2-Transforming-Auto-Encoder-Background-Translation-Equivariance-vs-Invariance

- Gaussian units

- 픽셀 같은 실수값(연속적인 값을 취하는 RBM)을 다루기 위해 binary visible units를 독립적인 가우시안 노이즈로 선형 단위로 대체함

- Rectified linear units

- 특징

- 연속값을 취하는 RBM은 visible층에는 가우시안 , hidden 층에는 ReLUf를 활성화 함수로 쓴다

- 입력값이 양수일 때만 활성화되는 선형 단위

- 선형 변환에 의해 입력값이 스케일링 되는 경우에도 활성화 패턴이 보존되는 특징이 있다.

- intensity equivariance (bias 0, noise-free인 경우)

- 특징

- Jittered-Cluttered NORB

-

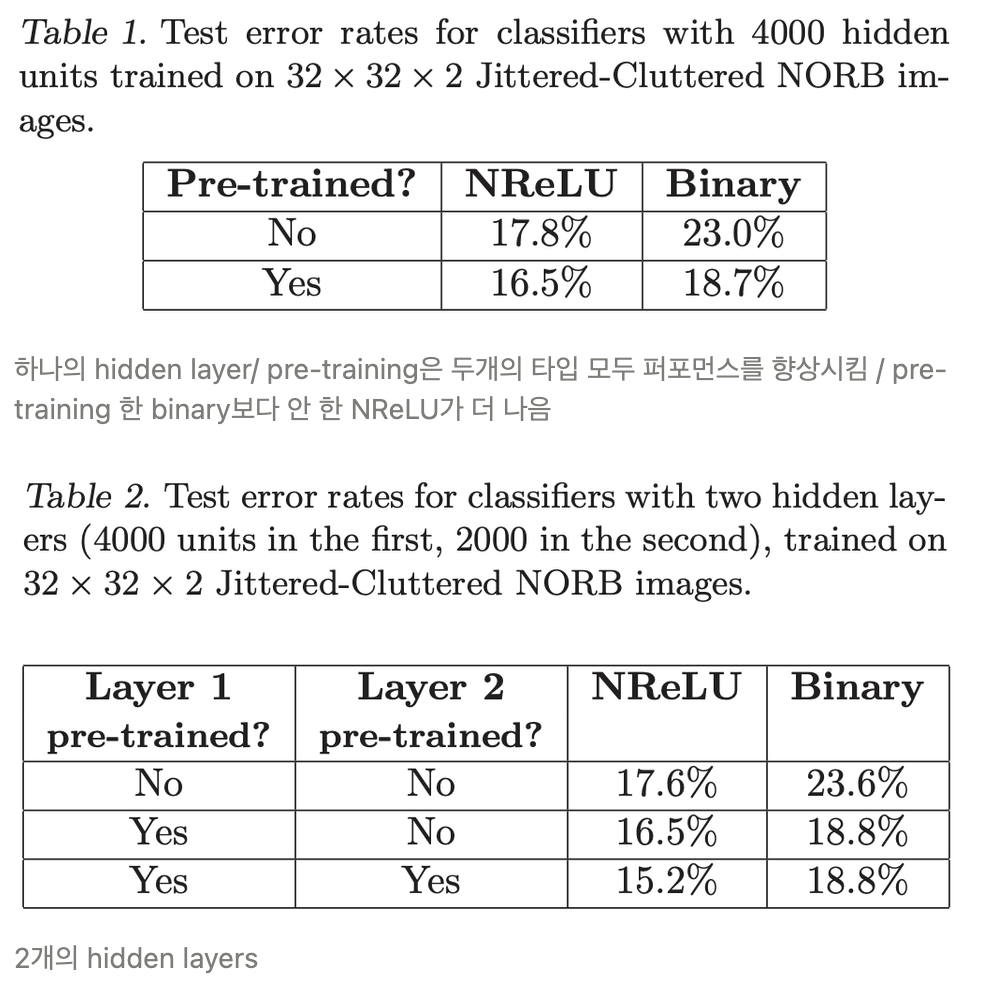

- 분류기를 훈련시키기 위해 RBM을 사용한다. 먼저,CD를 사용하여 두 개의 특징 레이어를 사전 훈련하고, 그런 다음 가장 상위의 숨겨진 레이어에서 다항 회귀를 사용하여 라벨을 예측하고, 분류기의 모든 레이어의 매개 변수를 식별적으로 조정합니다. pixel들(입력)은 가우시안 유닛으로 표시되며, hidden units은 NReLUs(Noisy Rectified Linear Units) 또는 stochastic binary units으로 표시 → pre-training은 300 epochs 수행

- 유닛이 항상 활성화된다면, 그것은 결국 히스토그램의 맨 오른쪽에 있다. 항상 활성화되는 유닛은 절대 보정되지 않기 때문에 순수하게 선형이다.

- Classification Resultstraning

-

- Labeled Faces in the Wild

- : 3D 객체 인식을 위한 데이터셋 중 하나로, NORB 데이터셋은 신경망 및 기타 기계 학습 알고리즘의 성능을 평가하는 데 사용되는 표준화된 벤치마크로 널리 알려져 있다. (다섯개의 toy 범주 → 사람, 동물, 차, 비행기, 트럭, none) ⇒ 여기서는 2개의 얼굴 이미지가 input이면 동일한 얼굴인지 아닌지 예측하는 과제 (binary classifier)

- Network architecture

- Siamese architecture

- : 두 얼굴의 특징을 분리하여 동일한 특징 추출기(이 예제에서는 RBM으로 사전 훈련된 완전 연결 피드포워드 레이어)를 사용하여 각 얼굴에 대한 특징 벡터를 생성 → 두 개의 특징 벡터를 대칭 함수(여기서는 코사인 거리를 사용)를 사용하여 하나의 표현으로 결합하여 입력의 순서에 불변한 결과를 생성 → 이 표현을 사용하여 두 얼굴이 동일한 사람인지 여부를 결정하는 이진 분류 작업을 수행

- 모델 : NReLUsNReLUs는 입력의 스케일링에 대해 불변하고, 이러한 특성은 코사인 거리와 결합하여 전체 모델이 픽셀의 스케일링에 변하지 않게 한다

- : 특징 추출기를 정의

- trainingpre-training → pixel들(입력)은 가우시안 유닛으로 표시되며, hidden units은 NReLUs(Noisy Rectified Linear Units) 또는 stochastic binary units

- 분할의 훈련 세트에서 10,800개의 단일 얼굴을 사용하여 RBM의 피쳐 레이어를 사전 훈련하고, 그런 다음 페이스 쌍에 대해 매개 변수를 구분적으로 미세 조정하는 siamese 아키텍처에 이를 연결

- Classification Results