논문 소개

제목: LoBERT: Generative AI Foundation Model for Limit Order Book Messages(2025)

논문 링크: https://arxiv.org/pdf/2511.12563

논문 정보: LOB Level 3 시퀀스 데이터를 양자화 및 트랜스포머 모듈을 통해 모델링에 성공함

초록

금융 지정가 주문장(LOB)의 역학을 메시지 수준에서 모델링하는 것은 불규칙적인 이벤트 발생 시점, 급격한 시장 상황(regime) 변화, 그리고 고빈도 거래자들이 가시적인 주문 흐름에 보이는 반응 때문에 어렵다.

기존의 LOB 모델들은 복잡한 데이터 표현 방식을 요구하고 원래의 작업 외에는 적응성이 부족했다. 이러한 문제점을 해결하기 위해, 본 논문에서는 다운스트림 미세 조정에 적합한 범용 인코더 전용 LOB 데이터 기반 모델인 LoBERT를 제안한다.

LoBERT는 가격, 거래량, 시간의 연속적인 표현을 유지하면서 완전한 다차원 메시지를 단일 토큰으로 처리하는 새로운 토큰화 방식을 사용하여 기존 BERT 아키텍처를 LOB 데이터에 맞게 조정한다. 이를 통해 중간 가격 변동(mid-price movements) 및 다음 메시지 예측과 같은 작업에서 탁월한 성능을 달성하는 동시에 기존 방법에 비해 필요한 컨텍스트 길이를 줄인다.

1. Introduction

지정가 주문장(LOB)은 현대 디지털 시장의 초석으로서, 가격 발견의 주요 메커니즘이자 시장 유동성 및 위험을 나타내는 중요한 지표 역할을 한다. LOB 메시지 흐름을 정확하게 모델링하고 예측하는 능력은 시장 조성(market making), 최적 실행(optimal execution) 및 기타 고빈도 거래(high-frequency trade) 활동의 기반이 되기 때문에 매우 중요하다.

그러나 메시지 수준(message-level)에서 LOB를 모델링하는 것은 다음과 같은 독특하고 어려운 과제를 수반한다.

- 수백만 배에 달하는 극심한 시간 간격의 불규칙성

- 단일 메시지로 인한 연쇄 효과를 동반하는 급격한 체제 변화

- 거래 알고리즘이 서로의 행동에 반응하는 가시적인 LOB 메시지 흐름과의 상호 작용을 통해 이러한 역동성이 증폭되는 현상

LOB 메시지에 생성형 AI를 활용하면 LOB 시장의 가장 세부적인 데이터를 포착할 수 있다는 점에서 유망하지만, 기존의 생성형 접근 방식은 추론 속도가 느리고 적용 범위가 좁으며 각 메시지를 순차적으로 예측해야 하는 구성 요소로 분할해야 한다는 단점이 있다.

LoBERT의 네 가지 독창성

① 메시지당 하나의 토큰을 사용하는 토크나이저 측면(side), 유형(type), 대략적인 가격/거래량 정보(반올림 플래그 포함)를 통합하는 동시에, Piecewise Linear-Geometric(PLGS) 스케일링을 통해 가격, 거래량, 시간 정보를 연속적으로 유지한다. 기존 생성기들이 각 메시지를 22~24개의 하위 토큰으로 분할하여 발생하는 토큰 폭발 현상을 방지한다.

② 연속 시간 로터리 어텐션(continuous-time rotary attention)과 MMM Masked Message Modeling(MMM) 목표를 통해 BERT를 불규칙적인 이벤트 스트림에 맞게 조정한다. 메시지와 주변 스냅샷(snapshots)을 동시에 마스킹하여 레이블 유출을 방지한다.

③ 하이브리드 이산-연속 디코딩 헤드 토큰 bin을 사용하여 회귀변수를 제한하는 방식으로 결합 추론을 도입, 토큰 전용 또는 회귀변수 전용 방식보다 더 높은 주변 정확도를 제공한다.

④ 실질적인 효율성(efficiency)과 전이성(transfer) 메시지당 하나의 토큰만 예측함으로써 유효 컨텍스트 길이를 대략 10분의 1 수준으로 줄이며, 작은 작업별 헤드를 사용하여 다양한 다운스트림 작업에 깔끔하게 미세 조정된다.

2. Methodology

2.1 Message Preprocessing

LoBERT의 전처리 핵심 원리는 가장 흔한 메시지와 드물게 발생하는 메시지를 근사적으로 나타내는 이산 토큰을 생성하는 것이다. 예를 들어 "최적 가격보다 훨씬 높은 가격에 중간 거래량의 새로운 매도 주문"과 같은 양자화된 메시지다. 이러한 방식은 정보의 연속적인 표현과 결합되어, 이산 값의 어휘를 과도하게 확장하지 않고도 드문 값을 정확하게 찾아낼 수 있다.

① 가격 수준(Price Level)

각 메시지의 가격 수준은 최적 반대 가격(매도 주문의 경우 최적 호가, 매수 주문의 경우 최적 매도 호가)과의 틱 단위 고정 가격 차이로 변환된다. 이 가격 차이는 (0, 1, 2, 3, 5, 10) 레벨로 양자화되고, PLGS를 통해 $\tau_\text{start}=10$틱, $\tau_\text{max}=20$, $\tau_\text{clip}=1000$틱으로 스케일링된다. 스케일링 함수는 최대 스케일링 값의 50%에 해당하는 10틱까지는 선형적인 출력 증가를 생성하고, 그 이후에는 증가 속도가 기하급수적으로 감소하여 점근적 한계에 도달한다.

② 거래량(Volume)

볼륨은 동일한 양자화 방식 (0, 50, 100, 200)으로 처리된 후, PLGS를 통해 연속적인 스케일 값으로 복제된다 ($\tau_\text{start}=200$, $\tau_\text{max}=400$, $\tau_\text{clip}=1500$ 단위). 전체 볼륨 값의 60% 이상이 정확히 100 단위임을 관찰하여 양자화 레벨을 선택했다. 볼륨이 양자화된 레벨에 정확히 있는지를 나타내는 추가적인 이진 지표("Y" 또는 "N")도 포함시켜 추론 과정에서 원래 볼륨 값을 복원할 수 있게 한다.

③ 도착 시간(Arrival Time)

각 메시지의 도착 시간은 이전 메시지와의 시간 차이로 변환된다. 시간 차이 분포에서 두꺼운 꼬리 분포 외에는 명확한 반복 패턴을 찾지 못했기 때문에, $\tau_\text{start}=1\text{ms},\ \tau_\text{max}=50,\ \tau_\text{clip}=250\text{ms}$의 매개변수를 사용하여 PLGS로 스케일링한 연속 값으로만 표현한다. 최종 정규화된 값은 $[0, 1]$ 범위에 있다.

④ 토큰 결합

매수/매도 여부와 메시지 유형(새 주문, 수정, 삭제, 실행, 숨김 주문)은 양자화된 가격 차이 및 거래량 값, 그리고 거래량 라운드 지표와 함께 콜론 구분 기호를 사용하여 개별 토큰으로 결합된다. 이 프로세스는 학습 데이터에서 293개의 서로 다른 메시지 토큰(vocab size: 293)을 생성한다. 실행 메시지(유형 4)에는 항상 최적의 가격으로 발생하므로 가격 수준을 0으로 변환하는 특수 규칙이 적용된다.

2.2 Order Book Snapshot Preprocessing

LoBERT는 메시지와 함께 메시지 직후의 주문장 스냅샷을 처리한다. 단일 스냅샷은 상위 10개 매수 가격과 거래량, 그리고 상위 10개 매도 가격과 거래량에 해당하는 40개의 값으로 구성된다.

거래량은 지수 변환을 사용하여 스케일링된다:

$$v_\text{scaled} = 1 - e^{-v_\text{raw}/k}$$

여기서 $v_\text{raw}$는 주어진 가격 수준에서의 raw volume이고, $k=2000$은 변환 비율을 통제하는 스케일링 파라미터다. 이 방법은 무한한 거래량 값을 $[0, 1)$ 범위로 매핑하며, 극도로 큰 거래량에 대한 민감도는 점차 감소한다.

가격은 상대측 최적 호가와의 틱 거리로 정규화하고, 최대 거리 $\tau_\text{max}=20$틱에서 제한한 후 $[0, 1]$ 범위로 다시 정규화한다.

2.3 Model Architecture, Inputs and Outputs

LoBERT의 아키텍처는 PyTorch를 사용하여 구현된 기존 BERT 모델의 원칙을 기반으로 한다. 핵심적인 혁신은 다중 모달 임베딩 레이어다. 이 레이어는 네 가지 소스의 표현을 병합하여 LOB 데이터의 이산-연속 혼합 특성을 처리한다.

- 이산 메시지 토큰

- 연속 가격 차이

- 연속 거래량

- 선택적으로 학습된 게이팅 메커니즘을 통해 통합된 LOB 스냅샷 표현

이러한 임베딩들은 가산적으로 결합되어 각 위치에 대한 통합된 표현을 생성한다. 학습된 위치 임베딩 외에도, 연속적인 메시지 간의 누적 시간 차이를 기반으로 작동하는 **연속 회전 위치 임베딩(RoPE)**을 셀프 어텐션 메커니즘에 통합한다. 이를 통해 모델은 순차적 순서와 이벤트 간의 실제 시간적 거리를 모두 포착하여 시장 역학의 불균일한 특성을 해결한다.

트랜스포머 인코더는 여러 층으로 구성되며, 각 층은 멀티헤드 셀프 어텐션과 GELU 활성화 함수 및 중간 차원 확장을 사용하는 위치 기반 피드포워드 네트워크를 포함한다. 각 하위 층 뒤에는 층 정규화와 잔차 연결이 적용되며, 드롭아웃($p=0.1$)이 사용된다.

모델 출력은 여러 개의 특화된 헤드를 거친다:

- 이산 토큰 예측: 선형 분류 헤드 (교차 엔트로피 손실)

- 연속 값 처리: 세 개의 회귀 헤드 (가중 MSE 손실)

회귀 헤드들은 이중 입력(dual-input) 설계를 채택하여 토큰 예측 로짓과 최종 은닉 상태를 모두 연결함으로써 연속 출력을 생성할 때 이산 예측을 활용한다.

2.4 Training and Fine-tuning

훈련 방법론은 두 단계 전략을 채택한다.

1단계: Masked Message Modeling (MMM)

BERT의 Masked Language Modeling(MLM)과 유사한 MMM을 수행하여 시퀀스 내에서 무작위로 마스크된 메시지를 재구성할 수 있도록 양방향 LoBERT 모델을 훈련한다.

- 가격, 거래량, 시간에 대한 회귀 손실은 첫 번째 에포크 이후 거의 동일한 가중치를 갖도록 조정

- 토큰 예측 손실에는 메시지의 주요 특징을 식별하는 것의 중요성을 강조하기 위해 더 높은 가중치 부여

- 마스킹된 메시지가 스냅샷을 통해 유출되는 것을 방지하기 위해 스냅샷의 90%를 무작위로 마스킹

2단계: Fine-tuning

다음 메시지 예측 및 중간 가격 예측과 같은 작업을 위한 미세 조정 단계로, 이 단계에서는 모든 스냅샷이 모델에 표시된다.

3. Experiments and Results

데이터셋

구분 기간 설명

| 학습 | 2015.05.11 ~ 2015.09.01 | AAPL, INTC, MSFT, FB (80일) |

| 검증 | 2015.09.02 ~ 2015.09.16 | 10일 |

| 테스트 | 2015.09.17 ~ 2015.09.30 | 10일 |

전체 데이터셋은 512개의 메시지로 구성된 91만 9천 개의 중복되지 않는 시퀀스로 나뉜 4억 7천만 개의 메시지로 이루어진다.

학습 설정:

- 옵티마이저: AdamW (학습률 $5 \times 10^{-5}$, 가중치 감소 $0.01$)

- 학습률 스케줄: 코사인 어닐링 with Warm Restarts ($T_0=40,000$스텝, $T_\text{mult}=2$, 최소 학습률 $5 \times 10^{-6}$)

- 배치 크기 32, 10 에포크

3.1 Next-Message Prediction Experiment

사전 학습된 MMM 모델에 triangular 마스크를 적용하여 과거 메시지만 인식하도록 인과 모델링에 적용한다.

베이스라인:

- S5 모델 (nagy2023): Book Module 제외 시 120만 파라미터

- LOB 모델: Book Module 포함/미포함 모두 110만 파라미터

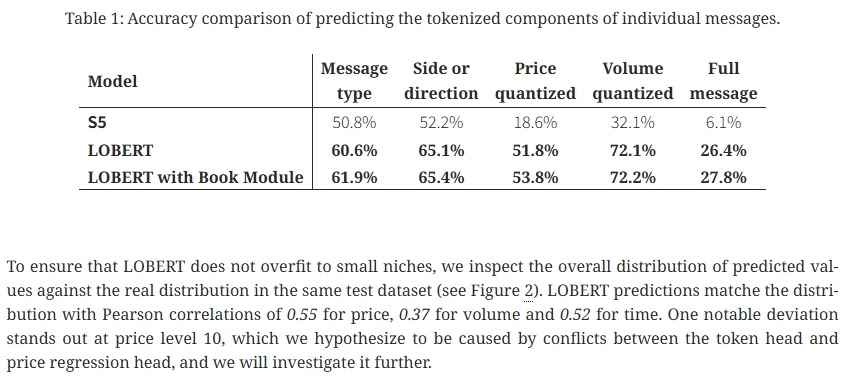

LoBERT 모델의 정확도는 개별 구성 요소별로, 그리고 전체 메시지를 고려했을 때에도 다른 모델보다 상당히 높다.

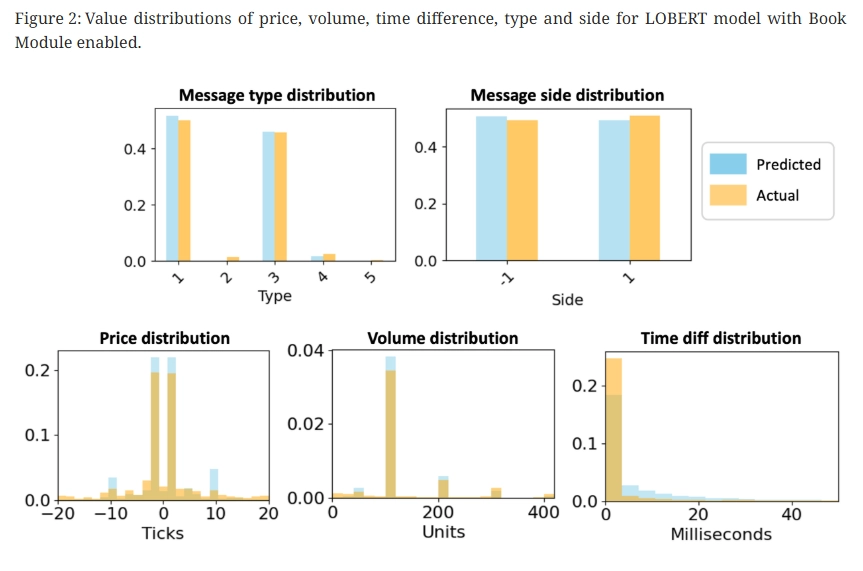

LoBERT 예측값은 실제 분포와 다음 피어슨 상관계수로 일치한다:

- 가격: 0.55

- 거래량: 0.37

- 시간: 0.52

가격 레벨 10에서 눈에 띄는 편차가 나타났는데, 이는 토큰 헤드와 가격 회귀 헤드 간의 충돌 때문일 가능성이 높으며 추가 조사를 진행할 예정이다.

3.2 Message Processing Comparison

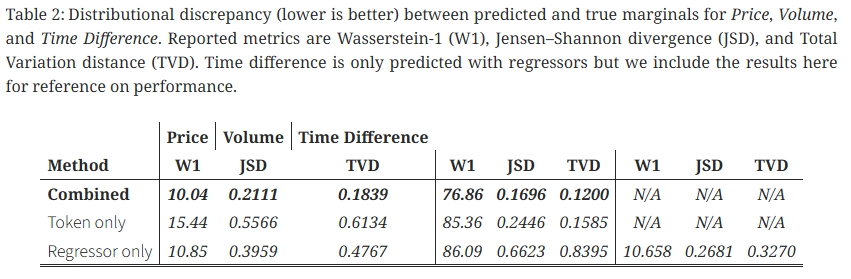

추론 시점에 이산 토큰 헤드와 연속 회귀 헤드를 활용하는 방식이 서로 다른 세 가지 메시지 처리 모드를 비교한다.

모드 설명

| Combined | 예측된 토큰의 양자화 범위를 회귀 변수의 하한 및 상한으로 사용 |

| Token only | 회귀 변수를 제외하고 예측된 토큰을 양자화된 가격(bin-start)과 거래량(bin-centre)에 매핑 |

| Regressor only | 토큰 예측을 무시하고 세 가지 회귀 분석 결과를 직접 사용 |

평가 지표: Wasserstein-1 거리(W1), Jensen-Shannon 발산(JSD), 총 변동 거리(TVD) — 모두 낮을수록 좋음

세 가지 변수와 세 가지 측정 기준 모두에서, Combined 모드가 두 가지 제거 방식에 비해 일관적으로 가장 작은 차이를 보인다. 토큰 헤드는 확률이 높은 구조적 모티프(측면/유형 및 대략적인 가격-거래량 분위수)를 포착하는 반면, 회귀 변수는 연속 잔차와 희귀 값을 정제하여 이산화 오류를 줄인다.

3.3 Mid-Price Prediction Experiment

MMM 사전 학습된 인코더 위에 분류 헤드를 추가하여 중간 가격 방향 예측에 적용한다.

설정:

시간 범위 집합 $H = {10, 50, 100}$개의 메시지로 설정하고, 평균 미래 틱 정규화된 중간 가격을 사용한다:

$$m_h(t) = \frac{1}{h} \sum_{i=1}^{h} m(t+i)$$

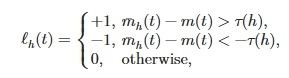

예측 레이블 $\ell_h(t)$는 다음과 같이 정의된다:

여기서 임계값은 로그적으로 증가한다:

$$\tau(h) = \frac{1}{1000} \cdot \text{round}\left(100\log_2\frac{h}{10}\right)$$

평균화는 종단(end-of-horizon) 라벨링에 비해 microstructure 노이즈를 감소시킨다.

평가: 선택적 예측 조건에서 매크로 F1 점수와 커버리지를 보고한다. 신뢰도 임계값 $\tau_c \in {0.3, 0.4, ..., 0.9}$를 초과하는 경우에만 예측을 수행한다.

LoBERT는 다양한 기간과 신뢰도 임계값에서 DeepLOB보다 일관되게 우수하거나 동등한 성능을 보인다. 특히 신뢰도 필터링에 민감하게 반응한다: $\tau_c$가 0.3에서 0.9로 증가함에 따라 매크로 F1 값이 현저하게 향상되는 반면($H=100: 0.55 \to 0.88$), 커버리지는 감소($1.00 \to 0.1$). 이는 쉬운 사례와 어려운 사례를 효과적으로 구분하고 있음을 나타낸다.

추론 속도: 현재 LoBERT의 추론 속도는 DeepLOB보다 53% 느리다. 하지만 Transformer 기반 아키텍처는 처리량을 몇 배로 늘릴 수 있는 다양한 메커니즘을 갖추고 있으며, 향후 버전에서 이를 구현할 계획이다.

4. Discussion and Conclusion

LoBERT에 대한 연구는 NLP 방법론을 LOB의 동적 모델링에 적용하는 데 상당한 잠재력이 있음을 보여준다. LOB 이벤트 스트림을 하나의 언어로 취급함으로써 BERT 아키텍처의 잘 확립된 패턴 인식 기능을 활용한다.

차기 메시지 및 중간 가격 예측 실험의 초기 결과는 고무적이며, 모델이 시장 데이터의 복잡한 "문법"을 실제로 학습할 수 있음을 시사한다. LoBERT 기반 모델은 약간의 미세 조정만으로 수많은 사용 사례에 적용할 수 있으며, 이는 최초의 BERT 모델이 언어 모델링을 혁신했던 것처럼 LOB 영역에서 완전히 새로운 방식을 제시한다.

한계점

- 현재 실험으로는 모델이 현실적인 장기 시퀀스를 생성할 수 있음을 보장할 수 없음

- LLM은 엔티티의 상태 변화를 추적하는 데 어려움을 겪는 것으로 알려져 있으며, LoBERT 또한 가격 변동 시 주문 규모와 위치를 추적하는 데 유사한 문제에 직면할 수 있음

- 현재 구현에서는 개별 주문 ID를 모델링하지 않음

- Transformer 아키텍처의 계산 비용과 추론 시간이 적지 않음

향후 연구 로드맵

- 모델의 생성 품질을 검증하기 위한 포괄적인 시퀀스 예측 실험 수행

- 미세 조정 범위 연구 확장

- 더욱 효율적인 어텐션 메커니즘과 향상된 학습 기법 도입

- 시간대, 현재 호가 스프레드, 전체 LOB 스냅샷과 같은 중요한 시장 상태 정보 통합