1. Introduction

대형 언어모델(LLM)의 성능이 빠르게 올라가면서, 기존의 벤치마크들은 점점 측정 도구로서 의미를 잃고 있다. 예를 들어, MMLU 같은 대표 벤치마크에서 최신 모델들이 90% 이상의 높은 정확도를 달성하면서, 모델이 더 좋아져도 점수는 그 개선을 충분히 반영하지 못한다. 이러한 문제를 본 논문에서는 "benchmark saturation"라고 명명한다.

이 문제의식에서 출발해 저자들은 Humanity’s Last Exam (HLE) 이라는 새로운 벤치마크를 제안한다. 이 벤치마크는 다음과 같은 조건을 만족한다.

- 광범위한 학문 커버리지(수학/자연과학/인문사회 등)

- 폐쇄형(close-ended): 정답이 명확히 존재하고 자동 채점이 가능

- 인터넷 검색으로 빠르게 해결되지 않음(retrieval 회피)

- 최신 프런티어 모델들도 낮은 정확도를 보일 만큼 어려움

2. HLE란?

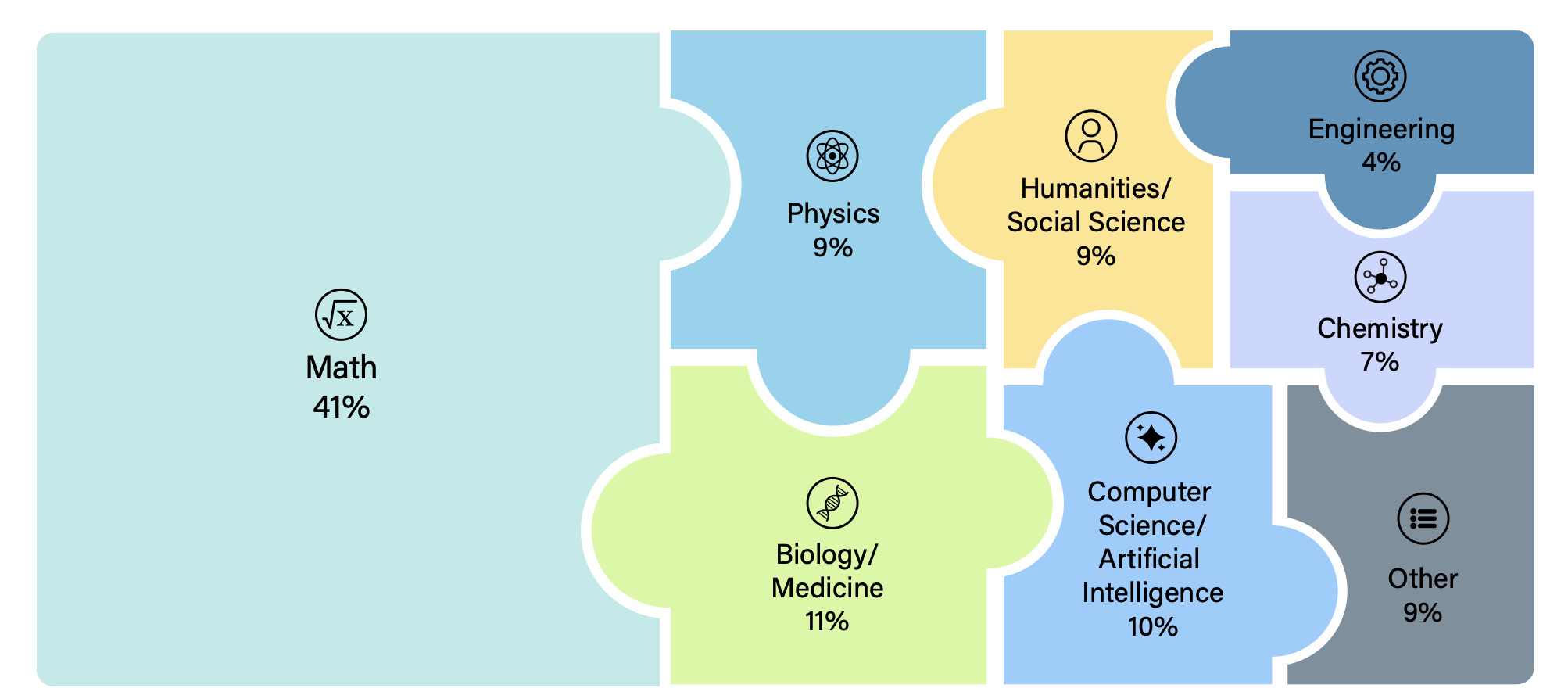

HLE는 총 2,500개의 매우 어려운 문제로 구성되며, 수십 개(논문 표현으로는 100+ subjects)의 학문 영역을 포괄한다. 수학, 인문학, 자연과학을 포함해 학문 전반의 폭을 놓치지 않으면서도, 목표 난이도는 학부 수준이 아니라 전문가/대학원 수준의 정밀한 지식과 추론을 요구하도록 설계되어 있다.

또 하나의 핵심은 멀티모달이다. 문제 중 약 14%는 텍스트+이미지 이해를 요구한다. 그리고 형식은 두 가지다.

- Exact-match(단답형/정확 문자열 매칭)

- Multiple-choice(객관식, 5개 이상 보기)

논문은 객관식 비중이 약 24%, 나머지가 단답형이라고 설명한다.

자동 채점 가능 + 정답의 명확성 + 검색 회피라는 목표를 동시에 잡기 위해 위와 같이 문제가 구성되어 있다. 정답이 모호한 서술형 에세이는 제외하고, 정답이 검증 가능하며(쉽게 채점 가능), 그러나 인터넷에서 바로 복붙해 오기 어려운 형태를 지향한다.

1) 문제 예시

2) 데이터셋 구성

보통 벤치마크는 사람이 어렵다고 생각하는 문제를 모아놓고 모델에 풀게 하는 반면 HLE는 컴퓨터가 어렵게 느끼는 문제를 모아 풀게 한다. 데이터셋은 다음과 같은 방식으로 구성한다.

- 최신 프런티어 LLM들을 먼저 시험한다.

- 모델이 풀어버리면 그 문제는 탈락한다.

- 모델이 못 푼 문제만 다음 단계(인간 전문가 리뷰)로 넘어간다.

논문에 따르면 이런 사전 검증(LLM difficulty check)을 통해 총 70,000 건 이상의 시도가 이루어졌고, 그 결과 모델이 잘 풀지 못한 문제들이 인간 전문가 리뷰로 넘어간다. 이후에는 두 단계의 리뷰 라운드가 있다.

- 1차: 여러 명의 대학원급 리뷰어가 문제를 검토하고 개선 피드백 제공(문제당 1~3개 리뷰)

- 2차: 우수 문제를 골라 조직자/전문가 리뷰어가 최종 승인

또한 공개 후 커뮤니티 리뷰 기간을 통해 오류 가능성을 점검하고, public set 외에 overfitting/gaming 점검을 위한 private held-out set도 유지한다.

3) 평가 방식

HLE는 폐쇄형 문제이지만, 실제 평가에서는 표현 차이가 발생한다. 예컨대 분수/소수, 근사값 표기, 동치 표현 등으로 모델 답이 맞아도 문자열이 다를 수 있다. 논문은 이를 해결하기 위해 정답 검증(judging) 과정에서 동치 표현을 고려하는 방식의 자동 채점을 사용한다. 또한 시스템 프롬프트를 통일해 모델이 “추론 + 최종 답” 형태로 출력하도록 설정했다고 한다. 이런 설정은 단순히 정확도만 보는 것이 아니라, calibration(자기 확신의 신뢰도) 평가로도 연결된다.

3. Conclusion

1) 벤치마크 실험 결과

최신 최첨단 모델을 HLE에 실험한 결과 대부분의 모델의 정확도는 전반적으로 매우 낮은데도 모델은 모르겠다고 인정하기보다 틀린 답을 높은 확신으로 말하는 경향이 강한 것으로 보였다. 논문은 이를 계량화하기 위해 “정답 + 확신도(0~100%)”를 함께 출력하게 하고, RMS calibration error로 평가한다. 이상적으로는 “확신 50%인 답들의 실제 정답률도 50%”에 가까워야 하지만, HLE에서는 프런티어 모델 전반이 높은 RMS 오차(70%대 이상) 를 보이며, 이는 과신 기반의 오류가 광범위함을 시사한다.

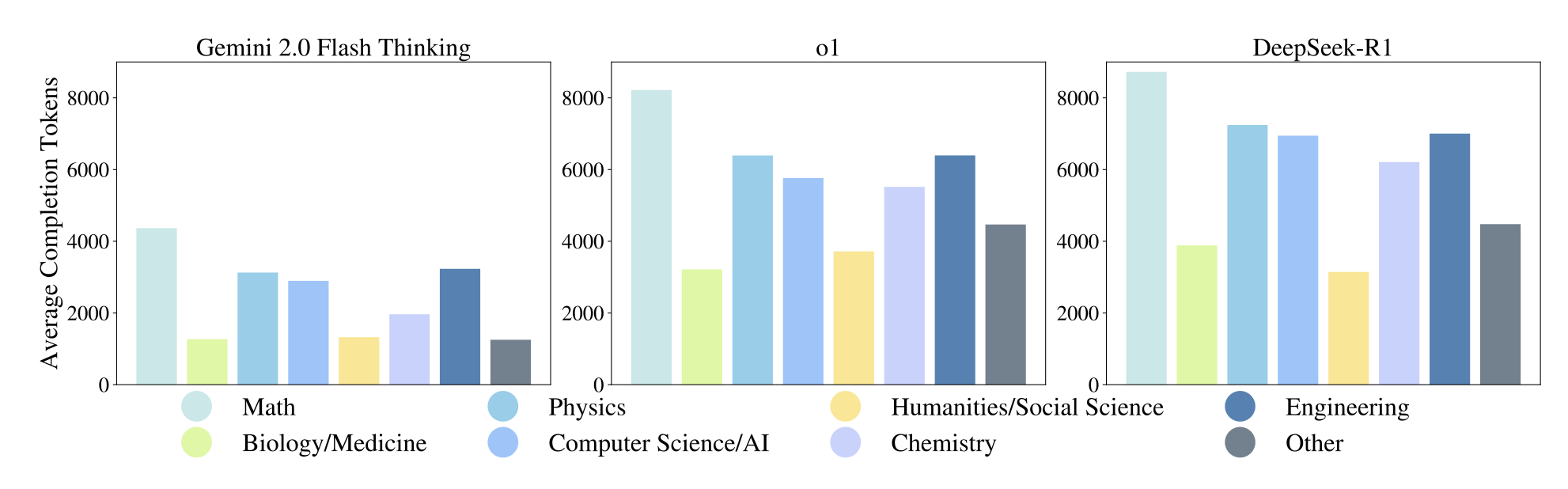

모델이 답을 생성하는 데 쓰는 토큰 수(=추론 비용의 대리 지표) 도 함께 분석한 결과 특히 reasoning 모델들은 비-reasoning 모델보다 훨씬 많은 토큰을 생성하며, 그만큼 계산 비용이 커진다는 것을 확인할 수 있었다. 즉, 약간의 성능 향상을 위해 추론 컴퓨트가 급격히 증가하는 형태의 trade-off가 나타난다. 저자들은 미래 모델이 단지 정확도만 높일 것이 아니라, compute-optimal(계산 효율)도 고려해야 한다고 주장한다.

2) Discussion

HLE가 측정하는 것은 구조화된 학술 문제(정답이 있는 문제)에서의 능력이지, 자율 연구(autonomous research) 능력이나 창의적 발견 능력을 직접 의미하지는 않는다. 그럼에도 HLE가 중요한 이유는 AI의 전문가 수준 학술 능력에 대해 공통 기준점을 제공하고 연구자뿐 아니라 정책결정자/대중이 모델이 어디까지 왔는지를 과장 없이 논의할 수 있게 한다는 점에 있다. 하지만 벤치마크는 결국 또 포화될 수 있으므로, HLE 역시 시간이 지나면 모델들이 빠르게 점수를 끌어올릴 수 있다는 점 또한 기억해야 할 것이다

------------------------------------------------논문 review----------------------------------------------------------

4. 데이터셋 현재 벤치마크 성적

https://artificialanalysis.ai/evaluations/humanitys-last-exam

Q1. 파라미터 수가 늘수록 점수가 오를까?

1. Llama

뚜렷한 경향이 없다. 오히려 파라미터 개수가 적을 때 성능이 비교적 높았다.

- Llama 2 Chat 7B 5.8% > Llama 2 Chat 70B 5.0% > Llama 2 Chat 13B 4.7%

- Llama 3.2 1B 5.3% > Llama 3.2 11B (Vision) 5.2% > Llama 3.2 3B 5.2% > Llama 3.2 90B (Vision) 4.9%

- Llama 3.1 8B 5.1% > Llama 3.1 70B 4.6% > Llama 3.1 405B 4.2%

- 파라미터 개수가 적을수록 성능이 높다.

- Llama 3 8B 5.1% > Llama 3 70B 4.4%

2. Qwen

뚜렷한 경향이 없다.

- Qwen3 235B A22B 2507 15.0% > Qwen3 Next 80B A3B 11.7% > Qwen3 235B 11.7% > Qwen3 235B 2507 10.6% > Qwen3 VL 235B A22B 10.1%

3. Gemma

오히려 파라미터 개수가 적을 때 성능이 높다.

- Gemma 3 1B 5.2% > Gemma 3 4B 5.2%

Q2. 주요 frontier 모델 성적은?

- (Google) Gemini 3 Pro Preview (high) 37.2% > (Anthropic) Claude Opus 4.6 (Adaptive) 36.7% > (OpenAI) GPT-5.2 (xhigh) 35.4%

- Gemini, Cluade, GPT가 상위권에 위치한다.

Q3. 오픈소스 최강자 대비 정확도

- Qwen3 235B A22B 2507 15.0%과 비교했을 때 약 20% 정도 더 높았다.

Q4. Frontier 모델 계열 내 경향

1. GPT

- GPT-5 > GPT-5 mini > GPT-5 nano

- 성능 차이가 명확히 난다.

2. Claude

- Opus > Sonnet > Haiku

3. Grok

- Grok 4 23.9% > Grok 4 Fast 17.0%

4. Google Gemini

- Pro 37.2% > Flash 34.7%

Q5. Frontier 모델 내 Reasoning 모드 차이

1. OpenAI: GPT

- high > medium > low > minimal

2. Cluade

- Adaptive Reasoning > Non-Reasoning

3. Grok

4. Google Gemini

Q6. 한국 파운데이션 모델 성적

- K-EXAONE 13.1% > EXAONE 4.0 32B 10.5% > Solar Open 10B 9.2% > Midm K 2.5 Pro Preview 8.8% > Midm K 2.5 Pro 7.7%

- 한국 모델은 대체로 4~13% 대에 분포한다.

- Llama/Gemma 보다는 높고, Frontier 모델보다는 낮다.

Q7. 데이터셋 관련 연구

1. 기존 학술 및 추론 벤치마크 연구

- 일반 학술 능력

- MMLU / MMLU-Pro / MMLU-Pro+: 대규모 멀티태스크 언어 이해 측정 / 기존 MMLU를 강화하고 고차원 추론 평가

- AGIEval: 인간 중심의 기초 모델 평가 벤치마크

- GLUE/SuperGLUE: 일반적인 목적의 언어 이해 시스템 평가

- BIG-bench (Beyond the Imitation Game): 모델 역량의 정량화 및 외삽 평가

- ARC Prize 2024: 추론 능력을 측정하는 벤치마크

- 전문 지식

- GPQA: 구글 검색으로 해결하기 어려운 대학원 수준의 Q&A 벤치마크

- 수학적 추론

- FrontierMath: 최첨단 수학적 추론 평가

- Omni-Math: 올림피아드 수준의 범용 수학 벤치마크

- OlympiadBench: 올림피아드 수준의 다국어 멀티모달 과학 문제

- MATH Dataset / Math Word Problems: 수학적 문제 해결 능력 측정

- MathVista: 시각적 맥락에서의 수학적 추론 평가

- PutnamBench: 퍼트넘 수학 경시대회 기반 평가

- 과학 및 생물학

- Lab-bench: 생물학 연구 역량 측정

- WMDP: 생화학 및 사이버 보안 등 악성 사용 위험 측정 및 방지

- HealthBench / Med-PaLM 연구: 임상 및 건강 지식 평가

- 코드 및 공학

- SWE-bench / SWE-bench Verified: 실제 GitHub 이슈 해결 능력 평가

- MLE-bench: 머신러닝 엔지니어링 에이전트 평가

- APPS: 코딩 과제 수행 능력 측정

- Cybench / CyberSecEval: 사이버 보안 역량 및 위험 평가

- 언어 이해 및 사실성: 독해, 추론 및 모델의 행동을 분석하는 연구

- SQuAD / SQuAD 2.0: 텍스트 독해 및 답변 불가능한 질문 판별

- Natural Questions: 자연어 질문에 대한 구글 검색 기반 답변 평가

- MS MARCO: 인간이 생성한 기계 독해 데이터셋

- DROP: 문단 내 이산적 추론을 요구하는 독해 벤치마크

- HotpotQA: 설명 가능한 다단계(Multi-hop) 질문 답변

- DynaBench / Adversarial NLI (ANLI): 역동적이고 적대적인 벤치마크 설계 연구

- FACTS Leaderboard / Short-form Factuality: 모델의 사실성 측정

- 이외 특정 기능에 특화된 벤치마크

2. HLE 데이터셋에 대한 비판적 분석 연구

- Future House의 분석: Skarlinski(2025)은 HLE의 화학 및 생물학 분야 정답 중 약 30%가 틀렸을 가능성이 있다고 주장

- 이에 대해 HLE 연구진은 전문가 불일치 비율(Expert Disagreement Rate)에 대한 추가 분석을 수행했다.

- 생물학, 화학, 건강 분야의 서브셋을 다시 검토한 결과, 전문가 간의 의견 불일치율이 약 18%로 나타났다.

- 만약 한 명의 전문가라도 이의를 제기했을 때 질문을 오류로 판정하는 '단일 리뷰어 방식'을 택할 경우, 해당 분야의 불일치율은 25%까지 상승하며 이는 Future House가 주장한 수치에 근접하게 나타났다.

- 복잡한 건강 및 의학 주제에서 전문가들 사이에 의견 차이가 발생하는 것은 일반적인 현상임을 강조했다.

- 데이터셋 품질 개선을 위한 후속 조치

- HLE-ROLLING 도입: 정적인 데이터셋의 한계를 극복하기 위해 커뮤니티 피드백을 정기적으로 반영하고 오류를 수정하는 동적 데이터셋 포크(Fork)인 'HLE-ROLLING'을 출시하기로 했다.

- 버그 바운티 프로그램: 출시 후 레이블 오류나 문제 서술 상의 중대한 결함을 찾아내는 커뮤니티 피드백 프로그램을 운영하여 데이터셋을 정제하고 있다.

- 심층 오디트(Audit): 미국 명문대 학생들을 모집하여 샘플 문제를 직접 풀게 하고, 원저자와 오디터 간의 합의가 이루어질 때까지 검토하는 과정을 거쳤다.

3. 벤치마크 설계 및 포화에 관한 연구

- 글로벌 역학 연구: Ott(2022)은 전 세계적인 AI 벤치마크 생성과 포화의 역학 관계를 매핑하는 연구를 수행했습니다.

- 예측 가능성 연구: Owen(2024)은 언어 모델의 벤치마크 성능이 얼마나 예측 가능한지에 대한 연구를 통해 평가 체계 설계의 이론적 근거를 제공했습니다

Q8. 한계점

1. 평가 범위의 국한성

HLE는 구조화된 학술적 지식과 기술적 추론 능력을 측정하는 데 집중되어 있기 때문에 높은 score를 받았다고 해서 해당 모델이 자율적인 연구 능력이나 창의적인 문제 해결 능력, 인공 일반 지능(AGI)을 갖추었다는 것을 의미하지는 않는다. 즉, HLE는 개방형 연구 과제가 아닌, 정답이 정해진 폐쇄형(closed-ended) 학술 문제를 평가하는 도구라는 한계가 있다.

2. 전문가 간의 의견 불일치 및 정답 오류 가능성

전문적이고 복잡한 문제를 다루기 때문에, 전문가들 사이에서도 정답에 대한 의견이 갈릴 수 있다.

- 의견 불일치율: 공공 데이터셋의 경우 약 15.4%, 특히 생물학, 화학, 건강 도메인에서는 약 18%의 전문가 간 의견 불일치율이 나타났다.

- 정답 오류: 외부 분석(Future House)에 따르면, 화학 및 생물학 분야 정답의 약 30%가 틀렸을 가능성이 제기되기도 했다. 연구진은 이를 검토하여 수정하고 있지만, 전문가 한 명의 검토에만 의존할 경우 불일치율이 25%까지 오를 수 있다는 것을 인정했다.

3. 검토 프로세스의 시간적 제약

데이터셋 구축 과정에서 각 질문에 대한 검토자들의 평균 검토 시간은 3~5분으로 제한되었다. 따라서 제공된 해설의 전체 정확성을 완벽하게 검증하기보다는, 질문이 가이드라인에 부합하는지에 더 집중하게 되는 한계가 발생했다.

4. 측정의 노이즈와 운에 의한 정답

모델이 문제를 풀 때 일관되지 않은 추론을 하거나, 객관식 문제에서 운 좋게 정답을 맞히는 추론 노이즈(Inference Noise)가 존재한다. 이 때문에 정확도가 0에 가깝게 낮게 나오더라도, 이것이 모델의 실제 능력 바닥(floor)을 의미하는지 아니면 우연한 결과인지 정확히 판별하기 어렵다는 점이 지적되었다.

5. 급격한 벤치마크 포화 가능성

과거의 사례를 비추어 볼 때, 아무리 어려운 벤치마크라도 AI 모델의 발전 속도에 따라 빠르게 포화(Saturation)될 가능성이 높다. 연구진은 2025년 말이면 모델들이 HLE에서 50% 이상의 정확도를 달성할 수도 있다고 예측하며, 이는 벤치마크의 유효 수명이 짧을 수 있음을 시사한다.

6. 모델의 과신(Calibration) 문제

현재의 최첨단 모델들은 정답을 모르더라도 매우 높은 확신(Confidence)을 가지고 오답을 내놓는 경향이 있다. HLE 평가 결과, 모든 모델에서 70% 이상의 높은 보정 오차(RMS calibration error)가 나타났으며, 이는 모델이 자신의 능력 한계를 인식하지 못하고 환각(Hallucination)을 일으키고 있음을 보여준다.