논문 제목 : Human-level Control through Deep Reinforcement Learning (Nature, 2015)

- 저널: Nature

- 발표일: 2015년 2월 25일

- 인용수: 22,000회 인용

Human-level control through deep reinforcement learning (Nature, 2015)

DQN 배경

- 과거 RL은 표 기반/선형 근사와 수작업 특징에 의존해 작은 상태공간만 다루었고, 픽셀 입력에는 취약했음.

- 신경망+RL은 부트스트래핑/분포 이동으로 학습이 자주 불안정·발산했으며, Atari도 주로 hand-crafted features + linear(SARSA/Q-learning) 조합을 사용함.

- DQN은 CNN으로 픽셀 표현을 직접 학습하고 Experience Replay·Target Network로 안정화하여, 하나의 설정으로 여러 게임을 학습 가능하게 만들었음.

요약

- 무엇을 했나: DeepMind의 DQN은 화면 픽셀+점수만으로 49개 Atari 게임을 하나의 동일 알고리즘으로 학습해 인간에 근접한 성능을 달성.

- 핵심 구성: CNN 기반 표현 학습 + Q-learning에 Experience Replay와 Target Network를 결합해 학습 불안정성을 완화.

- 벤치마크: Atari 2600(ALE) — 픽셀 기반 시각 → 행동 학습의 표준 테스트베드.

핵심 아이디어 (Methods)

1) CNN으로 “보는 법” 학습 (Representation Learning)

- 아이디어: Convolutional Neural Network가 픽셀에서 국소 패턴 → 추상 표현을 계층적으로 추출.

- 전처리: Grayscale, 84×84 리사이즈, 최근 4프레임 스택(움직임 정보).

2) Q-learning으로 “가치” 학습 (Value Learning)

- Q-value Q(s,a): “지금 상태 s에서 행동 를 하면 앞으로의 총 보상이 얼마나 될까”를 예측하는 숫자.

- 학습: 예측 Q(s,a)가 목표값(타깃)에 가까워지도록 loss(제곱오차)를 줄임.

- 행동 선택: 대부분은 argmaxaQ(s,a)로 활용(Exploitation), 가끔은 무작위로 탐험(Exploration) 하는 -greedy

- 스케줄: 학습 초반 ϵ크게 시작 → 점차 줄여 활용 비중↑

3) 불안정성 완화의 두 축 (Stabilization)

- Experience Replay: 전이 (s,a,r,s′)를 버퍼에 저장 후 무작위 미니배치로 샘플링 → 시계열 상관↓, 데이터 재사용↑, 학습 안정성↑

- Transition: “그때 본 것(st)–한 행동(at)–받은 점수(rt+1)–다음에 본 것(st+1)–끝났는지(done)”을 담은 한 스텝 기록.

용어

- Experience Replay: 플레이 기록을 섞어서(random) 조금씩 뽑아 복습 → 안정·효율 향상.

- Transition (st,at,rt+1,st+1,done): 한 스텝 상호작용 기록(보상은 숫자 값).

- Q-value Q(s,a): 상태–행동의 장기 이득 예측값.

- Target Network(θ−): 주기적으로 복사해 만든 잠깐 고정된 예측기(타깃 계산용).

- Atari(ALE): 픽셀 기반 RL 성능을 비교하는 표준 벤치마크.

문제 정의

- 컴퓨터는 매 순간 수만 개의 숫자(픽셀)를 받습니다. 그 숫자만 보고 “왼쪽/오른쪽/점프/발사” 같은 행동(Action)을 고르고, 점수(Reward)를 최대화해야함.

- 예전 RL은 상태가 단순하거나 사람이 특징(Feature)을 만들어 준 경우에 잘 됐음. 하지만 픽셀 같은 고차원 입력에선 잘 안 됐음.

핵심 난제:

- 고차원 입력에서 유의미한 표현(Representation)을 자동으로 뽑아야 함.

- 과거 경험을 새로운 상황으로 일반화해야 함.

- 강화학습+신경망은 학습이 쉽게 불안정/발산함.

Model Architecture

- 입력: 84×84×4 최근 화면 4장을 흑백(밝기) 으로 줄이고(84×84), 겹쳐서 입력합니다. → 한 장면이 아니라 움직임까지 보게 하려는 것.

- Conv1: 32@(8×8, stride 4) + ReLU 화면을 돋보기 32개로 훑어 큰 패턴(공/벽 같은 덩어리)을 찾습니다. stride 4는 4칸씩 건너뛰며 본다는 뜻.

- Conv2: 64@(4×4, stride 2) + ReLU 더 작은 돋보기 64개로 중간 크기 패턴(총알, 경계 등)을 잡습니다.

- Conv3: 64@(3×3, stride 1) + ReLU 가장 작은 돋보기 64개로 세밀한 특징(모서리, 접촉 순간)을 봅니다.

- FC: 512 + ReLU 앞에서 뽑은 특징들을 한 줄 요약 벡터(512차원) 로 정리합니다.

- Output: 액션 수(|A|) 만큼의 선형 유닛 → 각 행동의 Q(s,a)를 한 번의 forward로 모두 계산 가능한 모든 행동에 대한 Q값(“지금 이 행동을 하면 앞으로 얼마나 좋을까”)을 한 번에 출력 → 매번 행동마다 따로 계산하지 않아 빠르고 안정적.

용어

• Conv(Convolution): 이미지에서 특징을 찾는 필터.

• ReLU: 음수는 0으로, 양수는 그대로 두는 간단한 활성화 함수(학습을 쉽게).

• stride: 필터가 얼마나 건너뛰며 움직이는지. 숫자가 클수록 큰공간을 훑습니다.

Results 요약

- 49개 중 43개에서 당시 SOTA 능가.

- 29개에서 인간의 75% 이상.

- 동일 아키텍처/하이퍼파라미터로 전 게임 적용 → 범용성.

Figures

픽셀 입력을 받아 Convolutional Neural Network(CNN)로 특징을 추출하고, 마지막에 각 행동(Action)마다 하나씩 Q-value를 내는 Deep Q-Network(DQN)의 파이프라인.

- (상단 패널 a,b) 에피소드 평균 점수가 epoch가 지날수록 상승.

- (하단 패널 c,d) 보류 상태셋(held-out states)에서 평균 예측 Q의 안정화.

- x축: training epochs(고정된 업데이트 단위의 묶음).

- y축(상): 에피소드당 평균 점수.

- y축(하): 평균 예측 Q값

- 안정화 신호: 평균 Q가 초반 요동/과대/과소 후 평형대로 수렴.

- Experience Replay와 Target Network가 없으면 흔히 보이는 진동/발산이 억제됨.

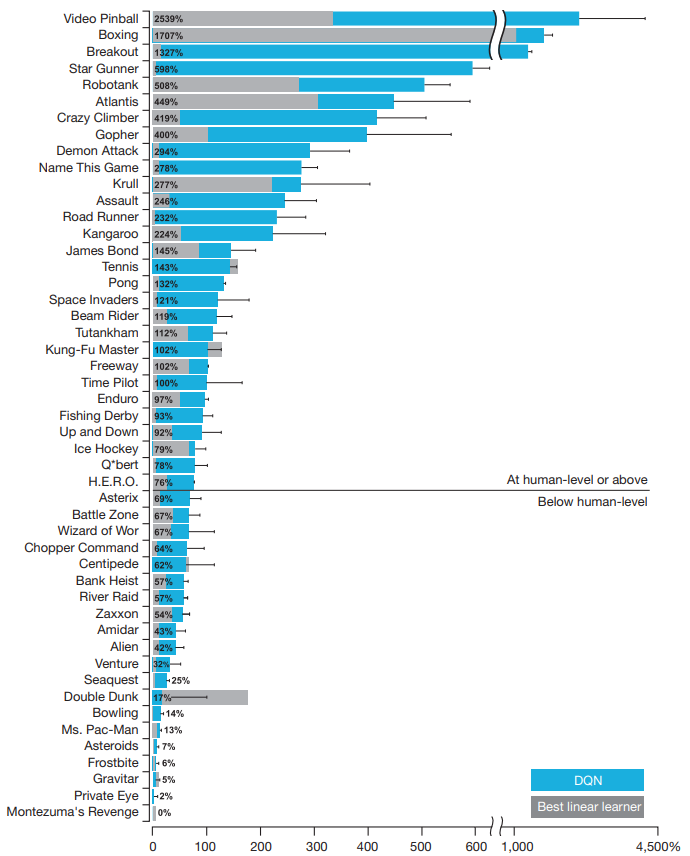

각 게임에서 DQN이 랜덤(0%)과 인간 전문가(100%) 사이에서 어느 수준인지 보여줌. 또한 기존 최고 선형함수근사법과 비교.

→ 0%=랜덤 수준, 100%=인간 전문가. 100%+는 인간 전문가를 초월.

- 43/49에서 기존 RL 최강을 능가, 29/49에서 인간의 75% 이상.

- 하나의 동일 아키텍처/하이퍼파라미터로 이 성과 → 범용성의 근거.

- 마지막 은닉층 임베딩을 t-SNE로 2D 시각화.

- State value V(s) V(s)는 “지금 이 상황 s이 앞으로 얼마나 잘 풀릴지”를 숫자로 나타낸 상태의 기대 점수

- Q(s,a): “상태 s에서 행동 a를 했을 때 앞으로의 기대 점수” → 상태+행동의 가치

- V(s): “상태 s의 전체적 가치” → 행동 미정 즉, 정책이 각 행동을 고를 확률로 Q값을 평균낸 것이 V예요. 즉, 행동을 아직 고르기 전, 그 상황 자체의 좋음(goodness) 을 나타내는 값입니다.

- 점 하나 = 한 게임 상태의 마지막 은닉층 표현.

- 색상: 빨강(높은 V) ↔ 파랑(낮은 V).

- 지각적으로 달라도 가치(state value V)가 비슷하면 가깝게 매핑되는 사례 다수 → DQN이 가치 중심 표현을 학습했다는 증거. 예) 스테이지를 거의 깼을 때/막 깼을 때: 화면 배치는 다르지만, 다음 보상 기대가 높다는 공통점 → 가치 중심 표현을 학습.

Key Takeaways

- 픽셀→행동 end-to-end: 사람 손의 feature engineering 없이, CNN + Q-learning으로 시각 표현(Representation) 과 행동가치(Q) 를 한 번에 학습하는 일반 해법을 제시.

- 안정화의 핵심 장치: Experience Replay(분포 안정·데이터 재사용)와 Target Network(부트스트랩 안정화), 여기에 Reward/TD-error clipping을 결합해 신경망+RL의 발산 문제를 실전에서 억제.

- 범용성 검증: 동일한 아키텍처/전처리/하이퍼파라미터로 다수 Atari 게임에서 강력한 성능을 달성하며, 픽셀 기반 일반 RL 에이전트의 가능성을 실증.

- 이후 Double/Dueling DQN, Prioritized Replay, n-step, Noisy Nets, Distributional RL 등을 Rainbow로 통합하며 계보가 확장; 더 나아가 AlphaGo/AlphaZero 류로 이어지는 현대 DRL 표준 스택의 출발점.

'Miscellaneous' 카테고리의 다른 글

| [2025-2] 김지원 - Anchors: High-Precision Model-Agnostic Explanations (0) | 2025.11.02 |

|---|---|

| [2025-2] 이루가 - A review of Q-learning methods for Markov decision processes (0) | 2025.09.13 |

| [2025-2] 김지원 - Introduction to Reinforcement Learning (0) | 2025.09.13 |

| [2025-2] LLM-based agent : DrBioRight 2.0 (2) | 2025.08.16 |

| [2025-2] 이루가 - A survey on large language model based autonomous agents (3) | 2025.08.16 |