논문 정보: Yang, H., Yue, S., & He, Y. (2023). Auto-gpt for online decision making: Benchmarks and additional opinions. arXiv preprint arXiv:2306.02224.

링크: https://arxiv.org/pdf/2306.02224

인용수: 226회 (2025-08-16 기준)

초록

Auto-GPT는 의사 결정 태스크를 수행하는 LLM을 활용하는 자율 agent이다.

Auto-GPT 스타일의 연구가 진행되고 있으나 Auto-GPT의 실제 세계 의사 결정 태스크를 풀기에 효과성과 유연성과 관련된 의문이 여전히 존재한다.

이러한 불확실성은 벤치마크의 부재와 제한된 실제 세계 관여 능력 때문이다.

이 연구에서 Auto-GPT 스타일 에이전트의 실제 세계 의사 결정 관련 포괄적인 벤치마크 연구 제공하며 유명한 LLM들을 교차 비교(GPT-4,GPT-3.5, Claude, Vicuna)한다.

추가로 저자는 지도/모방 기반의 학습을 Auto-GPT 스킴에 통합한 쉽고 효과적인 방법인 Additional Opinions 알고리즘을 도입했으며 이 접근법은 파운데이션 모델의 미세 조정을 필요로하지 않는 가벼운 지도 학습을 가능케 한다.

소개

LLM을 자율 에이전트에 적용하는 시도는 최근 많은 성공을 다룬다(의사 결정, 가상 캐릭터 시뮬레이션, 도구 조작 태스크 등).

거대한 LLM이 특정 일반 지능 수준을 가질 수 있다는 증거가 있음에도 여전히 LLM을 자율 에이전트에 직접적으로 활용하는 것은 한계가 있다(장기 메모리의 부족, 제한된 토큰 길이 그리고 결정론적 행동 통제 부족).

한계를 극복하기 위한 프롬프트, 계획 그리고 메모리 추출을 포함한 다양한 기술들이 제안되었다.

그 중 Auto-GPT가 있고 이는 인터넷에 연결되어 어떤 태스크든 수행하는 GPT 기반의 자율 에이전트이다.

하지만 제한된 액션 능력으로 인해 태스크를 수행하는 효율성의 정도에는 여전히 불확실하다.

저자는 Auto-GPT 스타일의 에이전트를 다음과 같이 정의

(1) 고차원 목표와 지시들을 복잡한 멀티 스텝 태스크의 초기에만 받음. 인간으로부터 어떠한 스텝 바이 스텝 가이드를 받지 않음(=처음 한번 설명하고 끝)

(2) 액션의 각 단계에서 ‘생각’,’추론’,’계획’ 그리고 ‘비판’을 생성함으로써 자기-독백(self-monologue) 진행

(3) 단순한 도구 지시들과 몇몇 예시들을 통해 다양한 도구들을 통합하는 능력을 가짐

(4) 장기 self-memory와 메모리 추출 매커니즘을 통합

(5) 태스크 특화 적응을 위해 최소한의 노력만 필요함(예를 들어 목표 정의, 도구 설명)

Auto-GPT 스타일의 에이전트의 한계와 성능에 대한 깊은 인사이트를 얻기 위해, Auto-GPT를 unknown한 외부 환경에 대응하는 온라인 의사 결정 태스크에 적용함으로써 실험을 진행한다.

추가로, 저자는 어떻게 외부 모델들이 additional opinions에 대한 providers로써 활용될 수 있는 지를 설명하기 위한 novel approach 제안한다.

현재까지 인간처럼 이러한 additional opinions로 부터 LLM이 도움을 받을 수 있는 지에 대한 연구는 없었다.

이 흥미로운 발견은 LLM과 협력할 수 있는 작은 전문가 모델들이 있는 새로운 파라다임을 열게 될 것이라고 주자는 주장한다.

저자의 Contribution

(1) 최초로 Auto-GPT가 쉽게 온라인 의사 결정 태스크에 적용될 수 있음을 보임

(2) 포괄적인 벤치마크 대조를 제공

(3) 지도 학습자로부터 second opinion을 통합하는 것이 상당히 태스크 성능을 증가시키고 동시에 supervision signals를 Auto-GPT 스타일의 자율 에이전트에 파인 튜닝 없이 도입할 수 있는 값싼 방법을 제공

방법론

1) Tasks and baseline models

(1) WebShop

Webshop은 1,1,81,436개의 제품들을 Amazon.com에서 스크랩해서 독자적인 서버에 둔 웹 쇼핑 경험을 복제한시뮬레이션 환경

이 한경은 에이전트에게 실제적 행동 공간을 제공한다.

→ 제품 검색, 아이템 클릭, 이전 페이지로 돌아가기, 구매하기

평가는 에이전트가 설명을 기반으로 의도된 제품 구매에 성공했는지로 진행한다.

→즉 적합한 제품, 특성, 옵션, 가격에 구매했는가

저자는 미세 조정된 행동 정책 요소를 베이스 라인으로 하는 IL(Imitation Learning)을 사용하여 다른 LLM with Auto-GPT 스타일들을 비교한다.

(2) ALFWrold

ALFWorld는 ALFRED 데이터 셋의 복잡한 과제 지향적 언어 이해와 TextWorld의 몰입형 소통 소설을 조합한 획기적인 검색 환경임

→ALFRED의 3D 시각적 환경을 텍스트 기반 상호작용으로 완전 변환

(시각적 관찰 → 자연어 설명

로봇 행동 → 텍스트 명령어

환경 피드백 → 텍스트 응답)

예시:

> go to fridge

You arrive at loc 1. On the fridge 1, you see a lettuce 1, a egg 1, and a tomato 1.

> take tomato 1

You pick up the tomato 1 from the fridge 1.

> go to microwave

You arrive at loc 3. The microwave 1 is closed.

ALFRED(Action Learning From Realistic Environments and Directives) 벤치마크는 모델이 parse를 학습하고 디테일하고 상호적인 3D 환경 내에서 언어 지시로부터 복잡한 태스크를 수행하는 견고한 테스트 환경을 수행한다.

반면 TextWorld는 동적인 학습 playground로써 제공된다.

여기서도 저자는 DAgger IL(모방 학습) 에이전트를 베이스라인으로 하는 평가 과정을 진행한다.

2) Prompt design

태스크 요구사항과 Auto-GPT의 목표에 대한 직접적인 질문을 제공함으로써 진행한다(튜닝 X).

예를 들어 “I want to purchase a folding sotrage box that is easy to install, made of faux leather, and has dimensions of 60x40x40cm”

가능한 Action에 대한 Auto-GPT의 이해를 촉진하기 위해 action을 도구로써 제공하며

도구의 설명을 sermon-style 방식으로 몇몇 예시와 함께 작성한다.

3) Considering additional opinions

외부 전문가 모델로부터의 additional opinions를 고려하기 위해 Auto-GPT 워크플로우에 대한 변경 진행

→ Auto-GPT의 결정 단계에서 전문가 모델로부터의 Top K opninons를 샘플링하고 이러한 의견들을 프롬프트 내에 삽입

예시:

’Here’s one(a few) suggestion(s) for the command: <action with parameters> Please use this suggestion as a reference and make your own judgement.’

실험

1) Experimental Setup

(1) Webshop

기본 설정:

- 원본 WebShop 서버 설정 사용 (Amazon.com에서 스크래핑한 1,181,436개 제품)

- 테스트 범위: 첫 50개 instruction만 선택 (비용과 계산 효율성 고려, 특히 GPT-4)

- Temperature: 모든 모델에서 0.01로 설정하여 랜덤성 최소화

모델 비교:

- IL(Imitation Learning) 모델: 이미지 임베딩 있는 버전과 없는 버전으로 구분

- LLM은 이미지 접근이 없으므로 공정한 비교를 위해 IL 모델도 이미지 없는 버전 사용

- Additional Opinion의 경우 이미지에 접근이 가능한 IL 모델을 사용

- Auto-GPT + IL 변형의 경우 작은 변동성 때문에 2회 실행 후 평균값 사용

태스크 구조:

- 원본 지시사항 기반 검색 쿼리 생성

- 다양한 아이템 중 탐색할 아이템 선택

- 제품 세부 페이지에서 정보 확인 및 옵션 선택

- 최종 구매 결정

사용 IL 모델:

- BART 기반 모델: 검색 쿼리 생성용 (1단계 태스크)

- BERT 기반 모델: 선택 작업용 (2-4단계 태스크)

(2) ALFWrold

기본 설정:

- 기존 ALFWorld 환경의 134개 unseen 게임 셋 사용

- IL 모델에 결합할 모델로 BUTLER::BRAIN (텍스트 에이전트)만 활용, BUTLER::VISION은 제외

- 텍스트 에이전트(IL)는 DAgger(Dataset Aggregation) 방식으로 전문가 시연을 통한 훈련됨

사용 기법:

- Beam Search: 실패 시 대안 액션 문장 생성

- 예시: 후보1: go to cabinet, 후보2: go to drawer, 후보3: go to countertop

- 주로 효율성을 위해 greedy 방식으로 최적 단어 시퀀스 선택

- 체화된 상호작용보다는 액션 문장 생성 최적화에 중점

실험 설정:

- 모든 LLM에서 temperature 0.01로 설정하여 노이즈 최소화

- 원본 평가 프로토콜 엄격히 준수하여 랜덤성 완화

2) Baseline Comparison

WebShop 결과:

- IL 모델: 이미지 없는 버전 21.3%, 이미지 있는 버전 22.7% 성공률

- Auto-GPT 단독 성능: Claude(14.0%), GPT-3.5(12.0%), **GPT-4(24.0%)**로 최고 성능

- Vicuna: 포맷된 응답 생성 불가로 0% 성공률

- 중요 발견: GPT-4는 IL 모델보다 높은 정밀도(precision)를 보임

ALFWorld 결과:

- IL 모델: Beam Search 있음 30.6%, 없음 17.9% 성공률

- Auto-GPT 성능: Claude(8.2%), GPT-3.5(7.5%), **GPT-4(48.5%)**로 압도적 성능

- GPT-4만 IL 모델을 능가, 나머지는 부족한 성능

3) LLM Comparison

WebShop에서의 LLM 성능:

- Claude vs GPT-3.5: 유사한 성능 (14.0% vs 12.0%)

- GPT-4: 최고 성능 (24.0%)

- 속도 측면: Claude > GPT-3.5 > GPT-4 순으로 빠름

- 권장사항: 성능-지연시간 트레이드오프 고려 시 Claude 추천

ALFWorld에서의 LLM 성능:

- Claude & GPT-3.5: 매우 낮은 성공률 (8.2%, 7.5%)

- GPT-4: 압도적 성능 (48.5% 성공률, 62.8% 정밀도)

- 성능 차이 원인: Claude와 GPT-3.5는 암시적 지식 도출 능력 부족

- 최종 권장: GPT-4 사용 권고

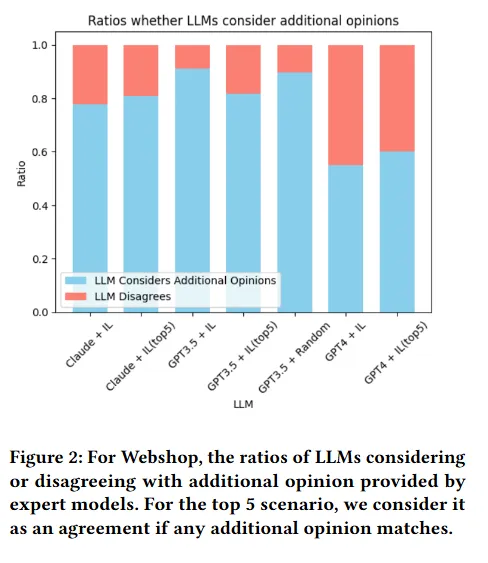

4) Additional Opinions

WebShop에서의 효과:

- 핵심 발견: 모든 LLM에서 IL 의견 추가 시 성능 향상

- GPT-4: 단일 의견(30.0%) → 상위 5개 의견(32.0%)으로 최고 성능

- 의견 수용률: GPT-4가 가장 높은 기준과 가장 많은 의견 불일치 비율

- 품질 중요성: GPT-3.5에 무작위 의견 제공 시 최악 성능 (6.0%)

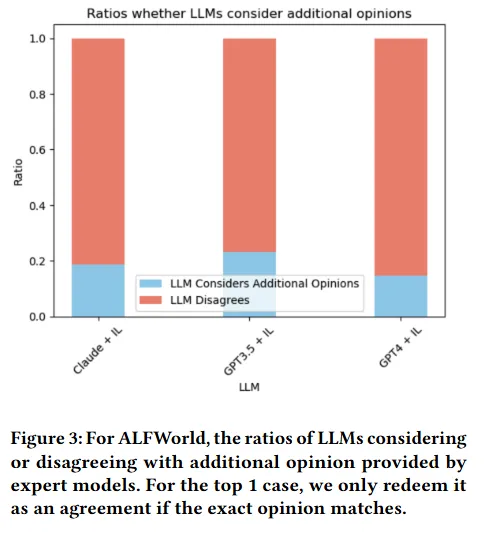

ALFWorld에서의 효과:

- GPT-4: IL 의견으로 51.5% 성공률 달성 (기존 48.5%에서 향상)

- Claude: 소폭 향상 (8.2% → 9.0%)

- GPT-3.5: 오히려 성능 저하 (7.5% → 3.0%) - 잘못된 제안에 쉽게 혼동

- 중요 발견: GPT-4는 잡음 속에서도 유용한 조언과 무관한 조언을 구별하는 뛰어난 능력 보유

환경별 차이점:

- WebShop: IL 모델이 효과적으로 선택 공간을 축소시키는 유용한 가이드 제공

- ALFWorld: IL 모델이 반복적이고 misleading하는 조언 제공

- 모델별 대응: GPT-4와 Claude는 misleading하는 조언을 잘 필터링, GPT-3.5는 쉽게 혼동

핵심 시사점:

- Additional Opinions 방법은 특히 GPT-4에서 효과적

- 외부 전문가 모델과 LLM의 협력적 접근이 성능 향상에 기여

- 맥락에 따른 신중한 평가 필요 (misleading하는 입력에 대한 각별한 주의)