https://arxiv.org/abs/2309.00267

RLAIF vs. RLHF: Scaling Reinforcement Learning from Human Feedback with AI Feedback

Reinforcement learning from human feedback (RLHF) has proven effective in aligning large language models (LLMs) with human preferences, but gathering high-quality preference labels is expensive. RL from AI Feedback (RLAIF), introduced in Bai et al., offers

arxiv.org

1. Introduction

- RLHF는 인간의 선호를 model에 일치 시키는데 효과적이며, ChatGPT와 Bard 같은 LLM에서 중요한 역할을 한다.

- 하지만 RLHF를 하기 위해서는 고품질의 humam preference labels가 필요하다.

- Constitutional ai: Harmlessness from ai feedback (2022)에서 RLAIF가 처음 시도되었지만 RLHF와 RLAIF의 직접적인 비교가 없다는 한계가 존재한다.

2. Methodology

2.1 Perference Labeling with LLMs

Al가 입력된 응답 중 어느 것이 더 좋은 지 평가하여 선호도를 부여하는 과정이다.

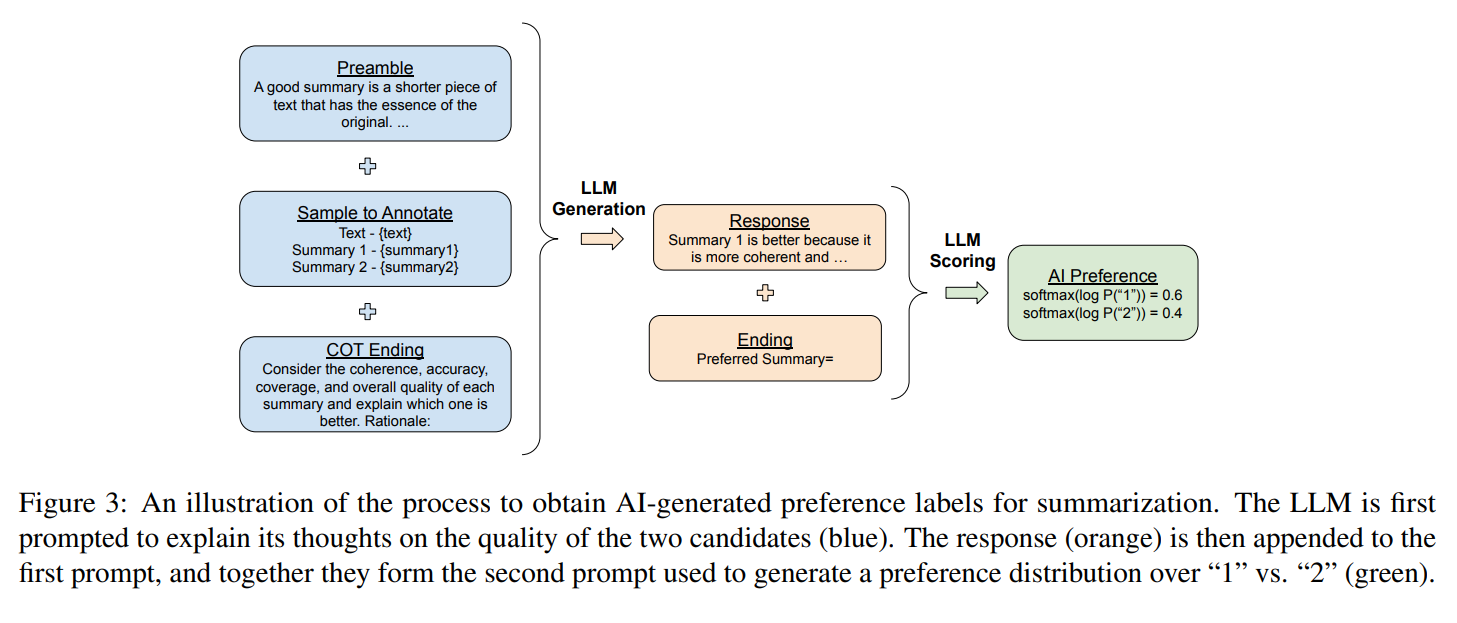

(1) LLM에게 평가 요청 (Prompting)

- LLM에게 응답을 비교 평가하도록 요청하는 prompt를 설계한다.

- Preamble: 평가 기준 설명

- Few-shot exemplars(선택 사항): 좋은 평가를 위한 예제 제공

- Sample to annotate: input context와 비교할 두 개의 응답 제공

- Ending: LLM을 prompt한 것에 대한 ending text (ex. “Preferred Response =”)

(2) AI가 응답을 평가하여 선호도 부여

- LLM이 제공된 두 개의 응답을 비교한 후, 어느 응답이 더 나은지 판단한다.

- 평과 결과는 확률값 (softmax)으로 변환하여 저장된다.

(3) AI 선호도를 보상 모델(RM) 학습에 활용

- LLM이 평가한 선호도를 기반으로 보상 모델을 학습한다.

- 이후 RL과정에서 AI policy model이 더 나은 응답을 생성하도록 유도한다.

2.2 Reinforcement Learning from AI Feedback

Canonical RLAIF

- AI Preference Labeling

- AI를 활용하여 선호도 데이터를 생성하는 과정

- 두 개의 응답 중 더 나은 응답을 선택하고, 이를 학습 데이터로 사용함

- Reward Model

- AI가 생성한 선호도 데이터를 기반으로 reward model을 학습함

- 보상 모델은 입력과 응답을 받아 좋은 응답일수록 높은 보상을 할당하는 함수를 학습함

- Reinforcemnet Learning

- 보상 모델을 활용하여 정책 모델을 강화 학습함

- 정책 모델은 RLHF와 동일한 방식으로 학습됨

Direct RLALF (D-RLAIF)

- AI preference를 reward model에 학습시키는 것이 아니고, 바로 reward signal로 사용한다.

- AI perference → reward 과정 (아래 서술)

- LLM이 응답을 평가하고, 점수를 1~10 범위에서 부여하도록 한다.

- 1~10 점수의 likelihood를 정규화하여 token generation probability로 변환한다.

- weighted score 를 $s(y∣x)=∑_{i=1}^{10} iP(i∣y,x)$으로 계산한다. → 여기서 $P(i∣y,x)$는 LLM이 특정 점수 $i$(1~10)일 확률을 예측한 값

- 이 점수를 [-1, 1] 범위로 다시 정규화한다.

| 비교 항목 | RLAIF | d-RLAIF |

| Preference 평가 방식 | LLM이 응답을 비교하여 선호도 라벨을 생성 | 동일 |

| Reward 계산 방식 | 선호도 데이터를 학습하여 보상 모델 구축 후 사용 | LLM이 직접 보상 점수(1~10)를 부여 |

| 보상 적용 방식 | 보상 모델이 생성된 응답을 평가하여 보상 결정 | LLM이 평가한 점수를 직접 RL 보상으로 사용 |

| 학습 속도 | 보상 모델이 학습이 필요하여 추가 학습 시간이 소요됨 | 즉시 보상을 계산하여 RL에 활용 가능 |

2.3 Evaluation

AI가 생성한 응답이 얼마나 인간의 평가와 잘 맞는지, 유용하고 안전한지를 측정한다. 이에 대한 기준은 AI Labeler Alignment, Win Rate, Harmless Rate로 잡는다.

AI Labeler Alignment

- $D$ : 전체 평가 데이터 개수

- $P^{AI}_{i,j}$ : Dx2 크기의 soft AI preferences 행렬

- AI가 D에 대해 두 개의 응답 중 하나를 선호할 확률을 나타내는 행렬

- 각 행에 [응답 1을 선택할 확률, 응답 2를 선택할 확률]이 포함됨

- AI가 응답을 비교한 후 각 응답이 선택될 확률을 부여한 값

- $p^{H}_{i}$ : D 크기의 human preferences를 나타내는 벡터

- 인간이 응답을 비교한 후 선택한 결과를 저장한 벡터

- 0과 1로 표현됨

→ AI가 인간과 얼마나 유사한 선호도를 갖는지 평가

Win Rate

- human annotator가 2개의 policy 중 더 선호하는 것을 선택

- 두 개의 응답(AI 응답 vs. 비교 대상 응답)을 인간 평가자가 보고, 더 나은 응답을 선택했을 때 AI 응답이 선택된 비율

Harmless Rate

- human annotator에 의해 위험하지 않다고 평가되는 답변의 비율

- AI가 부적절한 내용, 유해한 발언, 차별적이거나 윤리적으로 문제가 있는 내용을 생성하지 않을 확률

3. Experimental Details

- 사용된 데이터셋: 여러 데이터셋을 사용하여 실험을 진행했으며, 각 데이터셋은 특정한 태스크(예: 요약, 유용성, 무해성 평가)를 다룬다.

- LLM 라벨링: 모델이 빠른 실험 진행을 위해 다운샘플링된 데이터셋으로 학습되며, PaLM 2 모델을 사용하여 선호도를 라벨링한다.

- 모델 학습: REINFORCE 알고리즘을 활용하여 강화 학습을 통해 정책을 훈련하며, SFT 모델에서 초기화하여 훈련을 시작한다.

- 인간 평가: 승률과 응답의 품질을 기준으로 평가하여 RLAIF, RLHF, SFT 정책 간의 성능을 비교한다.

4. Results

4.1 RLAIF vs. RLHF

- 3개의 task: summarization, helpful dialogue generation, and harmless dialogue generation 수행

- RLAIF와 RLHF가 SFT보다 outperform

- summarization, helpful dialogue에서 RLHF와 RLAIF의 유의미한 차이가 존재하지 않음

- harmless dialogue에서는 RLAIF가 RLHF보다 outperform

따라서, RLAIF가 human annotation가 필요 없이 RLHF의 대안이 될 수 있다.

4.2 D-RLAIF

- 계산 비용을 줄이기 위해 PaLM 2 XS라는 소형 AI 모델을 사용하여 AI 피드백을 제공한다.

- d-RLAIF는 SFT나 동일 크기의 RLAIF보다 더 우수한 성과를 보였으며, annotator들은 d-RLAIF를 선호한다.

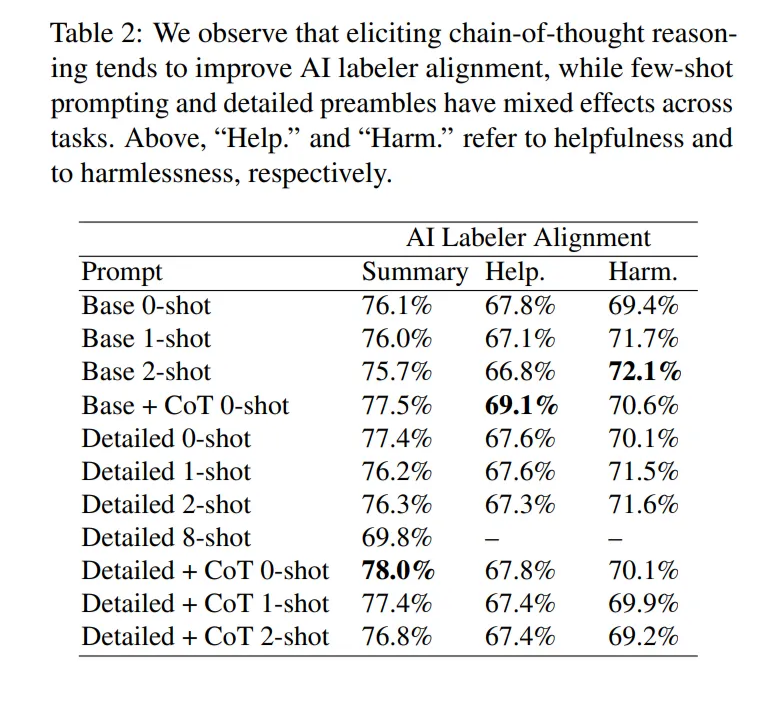

4.3 Prompting Techniques

- prompt 변형이 모델의 성능에 영향을 미친다.

- Detailed preamble은 summary에서는 효과적이지만, helpful 작업과 harmless 작업에서는 일관되지 않은 결과를 나타낸다.

- in-context learning은 harmless 작업에서 효과적이다.

- CoT는 summary, helphul 작업에 효과적이다.

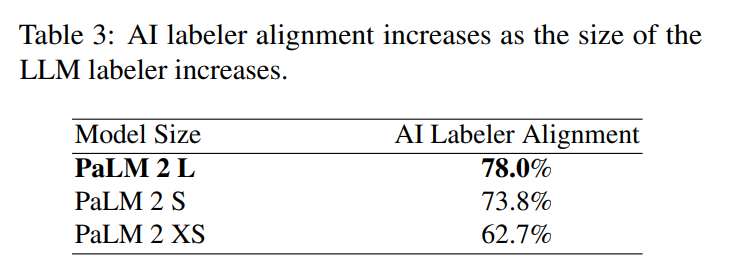

4.4 Size of LLM Labeler

- 모델 크기가 커질수록 정렬이 향상되는 경향이 있으며, (논문에서는) 작은 모델은 위치 편향이 더 크다는 가설 제시한다.

- 모델의 크기를 키우면 더 정확하고 고품질의 선호도 라벨을 생성할 수 있다

- 즉, 모델의 크기가 성능에 중요한 영향을 미친다.

- AI 라벨러는 선호도 라벨을 생성하는 데만 사용되고, RL 과정에서는 사용되지 않기 때문에, 모델 크기를 키우는 것이 비용 효율적일 수 있다.

5. Qualitative Observations

- RLAIF와 RLHF는 대부분 유사한 요약을 생성하지만, 때때로 차이가 발생한다.

- RLHF는 hallucination(환각)을 일으킬 수 있으며, 원본 텍스트와 일치하지 않는 정보를 추가하는 경우가 있다.

- RLAIF는 때때로 불필요한 반복이나 유창하지 않은 문장을 생성하기도 했다.

- 70개의 예시를 가지고 annotators이 RLHF와 RLAIF 요약을 객관적으로 평가하도록 했다.

- RLAIF와 RLHF의 차이가 통계적으로 유의미한 차이를 보이지는 않았다

→ 차이점을 대규모 데이터셋에서 확인하려면 추가적인 연구가 필요

6. Conclusion

- RLAIF는 RLHF와 비교하여 유사한 성능 개선을 보였으며, 두 모델은 인간 평가자들에게 비슷한 비율로 선호된다.

- direct-RLAIF는 기존의 RLAIF보다 더 좋은 성과를 보였으며, 이는 피드백을 바로 제공하는 방식이 효과적임을 보여준다.

- 다양한 AI 라벨링 기술이 인간 선호와의 일치에 미치는 영향을 연구하였고, RLAIF의 잠재력을 강조한다.