1. Introduction

LCM의 현황

LLM :

NLP의 표준 기술로 자리잡았으나, 토큰 수준에서 동작하며 인간처럼 다층적인 추론 및 창의적 콘텐츠 생성에는 한계 有

암묵적으로 계층적 구조를 포함하고 있지만, 명백한 계층적 구조를 가진 모델이 일관된 장문의 출력을 만드는데 적합

인간은 단어 수준이 아닌, 개념적이고 추상적인 레벨에서 정보를 처리하고 생성하기에 명백한 계층적 구조를 가진 모델 필요

LCM의 목표

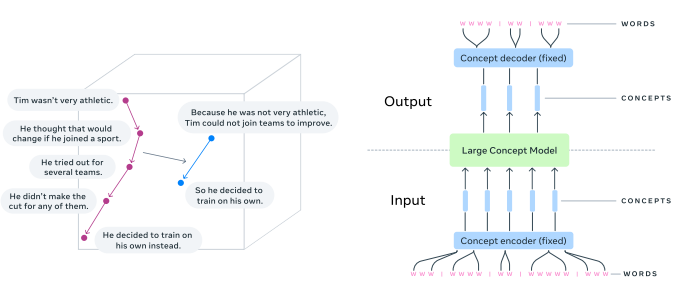

LCM(Large Concept Models)은 "개념"을 중심으로 작동하며, 언어와 모달리티에 독립적인 구조를 가짐

SONAR라는 문장 임베딩 공간을 활용하여 200개 언어의 텍스트와 76개 언어의 음성을 지원

기존 LLM과의 차별점

현재 LLM들은 단순히 다음 토큰을 예측하지만, LCM은 계층적 정보 구조를 명시적으로 모델링

ex) 연구 발표를 준비할 때 주요 아이디어를 먼저 정리한 후 세부 내용을 추가하는 인간의 방식과 유사한 접근

2. Main Design Principles

SONAR 임베딩 공간

SONAR는 문장 수준의 고도로 추상적인 의미 표현을 지원

특징

200개의 언어를 지원하며, 텍스트와 음성을 포함한 멀티모달 처리 가능.

번역, 잡음 제거, MSE 손실 최소화로 훈련됨.

76개 언어의 음성을 텍스트로 변환하거나, 영어 음성으로 출력 가능.

데이터 준비

긴 문서를 문장 단위로 분리하여 SONAR 임베딩으로 변환

문장 분리 도구

SpaCy: 고자원 언어에서 강점을 가짐.

SaT(Segment any Text): 구두점이 부족한 데이터에서도 정확한 분리가 가능.

SaT Capped: 문장 길이를 200자로 제한해 긴 문장에서 발생하는 문제를 완화.

LCM 변형

- Base-LCM

MSE 손실을 최소화하도록 설계된 기본 모델.

SONAR 임베딩을 입력으로 받아 다음 문장의 임베딩을 예측.

- Diffusion LCM

노이즈를 추가하여 점진적으로 다음 문장 임베딩을 생성.

One-Tower: 하나의 Transformer로 문맥과 노이즈를 함께 처리.

Two-Tower: 문맥과 노이즈를 별도의 Transformer로 분리하여 처리.

- Quantized LCM

SONAR 임베딩을 Residual Vector Quantization(RVQ) 기법으로 이산적 단위로 변환.

이산적 데이터 생성에서 온도(temperature), top-k 샘플링 등 제어 가능.

3. Model Variants and Implementation

Base-LCM

기본 Transformer 아키텍처로 구성.

입력 문맥에서 다음 문장 임베딩을 예측하며, 학습 목표는 MSE 최소화.

Diffusion-Based LCM

- One-Tower

입력 문맥과 노이즈를 함께 처리.

임베딩에 노이즈를 추가하고 이를 제거하며 다음 문장 임베딩을 생성.

- Two-Tower

문맥을 인코딩하는 "Contextualizer"와 노이즈를 제거하는 "Denoiser"로 분리.

더 복잡한 구조로 문맥과 노이즈 처리를 독립적으로 수행.

Quantized LCM

벡터 양자화를 활용해 SONAR 임베딩을 이산적 형태로 변환.

SONAR 디코더를 재학습하여 양자화된 데이터에 적합하게 조정.

4. Ablation Studies

실험 환경

모델 크기: 약 1.6B 파라미터.

학습 데이터: Fineweb-edu 데이터셋.

평가 데이터셋: C4, ROC-stories, Wikipedia-en, Gutenberg.

성능 결과

Diffusion 기반 LCM이 전반적으로 높은 성능.

Quant-LCM은 더 간단한 구조를 제공하며 일부 작업에서 유리.

Base-LCM은 생성된 문장의 다양성이 낮고, 과도한 평균화 경향이 있음.

평가 지표

- ℓ2 및 ℓ2-r

생성된 임베딩과 실제 임베딩 간 거리.

- Contrastive Accuracy (CA)

생성된 임베딩이 실제 임베딩과 얼마나 유사한지를 측정.

- Mutual Information (MI)

생성된 문장과 문맥 간의 상호 정보량 평가.

5. Instruction Tuning and Evaluation

학습 후 평가

Cosmopedia 데이터셋으로 Instruction-Tuning 수행

Diffusion LCM이 Quant-LCM보다 높은 ROUGE-L 및 Coherence 점수 기록

기존 LLM 대비 Diffusion LCM의 성능 차이는 적었으나 여전히 향상 가능성 보여줌

주요 결과

Diffusion 기반 모델이 더 높은 일관성과 품질 제공

Quantized LCM은 간단한 구조로 효율적인 학습과 추론 가능

6. Discussion

강점

다국어 제로샷 일반화와 장문 생성에서 우수한 성능

SONAR 임베딩을 활용한 멀티모달 처리 지원

한계

현재 모델은 텍스트와 음성에 초점이 맞춰져 있으며, 영상 등 추가 모달리티 확장이 필요

일부 작업에서 기존 LLM에 비해 낮은 성능