https://arxiv.org/abs/1409.3215

Sequence to Sequence Learning with Neural Networks

Deep Neural Networks (DNNs) are powerful models that have achieved excellent performance on difficult learning tasks. Although DNNs work well whenever large labeled training sets are available, they cannot be used to map sequences to sequences. In this pap

arxiv.org

Abstract

Sequence-to-Sequence(Seq2Seq) 모델은 기존의 순환 신경망(RNN) 및 장단기 기억 네트워크(LSTM) 기반 접근법의 한계를 극복하며 기계번역과 같은 자연어 처리 분야에 혁신을 가져왔다. 이전 방법들은 토큰 단위로 문장을 처리하고, 입력 문장과 출력 문장의 토큰 개수를 동일하게 맞춰야 하는 제약이 있었으나, Seq2Seq 모델은 입력 문장을 하나의 통합된 표현으로 간주하여 토큰 개수의 제약 없이 동적으로 출력 문장을 생성할 수 있다. 이러한 유연성은 언어 구조가 크게 다른 경우에도 자연스러운 번역을 가능하게 한다. 예를 들어, 기존 모델이 "나는 너를 정말 사랑해"를 "I love you very"와 같은 어색한 문장으로 번역할 가능성이 있다면, Seq2Seq 모델은 "I love you so much"와 같이 의미를 온전히 전달하는 번역을 생성할 수 있다. 이러한 접근법은 기계번역을 포함한 다양한 자연어 처리 응용 분야에서 높은 정확도와 적응성을 제공하며, 현대 NLP 기술의 기반을 다지는 데 기여하고 있다.

About Model

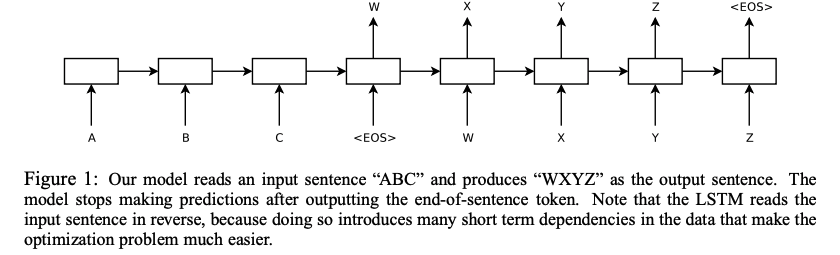

-Seq2Seq의 구조는 크게 인코더(Encoder)와 디코더(Decoder)로 구성.

-인코더에서는 입력 시퀀스를 단어의 수와 상관없는 하나의 context vector로 표현하고, 이를 기반으로 디코더에서 시퀀스를 출력한다.

RNN 기반 모델의 단점

-입출력 사이즈가 동일하다는 가정

-Token별로 나오는 Output의 정확도에 대한 의문

====> 이를 LSTM을 활용한 Encoder / Decoder 구조로 해결한 것이 Seq2Seq

기존 LSTM과는 다르게, 저자가 제안한 모델은 input sequence와 output sequence에 사용하는 LSTM을 각각 따로 두어 두 개의 LSTM을 사용하였다. 또한, 깊은 LSTM은 얕은 것보다 훨씬 좋은 성능이 나오므로, 4 layer짜리 LSTM을 사용했다. 마지막으로, input sequence를 역순으로 입력에 넣어 input의 앞부분이 output의 앞부분과 가장 가깝게 있도록 해서 SGD가 input과 ouput이 “소통”을 하게 만들 수 있게 했다. 이러한 간단한 방법들이 성능을 크게 증가시켰다.

Experiments

저자는 WMT’14 영어-불어 번역 task에 두 가지 방법을 평가했다.

- reference SMT시스템 없이 input sequence를 바로 번역

- SMT baseline의 n-best 리스트를 다시 재점수 매기기

Performance on long sentences

LSTM이 긴 문장에 대해서도 잘 작동하는 것을 확인하였다. Table 3는 긴 문장과 번역된 문장의 예시를 보여준다.

Model Analysis

고정된 크기의 context vector를 사용하는 Seq2Seq 발표 이후, 기계 번역 모델들은 개별 토큰이 아니라 입력 시퀀스 전체에서 정보를 추출하는 방향으로 발전하고 있다.