2-5강에서 이어서 진행됩니다.

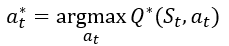

2-5강에 따르면 optimal policy는 다음과 같은 방식으로 구할 수 있다.

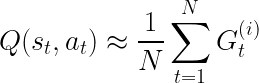

앞서 2-5강에서는 가치함수를 구하는 방법은 다음과 같이 구할 수 있다.

하지만 우리는 probability 전이확률을 모르는 경우가 너무나도 많다(예를 들어서 체스, 바둑 같은 게임 환경에서 모든 상태의 전이 확률을 계산하기는 불가능하다). 이럴 경우에 큰 수에 법칙에 따라 충분한 개수 샘플 N개를 뽑아서 이를 평균하는 방향으로 근사시킬 수 있다.

monte carlo를 사용하게 된다면 랜덤한 에피소드 샘플 N개를 뽑아서 이에 따른 Gt값을 구한다. 이를 통해 Q값을 구하고 각 state에 해당하는 가장 큰 Q값을 구하면서 Q는 점점 Q*에 다가가게 되고 Q*로 인해 점점 optimal policy로 갈 수 있게 되는 것이다.

'Miscellaneous' 카테고리의 다른 글

| [2025-1] 김학선 - Bellman Equation (0) | 2025.01.05 |

|---|---|

| [2025-1] 김은서 - Markov Decision Process (MDP) (1) | 2025.01.05 |

| [2025-1] 정지우 - Optimal policy 쉬운 설명 (혁펜하임 강화학습 3-1강 정리) (3) | 2025.01.04 |

| [2024-2] 문지영 - deeplearning: Deep Feedforward Networks (1) (1) | 2025.01.04 |

| [2024-2] 문지영 - deeplearning: Introduction (1) | 2025.01.04 |