paper link :https://arxiv.org/pdf/2007.01547

Descending through a Crowded Valley— Benchmarking Deep Learning Optimizers (ICML 2021)

딥러닝에서 optimizer 선택은 중요한 결정 중 하나.

Adam, SGD 부터 수많은 Adam 변형까지, 최근 수년간 제안된 optimizer는 수백개에 이른다.

이 중 실제로 얼마나 의미 있는 차이가 있는지에 대한 대규모의 체계적인 optimizer 벤치마킹 연구 논문.

논문 결과 요약

- optimizer 성능은 task-dependent

- 어떤 optimizer도 모든 task에서 좋진않았음.

- 여러 optimizer를 default로 설정해서 돌려보는것이 성능면에서 효율적인 선택.

- Adam계열은 default만으로 성능 준수, SGD, Momentum 계열은 튜닝없이는 불리.

- Adam 변형이 많지만, Adam을 일관적으로 이기는 optimizer는 없음. 즉, 안정적인 선택이 될 수 있다.

Fig1 : 지난 10년간 arXiv 제목/초록에 등장한 optimizer 언급 수.

2010년 이후 급격한 증가,

SGD와 Adam계열이 대부분을 차지함.

즉, 수많은 optimizer가 제안되지만, 실제로 널리 쓰이는것은 소수이다.

- 8개 문제

- 15개 optimizer

- 4개 튜닝 budget

- 4개 learning rate schedule

- 을 조합해 53,760번의 학습 실험을 수행

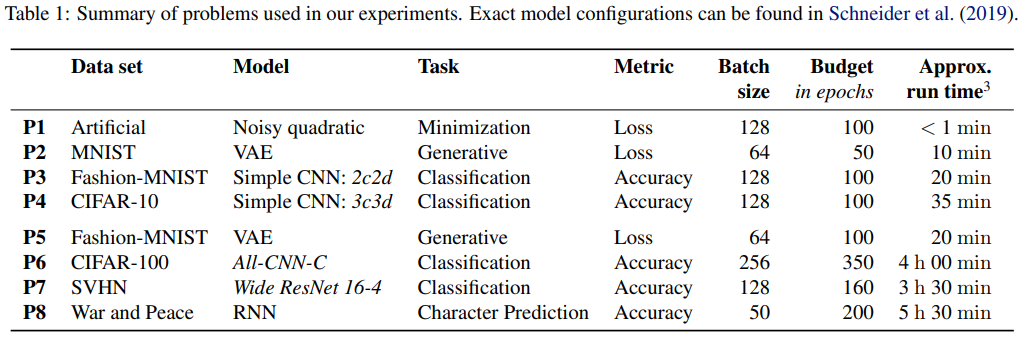

Table 1 : 사용한 Task 설명

small task(P1-P4)

large task(P5-P8)

CNN,VAE,RNN포함→ 구조 다양성 확보

단순 loss minimization부터 실제 generalization까지 포함한 다양한 task구성.

비교한 optimizer 선택 :

100개 이상의 optimizer 목록 중, 15개 선택.

실제로 많이 쓰고, 최근 주목받은 optimizer 15개.

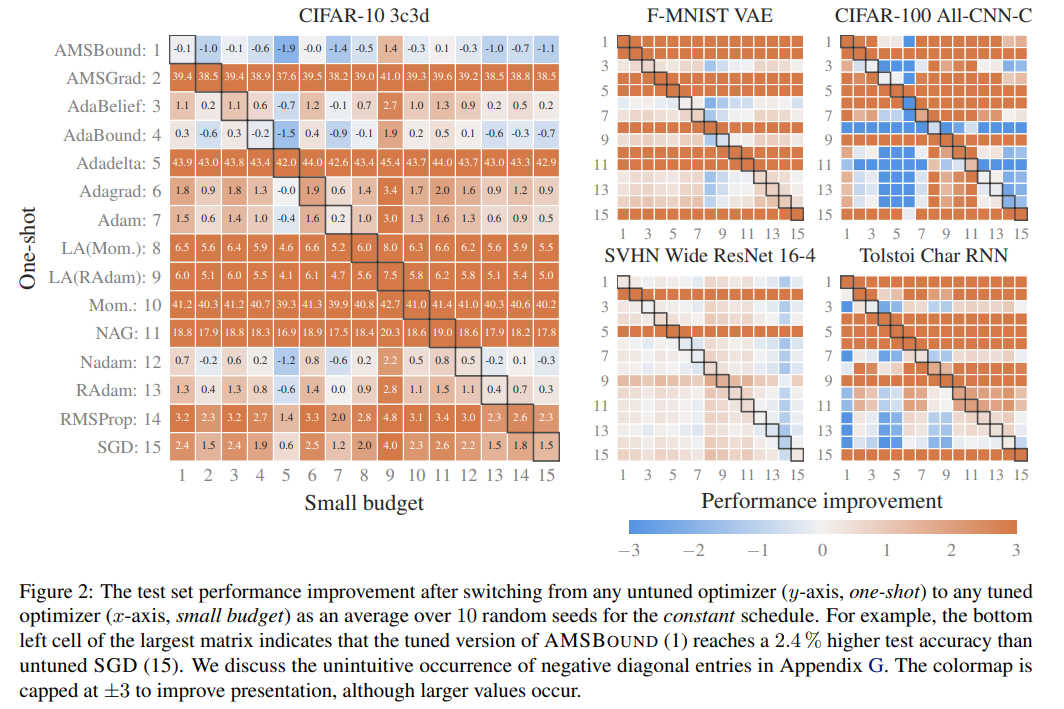

Figure 2: optimizer는 default 설정으로도 잘 작동할지에 대해 :

y축 : one-shopt : default

x축 : hyperparameter tuning된 optimizer.

value : default 대비 튜닝되었을때 성능이 얼마나 개선 되었는지

- 주황 : 양수. 튜닝된게 더 좋음.

- 파랑 : 음수. default가 더 좋음.

결과 요약

- SGD,Momentum,NAG, AMSGRAD,Adadelta : 튜닝된게 대부분 좋음.

- Adaptive optimizer(ADAM,NADAM,RADAM,AdaBelif,AdaBound,AMSBound) : default와 크게 차이 나지않음. 즉, ADAM계열은 default를 그냥 써도 성능이 크게 뒤쳐지지않음.

- task에 따라서 튜닝했을때 좋아질수도 있고 아닐수도있음.

Figure 3: tuning의 정도와 learning rate schedule이 성능 향상에 얼마나 도움이 되는지.

x축 : tuning의 정도를 높임.

y축 : default대비 상대적 성능 개선률(%)

- 회색 선 : 개별 실험 결과

- 주황 선 : 중앙값(median)

- 주황 음영 : 25-75 percentile.

결과 요약 :

- 튜닝은 평균적으로 도움이 된다.

Figure 4: Optimizer benchmark 최종 결과 : 충분히 튜닝했을때 optimizer간 성능 차이.

▽: untuned ADAM (default) △: untuned AdaBound 빨간 에러바: tuned ADAM의 표준편차

8개의 task별로 y 축이 존재.

위쪽 한계선 : 해당 task에서 최고 성능.

결과 요약

- 항상 좋은 optimizer는 없음.

- Adaptive optimizer(ADAM,NADAM,RADAM,AdaBelif,AdaBound,AMSBound)는 전반적으로 안정적. (성능 분산이 크지않고, 상위권 근처에 위치)

- 특정 task에 강한 optimizer가 존재.

- image classification(CIFAR-10, CIFAR-100) : NAG,SGD 계열이 ADAM을 자주이김

- RNN (Tolstoi character prediction): RMSProp이 가장 안정적.

- VAE (MNIST, Fashion-MNIST): 일부 optimizer는 성능이 안좋음.

- ADAM과 AdaBound는 default임에도 경쟁력있는 성능일때가 많음.