논문 : https://arxiv.org/pdf/2505.24263

▲2025년 5월 30일에 공개된 arXiv에 게재된 논문임.(학회 X)

MBZUAI 설명:

MBZUAI는 아랍에미리트 아부다비에 위치한 세계 최초의 석사 및 박사 과정 중심의 인공지능 전문 연구 대학입니다. 2019년에 설립되어, 2025년부터 학부 과정도 개시하였습니다📍 위치

|

1. Abstract (초록)

이 연구는 LLM(대형 언어 모델)의 평가에서 데이터 누출 문제를 다룹니다.

기존의 누출 감지 방법을 비교하고, 누출을 시뮬레이션하여 이를 탐지하는 새로운 방법을 제시합니다.

특히, semi-half, permutation, n-gram 방식이 검토되었습니다.

각 방법의 성능을 실험적으로 평가한 결과, n-gram 방식이 가장 높은 성능을 보였습니다.

이 연구는 모델 평가에서 데이터 누출을 제거하고, 더 신뢰할 수 있는 성능 결과를 얻기 위한 중요한 기초 자료를 제공합니다.

2. Introduction (서론)

대형 언어 모델의 성능이 급격히 향상되면서, 벤치마크 테스트의 공정성이 논란이 되고 있습니다.

훈련 데이터와 평가 데이터가 겹치면, 모델이 시험 문제를 외운 것처럼 결과가 왜곡될 수 있습니다.

이 연구는 누출 탐지 방법의 유효성을 평가하고, 모델이 제대로 된 평가를 받을 수 있도록 하려는 목적을 가지고 있습니다.

누출된 데이터를 식별하는 기존의 방법은 명확하지 않거나 제한적이었으므로, 새로운 검출 방법이 필요합니다.

이 연구에서는 MMLU와 HellaSwag 두 가지 벤치마크를 사용하여 실험을 진행합니다.

3. Related Work (관련 연구)

LLM 평가에 대한 연구가 증가하면서, 데이터 누출을 감지하려는 다양한 방법들이 제시되었습니다.

기존 연구들은 로그 확률(logit-based) 또는 생성 기반 방법(generation-based)을 사용하여 누출을 감지하려 했습니다.

그러나 이들은 인스턴스 수준의 감지에 한계가 있었고, 실험적 조건에서 평가된 적이 없었습니다.

본 연구는 이러한 기존 방법들을 체계적으로 비교하고, 누출을 탐지할 수 있는 새로운 방법들을 평가합니다.

특히 n-gram 방법은 모델이 평가 데이터를 외운 것을 식별하는 데 효과적이라는 결과를 보였습니다.

4. Methods (방법론)

이 연구는 훈련 데이터 누출 시뮬레이션을 통해 세 가지 누출 감지 방법을 평가합니다.

- Semi-half: 질문의 절반을 잘라내고, 여전히 정확한 답을 맞출 수 있는지 확인합니다.

- Permutation: 보기 순서를 바꿔본 후, 원래 순서가 가장 높은 확률을 보이면 누출이 있다고 판단합니다.

- N-gram: 모델이 선택지를 완성할 때, 그 문장이 훈련 데이터와 얼마나 유사한지 평가합니다.

각 방법은 F1-score로 성능을 측정하고, 계산 효율성을 고려하여 개선이 이루어졌습니다.

5. Results (결과)

세 가지 방법을 실험한 결과, n-gram 방법이 가장 높은 F1-score를 기록했습니다.

Permutation-Q 방식은 계산 비용을 줄이면서도 좋은 성능을 보였고, Semi-half는 비교적 낮은 정확도를 보였습니다.

모델에 따라 성능 차이가 있었지만, n-gram이 가장 신뢰할 수 있는 방법으로 나타났습니다.

데이터 누출을 제거한 후, 모델 성능이 전반적으로 감소한 것을 확인할 수 있었습니다.

이러한 결과는 모델의 실제 성능을 더 잘 반영하는 평가가 필요함을 보여줍니다.

6. Conclusion (결론)

이 연구는 LLM 평가에서 데이터 누출을 탐지하기 위한 세 가지 방법을 비교하고, n-gram 방법이 가장 효과적임을 보여주었습니다.

누출 검사를 통해 모델 평가가 더 신뢰할 수 있고 공정하게 이루어져야 함을 강조했습니다.

특히, permutation-Q와 같은 효율적인 방법이 계산 자원 절감에 기여할 수 있다는 가능성을 열었습니다.

향후 LLM 연구에서 누출 감지는 표준 과정으로 자리잡을 필요가 있습니다.

이 연구는 누출 검출을 통한 모델의 진짜 성능 평가에 중요한 기준을 제시했습니다.

⬜⬜⬛⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬛⬜⬜

⬜⬛⬜⬛⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬛⬜⬛⬜

⬛⬜🟧⬜⬛⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬛⬜🟧⬜⬛

⬛⬜🟧🟧⬜⬛⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬜⬛⬜🟧🟧⬜⬛

⬛⬜🟧🟧🟧⬜⬛⬜⬛⬛⬛⬛⬛⬛⬛⬜⬛⬜🟧🟧🟧⬜⬛

⬛⬜🟧🟧🟧🟧⬛⬛🟧🟧🟧🟧🟧🟧🟧⬛⬛🟧🟧🟧🟧⬜⬛

⬜⬛⬜🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧⬜⬛⬜

⬜⬜⬛⬜🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧⬜⬛⬜⬜

⬜⬛⬜⬜🟧🟧🟧⬜⬜🟧🟧🟧🟧🟧⬜⬜🟧🟧🟧⬜⬜⬛⬜

⬜⬜⬛⬛🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧🟧⬛⬛⬜⬜

⬜⬜⬜⬛🟧🟧⬛⬛⬛🟧🟧⬜🟧🟧⬛⬛⬛🟧🟧⬛⬜⬜⬜

⬜⬜⬜⬛🟧🟧⬜⬛⬛🟧⬜⬜⬜🟧⬛⬛⬜🟧🟧⬛⬜⬜⬜

⬜⬜⬛🟧🟧⬜⬜⬛⬛⬜⬛⬛⬛⬜⬛⬛⬜⬜🟧🟧⬛⬜⬜

⬜⬜⬛🟧🟧⬜⬜🟧⬜⬜⬜⬛⬜⬜⬜🟧⬜⬜🟧🟧⬛⬜⬜

⬜⬜⬛🟧⬜⬜⬜🟧⬜⬜⬜⬜⬜⬜⬜🟧⬜⬜⬜🟧⬛⬜⬜

⬜⬜⬛🟧🟧🟧⬜🟧⬜⬜⬜⬜⬜⬜⬜🟧⬜🟧🟧🟧⬛⬜⬜

⬜⬜⬜⬛🟧🟧⬜⬜🟧⬜⬜⬛⬜⬜🟧⬜⬜🟧🟧⬛⬜⬜⬜

⬜⬜⬜⬜⬛⬛⬛⬛⬛⬜⬜⬜⬜⬜⬛⬛⬛⬛⬛⬜⬜⬜⬜

⬜⬜⬜⬜⬜⬜⬜⬛⬛⬛⬛⬛⬛⬛⬛⬛⬜⬜⬜⬜⬜⬜⬜

LLM 벤치마크의 데이터 유출 문제를 탐지하는 방법들:

들어가며: 왜 이 연구가 중요한가?

여러분이 시험을 보는데, 누군가는 이미 시험 문제를 미리 본 상태라고 상상해보세요. 공정한 평가가 될까요? 이것이 바로 현재 인공지능 언어 모델(LLM) 평가에서 일어나고 있는 문제입니다.

이 논문 "Simulating Training Data Leakage in Multiple-Choice Benchmarks for LLM Evaluation"은 바로 이 문제를 다룹니다. ChatGPT나 Claude 같은 대규모 언어 모델들이 얼마나 똑똑한지 평가할 때, 우리는 MMLU나 HellaSwag 같은 표준화된 시험(벤치마크)을 사용합니다. 그런데 만약 이 모델들이 학습 과정에서 이미 이 시험 문제들을 봤다면 어떨까요?

2개 데이터셋 설명 [더보기 클릭]

1. MMLU (Massive Multitask Language Understanding)개요:

구성:

특징:

예시:

활용:

2. HellaSwag개요:

구성:

특징:

예시:

활용:

결론:

|

핵심 문제: 데이터 오염(Data Contamination)이란?

문제의 본질

데이터 오염은 마치 시험 문제가 유출된 것과 같습니다. LLM이 학습할 때 수조 개의 텍스트 데이터를 학습하는데, 이 과정에서 평가용 시험 문제들이 포함될 수 있습니다. 문제는 많은 AI 회사들이 자신들이 어떤 데이터로 모델을 학습시켰는지 공개하지 않는다는 점입니다.

예를 들어:

- 어떤 모델이 "프랑스의 수도는?" 이라는 문제에 "파리"라고 답했다면

- 이것이 진짜 추론 능력 때문인지, 아니면 단순히 이 문제를 통째로 외웠기 때문인지 알 수 없습니다

왜 이것이 심각한 문제인가?

- 공정성 문제: 모든 모델을 동일한 기준으로 비교할 수 없게 됩니다

- 실제 능력 파악 불가: 모델이 진짜로 똑똑한지, 단순히 답을 외운 것인지 구분이 어렵습니다

- 연구 발전 저해: 잘못된 평가는 AI 발전 방향을 왜곡시킬 수 있습니다

연구진의 접근 방법: 시뮬레이션을 통한 검증

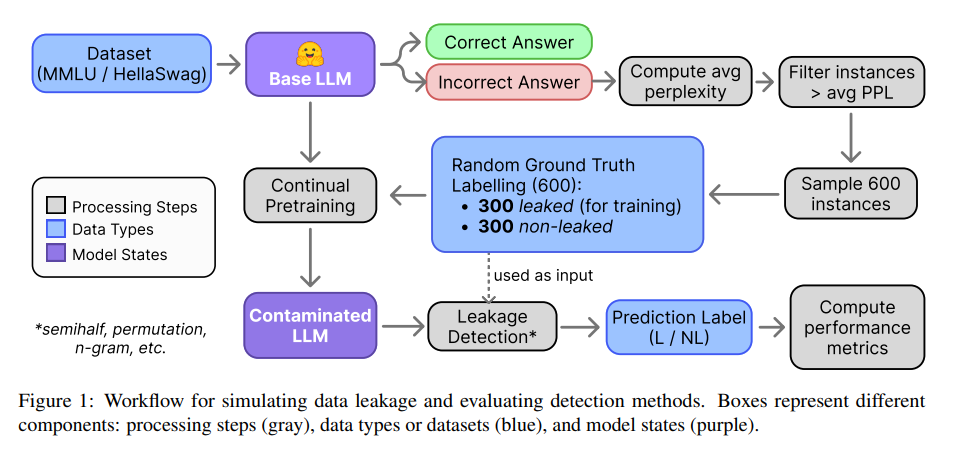

이 연구의 혁신적인 점은 "통제된 실험"을 설계했다는 것입니다. 마치 과학 실험처럼, 연구진은 아래를 진행했습니다.

- 깨끗한 데이터 선별: 모델이 확실히 본 적 없는 문제들을 골라냅니다

- 인위적 오염: 이 중 절반(300개)을 모델에게 추가 학습시킵니다

- 탐지 방법 테스트: 여러 탐지 방법들이 오염된 문제를 찾아낼 수 있는지 확인합니다

이는 마치 의도적으로 바이러스를 주입한 후, 백신이 잘 작동하는지 테스트하는 것과 같습니다.

세 가지 주요 탐지 방법

[더보기 클릭]

Figure 1: 데이터 유출 시뮬레이션 및 탐지 방법 평가 워크플로우이 그림은 전체 실험 과정을 한눈에 보여주는 플로우차트입니다.구성 요소:

|

1. Semi-half 방법: 반쪽 질문 테스트

작동 원리:

- 질문의 앞부분을 잘라내고 마지막 7단어만 남깁니다

- 예: "중력의 반대 방향으로 자라는 식물의 예시는?" → "자라는 식물의 예시는?"

- 이렇게 불완전한 질문에도 정답을 맞춘다면, 문제를 외웠을 가능성이 높습니다

장점:

- 매우 간단하고 빠릅니다

- 계산 비용이 적습니다

단점:

- 정확도가 상대적으로 낮습니다 (F1 점수: 50-70%)

- 많은 오염된 문제를 놓칠 수 있습니다

[더보기 클릭]

Figure 2: Semi-half 방법 예시원래 질문: "A plant grows in the opposite direction of the gravitational force. This is an example of" (식물이 중력의 반대 방향으로 자란다. 이것은 무엇의 예시인가?)Semi-half 질문: "gravitational force. This is an example of" (중력. 이것은 무엇의 예시인가?) 질문의 핵심 정보를 제거했는데도 정답을 맞춘다면, 문제를 통째로 외웠을 가능성이 높다는 원리입니다. |

2. Permutation 방법: 선택지 순서 바꾸기

작동 원리:

- 4지선다형 문제의 선택지 순서를 모든 경우의 수(24가지)로 바꿔봅니다

- 원래 순서(A-B-C-D)일 때 모델이 가장 높은 확률을 보인다면, 문제를 외웠을 가능성이 있습니다

예시:

원래: A) 파리 B) 런던 C) 베를린 D) 로마

변형1: B) 런던 A) 파리 D) 로마 C) 베를린

변형2: C) 베를린 D) 로마 A) 파리 B) 런던

... (총 24가지)

장점:

- 이론적으로 탄탄한 근거가 있습니다

- 상당히 높은 정확도 (F1 점수: 78-96%)

단점:

- 계산량이 매우 많습니다 (O(n!) 복잡도)

- 선택지가 많을수록 기하급수적으로 시간이 증가합니다

2-1. Permutation-R: 개선된 순서 바꾸기

연구진은 모든 24가지를 다 확인할 필요가 없다는 것을 발견했습니다.

- 비슷한 패턴을 보이는 순서들을 제거

- 50%만 사용해도 성능이 거의 동일

- 계산 시간을 절반으로 단축

2-2. Permutation-Q: 빠른 변형

혁신적 아이디어:

- 4개 선택지를 모두 사용하지 않고, 2개씩만 조합

- 복잡도를 O(n!)에서 O(n²)로 대폭 감소

- 예: (A,B), (A,C), (A,D), (B,C), (B,D), (C,D) 6가지만 확인

성능:

- 원래 방법과 비슷하거나 더 나은 성능

- 계산 시간은 획기적으로 단축

3. N-gram 방법: 텍스트 생성 비교

작동 원리:

- 모델에게 선택지를 하나씩 생성하도록 요청

- 생성된 텍스트와 원래 선택지의 유사도 측정 (ROUGE-L 점수 사용)

- 유사도가 75% 이상이면 오염 가능성

예시:

질문: "프랑스의 수도는?"

모델이 생성: "파리입니다"

실제 선택지: "파리"

→ 유사도 높음 → 오염 가능성

장점:

- 가장 높은 탐지율 (F1 점수: 81-100%)

- HellaSwag에서는 거의 완벽한 성능

- 비공개 모델에도 사용 가능

단점:

- 텍스트 길이에 따라 시간 소요 변동

- 반복적인 패턴의 선택지에서 오탐 가능성

| N-gram 방법: 텍스트 생성 비교 시 결과 N-gram 방법은 모델이 각 선택지를 생성한 후, 그것을 원래 선택지와 비교하여 유사도를 측정하는 방식입니다. 이 실험에서 ROUGE-L 점수를 사용하여 유사도가 75% 이상인 경우를 오염 가능성이 있다고 판단하였습니다. N-gram 방법은 높은 F1-score를 유지하면서도 효율적으로 데이터를 감지했습니다. 특히 HellaSwag 데이터셋에서 99.83%의 정확도를 보였고, MMLU에서는 여전히 81% 이상의 F1-score를 기록했습니다 이 결과들은 N-gram 방법이 데이터 오염을 탐지하는 데 매우 효과적이라는 것을 보여줍니다. |

ROUGE-L 이란? [더보기 클릭]

ROUGE-L 점수는 자동 텍스트 요약 및 텍스트 생성 모델의 성능을 평가할 때 자주 사용되는 지표입니다. ROUGE(Recall-Oriented Understudy for Gisting Evaluation)는 텍스트 요약 시스템의 품질을 평가하는 데 쓰이는 측정 기준으로, 여러 종류의 ROUGE 점수가 존재합니다. 그 중 ROUGE-L은 긴급한 일치(Longest Common Subsequence, LCS) 기반으로 계산됩니다.ROUGE-L 점수란?ROUGE-L은 두 텍스트 간의 가장 긴 공통 부분 수열(Longest Common Subsequence, LCS)을 사용하여 평가하는 지표입니다. 이 점수는 두 텍스트가 얼마나 유사한지를 측정하는 데 사용됩니다.

ROUGE-L 계산 방법ROUGE-L 점수는 정밀도와 재현율을 계산한 후, 이를 F1-score로 합산하는 방식입니다.

여기서:  ROUGE-L의 장점과 특성

ROUGE-L을 활용하는 예시예를 들어, 텍스트 요약에서 시스템이 생성한 요약과 정답(human reference summary) 간의 유사성을 비교할 때 사용됩니다.

따라서 ROUGE-L 점수는 1.0(최고 점수)을 받을 수 있습니다. ROUGE-L과 다른 ROUGE 점수들과의 차이점

ROUGE-L의 활용 분야

결론ROUGE-L 점수는 문장 내 단어 순서와 구조적 유사성을 반영하는 중요한 평가 지표입니다. 이 점수는 특히 긴 문장이나 구조적인 흐름을 중요한 평가 요소로 간주하는 텍스트 요약이나 기계 번역에서 강력한 도구로 사용됩니다. |

실험 결과: 충격적인 발견들

주요 발견 1: 광범위한 데이터 오염

연구진이 실제 LLM들을 검사한 결과는 아래에 있음.( n-gram 방법을 사용하여 각 모델이 벤치마크 데이터셋에서 훈련 중에 본 데이터를 얼마나 잘 기억하는지를 확인 )

MMLU 데이터셋 오염률:

- Qwen2.5-7B: 39.1% (가장 심각)

- LLaMA-3.1-8B: 37.9%

- DeepSeek-7B: 35.3%

- GPT-4o: 0.25% (매우 깨끗)

- Gemini-2.0-Flash: 0.05% (가장 깨끗)

이는 일부 모델들이 평가 문제의 1/3 이상을 이미 학습 중에 봤을 가능성을 시사합니다

[더보기 클릭]

Figure 6연구 방법:

|

[더보기 클릭]

Figure 3: N-gram 방법의 임계값 T에 따른 F1-score 변화X축: Ratio Threshold T (0.00 ~ 1.00) Y축: F1 Score (0.2 ~ 1.0)주요 발견:

Figure 4: Permutation 방법의 사용 비율(p)에 따른 성능X축: Selected Permutation Option Percentage (0 ~ 100%) Y축: F1 Score (0.70 ~ 0.95)핵심 발견:

X축: 선택지 순서 비율(p) 여기서 p는 Permutation 방법에서 사용할 순서 설정의 비율을 의미합니다. 예를 들어, p = 1.0이면 모든 가능한 순서를 다 계산하는 것이고, p = 0.5이면 순서 설정의 절반만 계산합니다. Y축: F1-score (모델 성능) F1-score는 모델이 데이터 누출을 얼마나 정확하게 감지하는지 평가하는 지표입니다. Figure 3: N-gram 방법의 임계값 T에 따른 F1-score 변화는 n-gram 방법의 성능을 측정하기 위한 실험 결과를 보여줍니다. 이 실험에서는 임계값(T)을 변경하면서 모델의 성능(여기서는 F1-score)이 어떻게 변하는지를 관찰합니다. N-gram 방법이란?먼저 n-gram 방법을 간단히 설명하겠습니다.n-gram 방법은 주어진 문장이나 선택지가 훈련 데이터와 얼마나 유사한지 측정하는 방법입니다. n-gram은 문장을 n개의 연속된 단어들로 분할하여 유사성을 판단합니다. 예를 들어 아래 bi-gram, tri-gram을 봅시다.

F1-score란?F1-score는 정밀도(precision)와 재현율(recall)의 조화 평균입니다.

임계값(T) 이란?임계값(T)은 n-gram 방법에서 "이 문장이 얼마나 유사해야 누출된 데이터로 판단할 것인가"의 기준을 설정하는 값입니다.즉, 임계값은 모델이 데이터 누출을 판단할 때, 얼마나 유사한 문장이면 누출로 간주할지를 결정하는 기준입니다.

Figure 3의 내용을 풀어 설명하면:

그래프 해석:

결론:T 값은 n-gram 방법에서 누출을 얼마나 민감하게 감지할 것인지의 기준입니다. T 값이 너무 높으면 모델이 실제로 중요한 데이터 누출을 놓칠 수 있고, T 값이 너무 낮으면 불필요한 데이터까지 누출로 감지되어 false positive가 많아질 수 있습니다.따라서 적절한 T 값을 설정하는 것이 중요합니다. 실험에서는 T=0.25가 가장 적절한 임계값으로 보이며, 이는 모델이 최고 성능을 낸 경우입니다. |

[더보기 클릭]

Table 1: 모든 탐지 방법의 성능 종합 비교측정 지표:

Table 1은 다양한 모델과 방법에 대한 데이터 누출 감지 성능 (F1-score)을 비교한 표입니다. 각 방법은 Semi-half (S), Permutation (P), Permutation-R (PR), Permutation-Q (PQ), N-Gram (N) 등을 포함하며, 이들 각각의 방법이 MMLU와 HellaSwag 데이터셋에 대해 어떻게 성능을 발휘하는지를 보여줍니다. 주요 내용:

결과 해석:

|

주요 발견 2: 외웠다고 다 맞추는 건 아니다

흥미롭게도, 오염된 문제라고 해서 모델이 항상 정답을 맞추는 것은 아니었습니다:

- DeepSeek-7B: 오염된 문제 정답률 39.06%

- LLaMA-3.1-8B: 51.19%

- Gemini-2.0-Flash: 95.65%

이는 단순 암기와 실제 이해가 다르다는 것을 보여줍니다.

[더보기 클릭]

Table 2 자세히 설명Table 2는 데이터 누출이 감지된 MMLU 인스턴스에 대해 모델들의 정확도를 비교한 표입니다. 이 표는 각 모델이 누출된 데이터에서 얼마나 정확한 답을 제공하는지를 평가합니다.주요 내용:

결과 해석:

결론:

|

주요 발견 3: 특정 과목에서 더 심각

가장 오염이 심한 과목들:

- 해부학(Anatomy): 성능 하락 최대 35.4%

- 도덕 시나리오(Moral Scenarios): 가장 많은 오염 사례

- 형식 논리(Formal Logic): 오염 제거 후 큰 성능 하락

STEM 분야에서 특히 Qwen 모델의 오염이 심각했습니다 (8% 성능 하락).

실무적 시사점과 권고사항

연구자들을 위한 제언

- 오염 검사 의무화: 벤치마크 결과 발표 전 반드시 오염 검사 실시

- N-gram 방법 우선 사용: 가장 효과적이면서도 실용적

- 복수 방법 병행: 중요한 평가에서는 2-3가지 방법 동시 사용

AI 개발자들을 위한 제언

- 학습 데이터 투명성: 사용한 데이터셋 목록 공개

- 평가 데이터 격리: 학습 데이터에서 벤치마크 제외

- 정기적 오염 검사: 모델 출시 전 자체 검증

일반 사용자들이 알아야 할 점

- 벤치마크 점수 맹신 금물: 높은 점수가 항상 좋은 모델을 의미하지 않습니다

- 실제 사용 경험 중요: 벤치마크보다 실제 작업에서의 성능이 더 중요할 수 있습니다

- 다양한 평가 지표 참고: 한 가지 벤치마크만 보지 말고 여러 지표를 종합적으로 고려하세요

연구의 한계와 미래 방향

현재 방법들의 한계

- 반복 패턴 문제: "True/False" 같은 단순 패턴에서 오탐 발생 (False Positive)

- 계산 비용: 대규모 데이터셋에 적용 시 여전히 시간 소요

- 새로운 회피 기법: AI 회사들이 탐지를 피하는 방법 개발 가능성

향후 연구 방향

- 더 정교한 탐지 방법 개발: 머신러닝 기반 자동 탐지

- 실시간 모니터링 시스템: 지속적인 오염 감시 체계 구축

- 새로운 평가 패러다임: 오염이 불가능한 동적 평가 방식 개발

마무리: 이 연구가 우리에게 주는 교훈

이 연구는 단순히 기술적 문제를 넘어 AI 발전의 방향성에 대한 중요한 질문을 던집니다:

- 투명성의 중요성: AI 개발에서 투명성이 얼마나 중요한지 보여줍니다

- 평가의 공정성: 공정한 평가 없이는 진정한 발전이 어렵습니다

- 협력의 필요성: 학계와 산업계가 함께 해결책을 찾아야 합니다

'NLP' 카테고리의 다른 글

| [2025-2] 정유림 - Quantifying Attention Flow in Transformers (0) | 2025.11.08 |

|---|---|

| [2025-2] 백승우 - Agent Learning via Early Experience (0) | 2025.10.15 |

| [2025-2] 백승우 - Intent of Data Contamination (0) | 2025.09.13 |

| [2025-2] 백승우 - Kimi K2: Open Agentic Intelligence (0) | 2025.09.10 |

| [2025-2] 김민정 - Are Large Language Models Memorizing Bug Benchmarks? (0) | 2025.09.06 |