논문 : https://arxiv.org/abs/2406.18326

깃헙 : https://github.com/lleozhang/PaCoST

학회 : EMNLP 2024

아이디어

- 원본 인스턴스와 재구성된 인스턴스 간의 confidence를 비교해보자

방법

벤치마크 contamination 유형 정의

(1) 지시문 x와 답변 y 모두에 대해 다음 토큰 예측을 수행한다고 할 때, −logP(x,y)를 최소화

(2) 답변 에 대해서만 다음 토큰 예측을 수행한다고 할 때, −logP(y∣x)를 최소화

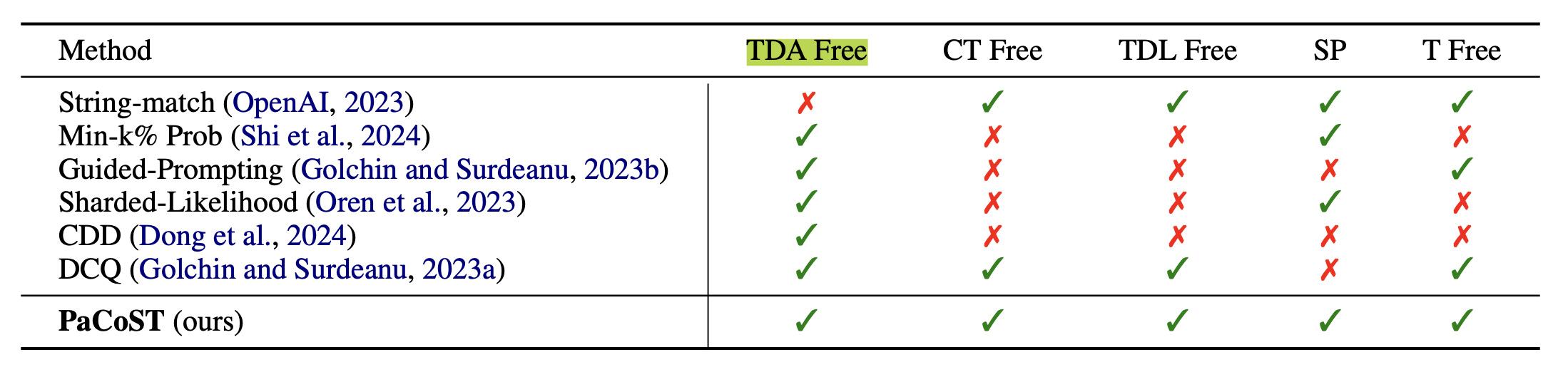

벤치마크 오염 탐지 방법이 충족해야 할 핵심 기준

- Training Data Access Free (TDA Free) - 학습 데이터 접근 불필요

- Contamination Type Free (CT Free) - 오염 유형 모두 제대로 동작해야 함

- Training Data Length Free (TDL Free) - 학습 데이터 길이에 제약이 없어야 함

- Stable Performance (SP) - 프롬프트나 설정 변화에 안정적으로 성능을 제공

- Threshold Free (T Free) - 임계값이 불필요

PaCoST

총 3단계로 진행

- rephrase preparation

- confidence estimation

- significance testing

1. rephrase preparation

- 주어진 인스턴스(x, y)에 대해, 우리는 모델 M_p를 사용하여 를 재구성된 x' = M_p(x)로 변환하고, 는 변경하지 않음

- 재구성하는 이유가 뭐냐?

- 1) 학습한 데이터, 학습하지 않은 데이터의 유사한 분포/난이도를 공유해야 함

- 2) 구현이 간단함

- 재구성 모델 (M_p) : Llama2-Chat-7B

- 재구성 품질 검증 : BERT-Score, human annotation

2. confidence estimation

- 다양한 신뢰도 추정 방법 중 P(True)을 사용

- 모델 M에게 출력 M(x)가 x에 대한 올바른 답변인지 질의한다고 할 때, 질의에 대한 출력 확률 분포를

- P(·|x,M(x),M) -> 신뢰도 P(True∣x,M(x),M)를 계산. 여기서 True는 모델 이 를 지지한다는 것을 의미

- P(True) 선택한 이유가 뭐냐?

- 1) 질의에 대한 출력 확률 분포를 직접 사용하면 overconfidence 문제 발생할 수 있음

- 2) 언어화된 신뢰도 추정 방법은 결과가 연속된 확률값이 아니라 종종 discrete 값을 생성하기 때문

3. significance testing

실험

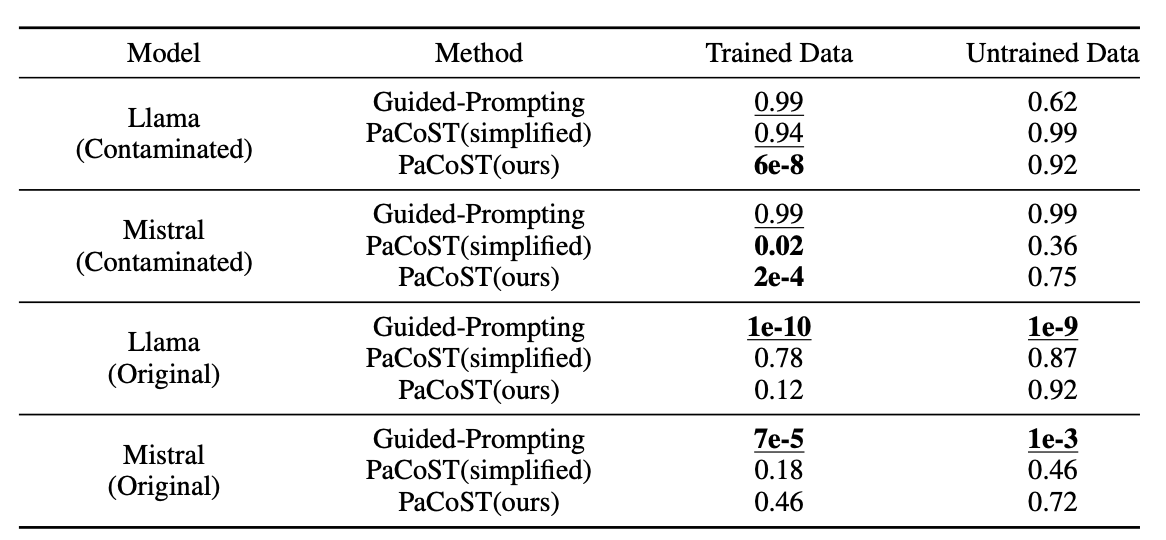

1. Intentional Contamination Experiments

- 모델 : Mistral-7B-Instruct-v0.2, Llama-2-7B-Chat

- 둘다 2023년도에 출시

- 데이터셋 : WMDP

- 생물학/화학/사이버 분야 3,668개의 객관식 질문

- 2024.05에 공개

- supervised fine-tuning (2번 오염 유형에 해당)

- 생물학 분할에서 1,000개의 샘플을 추출 -> 오염된 Llama와 Mistral 모델을 생성

- 나머지 데이터에서 400개의 샘플을 추출 -> 학습x 데이터로 사용

- baseline

- Guided-Prompting

- PaCoST(simplified) - 생성된 응답 대신 정답을 직접 사용하여 confidence를 계산하는 단순화된 버전

- PaCoST

- 추가로, DCQ, Min-k% Prob의 성능도 측정했으나 벤치마크 오염 탐지에 잘 작동하지 않았음.

- 동일한 설정에서, 샘플 수 다르게 해서 추가로 실험

2. Tests on Existing LLMs and Benchmarks

- 각 벤치마크에서 무작위로 400개의 샘플을 추출하여 탐지를 수행

- 모델

- Llama-2-Chat (7B, 13B)

- Llama-3-Instruct (8B)

- Mistral-Instruct (7B)

- Phi-3 (3.8B)

- Qwen1.5 (0.5B, 7B)

- Qwen2 (7B)

- Yi (6B)

- DeepSeek (7B)

- 데이터셋

- MMLU

- HellaSwag

- Arc-E, Arc-C

- TruthfulQA

- WinoGrande