1. Intro & Abstract : Clip과 확산 모델의 결합

CLIP + Diffusion model의 능력을 결합하여 나온 unclip은, 이미지의 의미와 스타일을 모두 팔로업하는 표현을 학습할 수 있는 CLIP과 이미지와 비디오 생성 작업에서 SOTA를 달성한 바 있는 확산 모델(diffusion)을 결합한 접근 방식이다. 결과적으로 text -> image generation 에 접근하는 모델이 되었다.

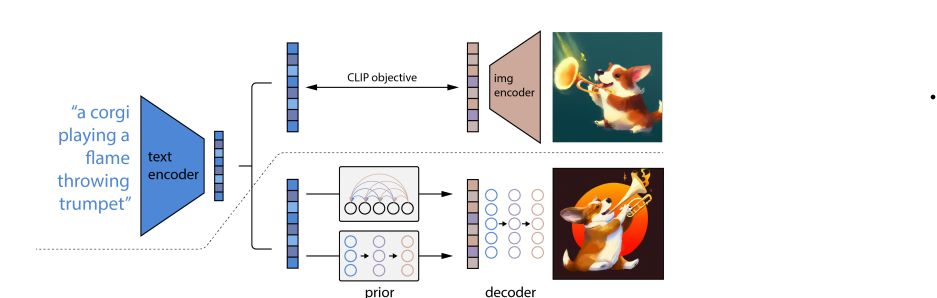

2. Method : 2단계 모델 구성

UnCLIP은 text caption이 주어졌을 때 크게 2가지 요소를 가지고 이미지를 생성한다. 하나는 text caption y가 주어졌을 때 Clip 이미지 임베딩을 생성하는 prior model P(zi|y)이고, 두 번째는 CLIP 이미지 임베딩(에 선택적으로 text caption y)를 조건으로 이미지를 생성하는 decoder P(X|zi, y)이다.

디코더는 이미지의 clip 이미지 임베딩이 주어졌을 때 이미지 반전이 가능해지고, P(Prior)은 이미지 임베딩 자체가 생성 모델을 학습할 수 있게 만든다. 이를 결합해서, text caption y가 주어졌을 때 x의 생성 모델 P(x|y)가 나온다.

3. 디코더 : CLIP 이미지 임베딩을 조건으로 이미지 생성

확산 모델을 사용해서 CLIP 이미지 임베딩( 및 optional 텍스트 캡션)을 조건으로 이미지를 생성하는 부분이다. 고해상도 이미지 생성을 위해 2개의 diffusion upsampler model을 훈련했는데, 하나는 64*64 -> 256*256으로 / 다른 하나는 256*256 -> 1024*1024로 upsampling하는 모델이다. 이때, 두 업샘플러의 견고성(robustness0을 위해 훈련 중 조건 이미지에 의도적으로 손상을 살짝 가했다.

4. Prior : text caption으로부터 CLIP 이미지 임베딩 생성

이미지 x를 생성하기 위해 decoder은 clip 이미지 임베딩 zi를 반전시키지만, text caption y로부터 zi를 생성하는 prior model이 필요하기도 하다. 이 prior을 위해 2가지 클래스 탐색이 이뤄졌다.

| Prior 종류 | 설명 | 장점 | 단점 / 특징 |

| Autogressive (AR) Prior | CLIP 이미지 임베딩 zi을 코드 시퀀스로 변환 -> caption y를 조건으로 autogressive predict 진행 | - | 계산 효율성이 낮음 |

| Diffusion Prior | 연속 벡터 zi를 캡션 y를 조거느올 | 계산 효율성과 샘플 품질이 높다 |

-> diffusion prior가 autogressive prior보다 효율성이나 샘플 품질 면에서 우수!

5. 이미지 control : CLIP Latent space의 활용

CLIP의 공동 embedding 공간은 zero-shot 방식으로 언어 기반 이미지 조작을 가능하게 한다. 입력 이미지를 인-디코딩해서 의미론적으로 유사한 출력 이미지를 생성하며, 이미지 임베딩을 CLIP latent space를 활용해 보간하여 입력 이미지 간 interpolation(보간)을 수행한다. CLIP을 사용하여 이미지를 텍스트 설명에 따라 의미론적으로 수정하는 textdiff 기능이 설명된다.

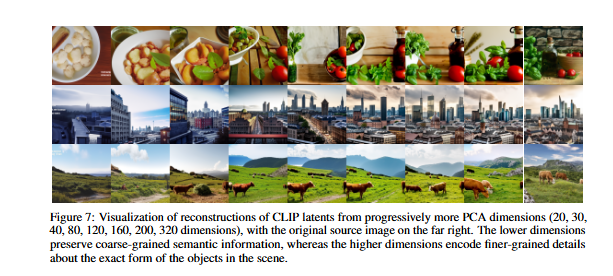

6. CLIP Latent space 탐색 : 디코더를 통한 시각화

디코더 모델은 CLIP 인코더가 인지하는 것을 직접 시각화하여 CLIP Latent space(잠재 공간)을 탐색할 수 있게 돕는다. 이를 통해 CLIP이 잘못된 예측을 하는 경우를 분석한다.

이때 낮은 PCA 차원은 의미론적 정보를 큰 틀에서만 보존하는 반면 높은 PCA 차원은 객체의 정확한 형태와 같은 세부사항(디테일)을 인코딩한다.

7. Text - 이미지 생성 (Prior의 중요성 및 비교 평가)

Prior은 사실 엄밀히 말해 필수적이다, 하는 부분은 아니지만 성능을 향상시키는 데 기여하는 것은 확실하다. 이때 Autoregressive prior와 diffusion prior을 비교한 결과 diffusion prior가 더 우수했다. 평가로는 Unclip, glide에 대한 인간 평가가 이뤄졌다. 이때 unclip이 glide보다 다양성 측면에서 강점을 보였으며, ms-coco 벤치마크에서 unclip이 새로운 최첨단 fid 점수를 달성했다. 자동화된 미학 품질 평가에서도 unclip이 glide와 비교하여 우수한 성능을 보였다. 세부 성능은 아래와 같다.

| 모델 | 포토리얼리즘 선호도(vs GLIDE) | 캡션 유사성 선호도( vs GLIDE) | 다양성 선호도 (vs GLIDE) |

| UnCLIP(AR Prior) | 47.1% ± 3.1% | 41.1% ± 3.0% | 62.6% ± 3.0% |

| UnCLIP(Diffusion Prior) | 48.9% ± 3.1% | 45.3% ± 3.0% | 70.5% ± 2.8% |

8. 한계 및 위험

Unclip은 위 GLIDE 모델보다 객체에 속성을 바인딩하는 데 더 취약하다. (객체에 특정 속성을 연결하는 것에 약점이 있다는 의미) 일관된 텍스트를 생성하는 데 어려움을 겪는다는 점도 있다. 복잡한 장면에서 세부 묘사가 부족하다는 한계도 지적된다.

Unclip의 성능 향상은 기만적이거나 유해한 콘텐츠와 관련된 위험 프로필을 높인다는 점도 밝혀졌다. 기술이 성숙함에 따라 AI 생성 이미지의 흔적이 줄어들어 생성된 이미지를 실제 이미지로 오인하기 쉬워진다는 점도 언급된다. 훈련 데이터의 편향 학습 방식 변화에 대한 추가 연구가 필요하다는 점이 제시되었다.

9. 결론 및 향후 연구 방향

unCLIP은 CLIP 잠재 공간을 활용해서 텍스트 조건부 이미지 생성에서 유망한 결과를 보였다. 이미지 다양성을 높이고, 이미지의 의미와 스타일을 유지하면서 세부 사항을 변경하는 데 효과적이라는 것을 재확인했다. Diffusion prior가 Autoregressive prior보다 우수하다는 점을 강조했다. 하지만 객체-속성 바인딩 및 텍스트 생성과 같은 특정 영역에서 개선이 필요하다.