논문 링크: 2310.04378

참고 유튜브 링크: [Open DMQA Seminar] Accelerating Diffusion Models - Consistency Models and Hybrid Approach - YouTube

참고 논문 리뷰 블로그 링크: Latent Consistency Models : Synthesizing High-Resolution ImagesWith Few-Step Inference 논문 리뷰 :: LOEWEN

Latent Consistency Models : Synthesizing High-Resolution ImagesWith Few-Step Inference 논문 리뷰

0. 요약문제의식이 논문은 고해상도 이미지 생성을 위한 Latent Diffusion Models의 샘플링 속도가 느리다는 문제에 주목함. 기존의 LDMs는 반복적인 reverse process을 통해 점진적으로 노이즈를 제거해야

loewen.tistory.com

1. Introduction

- Diffusion Model의 부상

- 확산(디퓨전) 모델은 다양한 도메인(이미지, 오디오, 텍스트 등)에서 강력한 생성 성능을 보여주어 많은 주목을 받고 있음.

- 특히, Stable Diffusion과 같은 Latent Diffusion Model (LDM)은 고해상도 text-to-image 합성에서 탁월한 성능을 시연.

- 문제의식: 느린 sampling 속도

- 디퓨전 모델은 반복적인 reverse process로 노이즈를 점진적으로 제거해야 하므로, 샘플링 step이 많다(수십~수백).

- 실시간/인터랙티브 애플리케이션에는 부적합.

- 본 논문의 기여

- Latent Consistency Model (LCM) 제안

- Stable Diffusion의 오토인코더(Encoder/Decoder)를 사용한 latent space에서 Consistency 아이디어를 적용.

- 단 1~4단계의 inference로도 고해상도(예: 768×768) 이미지 생성 가능.

- Classifier-free guidance(CFG)까지 통합하여 조건부(diffusion)에도 대응.

- One-stage guided distillation

- 증강된 PF-ODE를 풀어, one-shot으로 guided diffusion 모델(Stable Diffusion)을 distill.

- Latent Consistency Fine-tuning (LCF)

- 사전 학습된 LCM을 맞춤형(custom) 데이터셋에 추가 학습 → few-step inference 유지하면서도 특정 도메인으로 전문화.

- Latent Consistency Model (LCM) 제안

2. Related Work

- Diffusion Models (DDPM, iDDPM, etc.)

- 이미지의 forward process: 원본 → 노이즈

- reverse process: 노이즈 → 원본 복원

- 높은 품질이지만 많은 reverse step 필요.

- LDM: Latent Diffusion Model (Stable Diffusion)

- 고차원 픽셀 공간 대신, VAE 기반 오토인코더의 latent space에서 diffusion 수행.

- 계산 비용/메모리 사용 크게 절감, 고해상도 이미지 가능.

- ODE Solver 개선

- DDIM, DPM-Solver, DPM-Solver++ 등: 샘플링 단계를 10~20 정도로 줄여 품질·속도 균형을 추구.

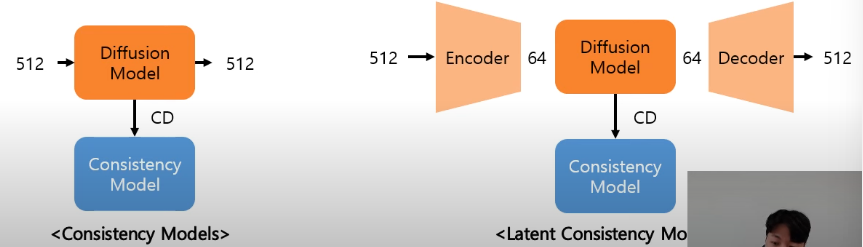

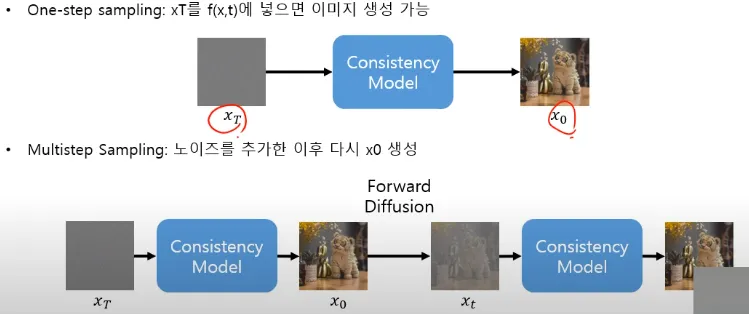

- Consistency Model (CM)

- ODE 해 궤적 상에서 단일 단계로 최종 이미지를 추론하는 일관성(consistency) 맵핑 학습.

- 그러나 픽셀 공간 중심, 고해상도나 조건부 생성에는 부적합.

3. Consistency Model & Latent Space

3.1 Consistency Model 개념

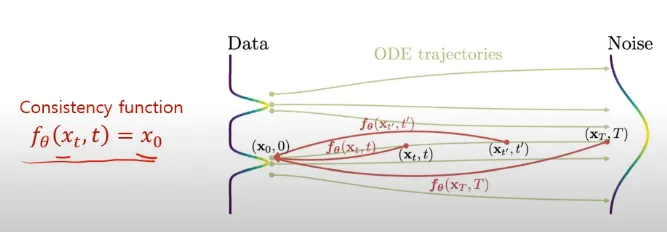

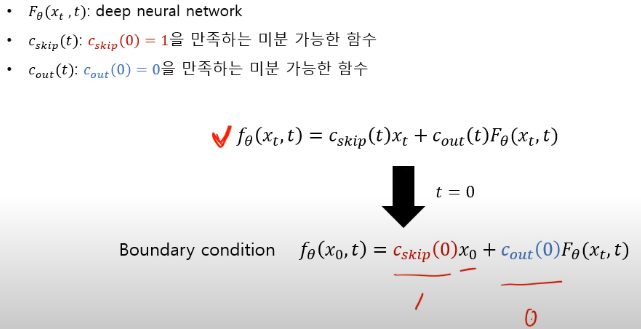

- Consistency Function $f_\theta$:

- PF ODE trajectory(궤도)에 위치하는 $x_t$를 입력 받았을 때, $x_0$를 return.

- 모든 $x_t$를 넣었을 때, $x_0$를 return하는 $f_\theta$.

- 특징(1): Self-consistency:

- 임의의 $x_t$에 대해 동일한 출력값($x_0$)을 가져야 함.

- 특징(2): Boundary condition:

- $x_0$를 입력하면 identity function이 되어야 함($x_0$를 넣어도 $x_0$).

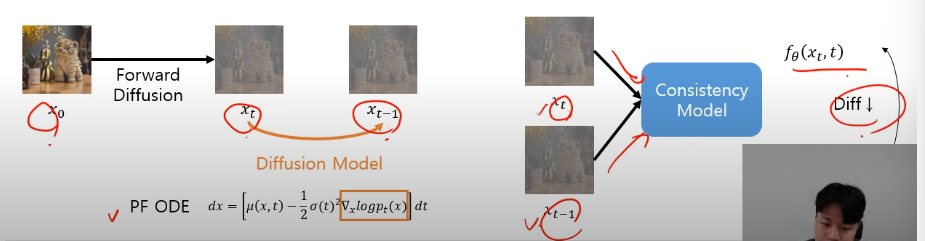

- Consistency Model(CM) 학습 방법

- Coinsistency Distillation(CD): pre-trained diffusion model 활용.

forward-process를 통해 noise 추가 후 $x_t$로부터 동일한 PF ODE 상에 존재하는 $x_(t-1)$ 획득해 이를 consistency model에 넣음.

- Coinsistency Training(CT): pre-trained diffusion model 활용 X, 오직 CM만 사용.

forward-process를 통해 noise 추가 후 바로 consistency model에 넣음.

-

Consistency Training (CT) Consistency Distillation (CD) 목적 Diffusion 모델을 직접 consistency model로 학습 기존 diffusion 모델을 활용하여 consistency 모델로 변환 학습 방식 모델이 자기 자신과 일관성 있는 예측을 하도록 훈련 Pre-trained Teacher Diffusion Model을 student model로 distillation Teacher Diffusion Model 필요 여부 ❌ ✅ (기존 모델을 기반으로 학습) Loss:

$\mathbb{E}_{x_t, t} \left[ \| f_\theta(x_t, t) - f_\theta(\hat{x}_t, t - \Delta t) \|^2 \right]$self-supervised 방식으로 loss를 최적화 Teacher Model이 생성한 샘플을 이용해서 Student Model을 consistency loss로 학습 샘플링 속도 빠름 (few-step 가능) 더 빠름 (1-step 또는 2-step 가능) - → LCM에선 CD 사용: LCM은 LDM을 기반으로 학습.

- → Loss는 같음: $f_\theta$가 연속적인 두 샘플링 단계에서 일관된 출력(consistency)을 유지하도록 학습함.

- Coinsistency Distillation(CD): pre-trained diffusion model 활용.

- PF ODE trajectory(궤도)에 위치하는 $x_t$를 입력 받았을 때, $x_0$를 return.

3.2 Latent Space & Stable Diffusion

- 오토인코더 $(E, D)$:

- 이미지 $x$를 압축한 latent 벡터 $z = E(x)$

- 복원 시 $\hat{x} = D(z)$로 디코딩

- LDM(Stable Diffusion)은 이 latent 공간에서 노이즈 제거 과정을 수행 →

- 계산량 감소, 고해상도 지원

- LCM: 픽셀 대신 latent 공간에서 consistency distillation을 수행 (Latent Consistency Distillation, LCD).

-

4. Latent Consistency Model (LCM)

4.1 Consistency Distillation in the Latent Space

1. PF-ODE(Probability Flow ODE)

-

- Forward SDE와 동일한 확률 분포를 갖는 ODE.

- data의 distribution이 noise로 가는 과정에서 $x_t$들이 정의되는데, 이 분포들이 동일함.

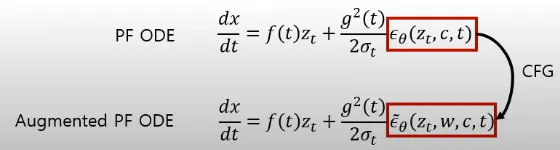

4.2 One-Stage Guided Distillation (Classifier-Free Guidance 통합)

1. CFG(Classifier-Free Guidance, scale $\omega$):

- condition이 들어간 output에 큰 가중치를 부여.

- 고품질 합성을 위해 $\omega \ge 6$ 이상 사용.

2. Augumented PF-ODE:

- CFG가 포함된 diffusion model의 output을 활용해 CD 진행.

- 여기서 ODE Solver(DPM-Solver)를 사용하여 PF-ODE를 빠르게 해결함.

3. 1-Stage distillation

- 기존 방식(2-stage distillation):

- Multi-Step sampling이 가능한 모델을 학습한 후, 이를 One-Step sampling이 가능하도록 distill하는 방식.

- LCM은 one step으로 CFG를 반영.

- 성능 저하를 방지하기 위함.

- 기존 방식은 디스틸하는 단계에서 오차 누적 및 큰 계산 비용 발생 문제가 있음.

4.3 Accelerating Distillation with Skipping Time Steps

1. Stable Diffusion은 1000개 이상의 timestep 스케줄 사용.

- 각 인접 단계 $(t_{n+1} \rightarrow t_n)$ 일관성만 강제하면 수렴이 느리다.

2. Skipping-Step

- $(t_{n+k} \rightarrow t_n)$ 식으로 더 큰 간격을 뛰어넘어 일관성 학습.

- 적절한 $k$로 설정해, 학습 스텝 단축 & 결과 품질 균형.

- 여기서 ODE Solver(DPM-Solver)를 활용하여, 샘플링을 간략히 시뮬레이션함.

→ 즉, 큰 timestep 간격을 뛰어넘으면서도 모델이 학습할 수 있도록 보정하는 역할.

4.4 Latent Consistency Fine-tuning (LCF)

1. Fine-tuning:

- 사전 학습된 LCM을 특정 도메인(포켓몬, 심슨 등)에 추가 학습.

- Teacher diffusion model 없이도, few-step 가능(CT 아님).

- LCM이 이미 CD를 사용해서 Teacher-Free Sampling이 가능하도록 학습되었기 때문에 가능.

- 그래서 특정 도메인(Fine-tuning)에서도 추가적인 Teacher Model 없이 Few-Step로 학습할 수 있음.

- 기존 diffusion fine-tuning보다 계산이 훨씬 효율적.

5. Experiments

5.1 Text-to-Image Generation

Dataset: LAION-Aesthetics-6+ (12M), LAION-Aesthetics-6.5+ (650K)

Resolution: 512×512, 768×768

Metric: FID, CLIP score, 등

결과:

- LCM은 1~4단계 샘플링만으로도 고화질 이미지 생성.

- CFG scale $\omega=8$에서 FID 대폭 개선, CLIP 점수도 우수.

5.2 Ablation Study

ODE solver vs. Skipping step $k$

- DDIM vs. DPM-Solver++ 등 비교

- Skipping step을 크게 잡으면 빠른 수렴, 단 너무 크면 근사 오차 증가

CFG scale $\omega$

- $\omega$ 가 클수록 이미지 품질(묘사 디테일)은 좋아지나, 왜곡·Artifact도 증가할 수 있음.

- LCM은 폭넓은 $\omega$ 범위에서 우수한 성능 유지.

1~4-step Inference 품질

- 1-step은 완전 실시간 수준이나 품질이 다소 떨어질 수 있음

- 4-step 시, 기존 10~20-step 디퓨전과 맞먹거나 더 나은 품질 달성.

5.3 Downstream Consistency Fine-tuning

포켓몬/심슨 데이터셋

- LCF 활용 시, 4-step LCM으로 빠르고 품질 좋은 결과.

- 사후 fine-tunning 시 custom 스타일에도 대응 가능.

6. Conclusion

- LCM은 Stable Diffusion 수준의 고해상도 이미지를, 불과 1~4단계의 샘플링만으로 효율적으로 생성할 수 있는 새로운 Consistency 기반 모델이다.

- 특징:

- Latent 공간에서 일관성(distillation) 수행

- Classifier-free guidance(CFG)를 1-step으로 통합

- Skipping-step 기법으로 학습 가속

- Fine-tuning으로 다양한 도메인 확장 가능