Multi-Modal

[2026-1] 장인영 - BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Model

inyeong

2026. 2. 21. 02:07

논문 링크 : https://arxiv.org/abs/2301.12597

BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models

The cost of vision-and-language pre-training has become increasingly prohibitive due to end-to-end training of large-scale models. This paper proposes BLIP-2, a generic and efficient pre-training strategy that bootstraps vision-language pre-training from o

arxiv.org

1. Introduction

연구 배경

- Vision-Language Pre-training (VLP)은 최근 대규모 모델과 데이터셋을 기반으로 빠르게 발전해 왔지만,

대부분의 최신 모델은 end-to-end 방식으로 사전 학습되어 매우 높은 계산 비용을 요구한다. - Vision-Language 연구는 본질적으로 Vision과 Language의 교차 영역에 있음에도,

이미 사전 학습된 unimodal 모델을 효과적으로 활용하지 못하는 한계가 있다.

제안 내용

- 이를 해결하기 위해 본 논문은 사전학습된 image encoder와 LLM을 frozen 상태로 유지한 채 활용하는

계산 효율적인 VLP 프레임워크인 BLIP-2를 제안한다. - BLIP-2의 핵심 구성 요소는 Q-Former (Querying Transformer)이다.

Q-Former는 학습 가능한 query embeddings를 사용하여 frozen image encoder로부터 텍스트와 가장 관련된 시각 표현을 추출하고, 이를 frozen LLM이 해석 가능한 형태로 전달하는 information bottleneck 역할을 수행한다.

BLIP-2 프레임워크 개요 - 이를 위해 두 단계의 사전학습 전략을 사용한다.

1단계에서는 frozen image encoder와 연결된 Q-Former를 학습하며, vision-language representation learning을 수행한다. 2단계에서는 Q-Former의 출력을 frozen LLM과 연결하여 vision-to-language generative learning을 수행한다. - 이를 통해 Q-Former는 시각-언어 정렬을 학습하고, LLM은 파라미터 업데이트 없이 시각 조건 기반 텍스트 생성을 수행할 수 있다.

결과

- BLIP-2는 visual question answering(VQA), image captioning, image-text retrieval 등 다양한 vision-language 태스크에서 state-of-the-art 성능을 달성하였다. 특히 기존 대규모 모델 대비 훨씬 적은 trainable parameters만으로 경쟁력 있는 성능을 보이며, 계산 효율성과 확장성을 동시에 확보하였다.

2. Related Work

2.1. End-to-end Vision-Language Pre-training

- End-to-end Vision-Language Pre-training(VLP)은 이미지와 텍스트를 공동으로 학습하여 멀티모달 파운데이션 모델을 구축하는 접근 방식이다. 이를 위해 dual-encoder, fusion-encoder, encoder-decoder, unified transformer 등 다양한 아키텍처가 제안되어 왔다.

- 그러나 대부분의 방법은 대규모 이미지-텍스트 쌍 데이터셋을 사용하여 모델 전체를 end-to-end로 사전학습하기 때문에, 모델 규모가 증가할수록 계산 비용이 급격히 증가하고, 이미 강력하게 사전학습된 unimodal 모델을 유연하게 활용하기 어렵다는 한계를 가진다.

2.2. Modular Vision-Language Pre-training

- 이러한 문제를 완화하기 위해, 사전학습된 image encoder 또는 language model을 frozen 상태로 유지하는 modular Vision-Language pre-training 접근이 제안되었다.

- 일부 연구는 image encoder를 고정한 채 시각 특징을 추출하고, 다른 연구는 LLM을 고정하여 vision-to-language generation에 활용한다. 특히 frozen LLM을 사용할 경우, 시각 표현을 텍스트 표현 공간에 효과적으로 정렬(alignment)하는 것이 핵심 과제이다.

- 이를 위해 Frozen은 image encoder 출력을 LLM의 soft prompt로 직접 사용하고, Flamingo는 LLM 내부에 cross-attention layers를 삽입하여 시각 정보를 주입한다. 두 방법 모두 language modeling loss를 통해 이미지 조건부 텍스트 생성을 학습한다.

- BLIP-2는 이러한 기존 방법들과 달리, frozen image encoder와 frozen LLM을 모두 활용하면서 Q-Former를 통해 모달리티 정렬을 수행한다. 이를 통해 더 낮은 계산 비용으로 강력한 Vision-Language 성능을 달성한다.

3. Method

3.1. Model Architecture

- Frozen image encoder와 large language model(LLM)은 입력 표현의 구조와 학습 방식이 다르기 때문에 직접 연결하기 어렵다. BLIP-2는 이러한 모달리티 간 불일치를 해결하기 위해 Querying Transformer (Q-Former)를 중간 매개 모듈로 도입한다.

- frozen image encoder와 상호작용하는 image transformer

- text encoder와 text decoder로 동작할 수 있는 text transformer

- 두 모듈은 self-attention을 공유하며, cross-attention을 통해 image features와 상호작용한다.

- Q-Former의 핵심 구성 요소는 32개의 learnable query embeddings이다. 이 쿼리들은 cross-attention을 통해 frozen image encoder의 고차원 출력과 상호작용하며, 텍스트와 가장 관련된 시각 표현을 선택적으로 추출한다.

- 그 결과, Q-Former는 고차원의 이미지 특징을 고정 크기의 query representation으로 압축하는 information bottleneck 역할을 수행한다. Q-Former는 약 188M parameters로 구성되며, frozen image encoder와 frozen LLM 사이의 효과적인 vision-language alignment를 가능하게 한다.

3.2. Bootstrap Vision-Language Representation Learning from a Frozen Image Encoder

- 1단계에서는 frozen image encoder와 연결된 Q-Former를 사전학습하여, 텍스트와 관련된 시각 표현을 학습하도록 한다.

- Image-Text Contrastive Learning (ITC)

Query outputs와 텍스트의 [CLS] token representation 간 유사도를 계산하여 image-text alignment를 학습한다. 여러 query 출력 중 가장 높은 유사도를 image-text similarity로 사용한다. - Image-grounded Text Generation (ITG)

Multimodal causal self-attention mask를 적용하여, queries가 이미지로부터 필요한 정보를 먼저 추출한 후 텍스트 생성에 활용되도록 학습한다. - Image-Text Matching (ITM)

Bi-directional self-attention mask를 사용하여 queries와 텍스트가 완전히 상호작용하도록 하며, image-text pair의 일치 여부를 예측하는 이진 분류 과제를 통해 fine-grained alignment를 학습한다.이를 위해 세 가지 pre-training objectives를 공동 최적화한다.

- Image-Text Contrastive Learning (ITC)

- 이 단계의 목적은 Q-Former가 LLM에 전달할 language-informative visual representation을 학습하도록 하는 것이다.

3.3. Bootstrap Vision-to-Language Generative Learning from a Frozen LLM

- 2단계에서는 Q-Former의 출력을 frozen LLM과 연결하여 vision-to-language generation을 학습한다. Q-Former의 출력은 fully-connected layer를 통해 LLM의 text embedding 차원으로 선형 투사되며, 텍스트 토큰 앞에 추가되어 soft visual prompts로 사용된다.

- 1단계에서 vision-language alignment가 이미 학습되었기 때문에, 이 단계에서는 LLM의 파라미터를 업데이트하지 않고도 시각 조건 기반 텍스트 생성을 수행할 수 있다. 또한 Q-Former가 information bottleneck 역할을 수행함으로써, LLM이 직접 모달 정렬을 학습할 필요를 줄이고 catastrophic forgetting을 완화한다.

3.4. Model Pre-training

- BLIP-2는 약 1억 2천9백만 장 규모의 이미지-텍스트 데이터셋을 사용하여 사전학습을 수행한다. 데이터 구성은 COCO, Visual Genome, CC3M, CC12M, SBU, 그리고 LAION400M 일부를 포함한다.

- 웹 이미지의 캡션 품질을 향상시키기 위해 CapFilt 방법을 적용한다. CapFilt는 BLIP-Large captioning model을 사용하여 이미지당 여러 개의 synthetic captions을 생성하고, CLIP ViT-L/14 기반 image-text similarity 점수를 통해 상위 캡션을 선별하는 데이터 필터링 전략이다.

- Frozen image encoder로는 CLIP ViT-L/14와 EVA-CLIP ViT-g/14를 사용하며, frozen LLM으로는 decoder-based 모델인 OPT와 encoder-decoder 기반 모델인 FlanT5를 사용한다.

- 두 단계(pre-training stage 1: representation learning, stage 2: generative learning) 전략과 frozen unimodal models의 활용을 통해, 기존 대규모 end-to-end VLP 방법 대비 높은 계산 효율성을 달성한다.

4. Experiment

4.1. Instructed Zero-shot Image-to-Text Generation

- BLIP-2는 frozen LLM의 instruction-following capability를 유지하면서 이미지 정보를 이해할 수 있음을 보여준다. 시각 프롬프트(visual prompts)와 텍스트 지시문을 함께 입력하면, 모델은 zero-shot 환경에서도 지시에 따른 image-to-text generation을 수행한다.

- Zero-shot VQA 실험에서 BLIP-2는 VQAv2와 GQA 데이터셋에서 state-of-the-art 성능을 달성하였다. 특히 Flamingo 80B 대비 최대 8.7% 높은 성능을 보이면서도 54배 적은 trainable parameters만을 사용하였다. 또한 더 강력한 image encoder(ViT-g)나 더 큰 LLM(OPT, FlanT5)을 사용할수록 성능이 향상되는 경향이 관찰되었다. 이는 BLIP-2가 unimodal 모델의 발전을 효율적으로 활용할 수 있는 generic framework임을 보여준다.

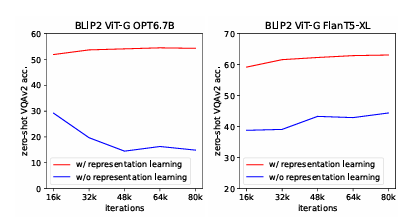

Zero-shot Visual Question Answering에서의 SOTA 비교 결과 - 또한 1단계 vision-language representation learning의 중요성도 실험적으로 확인되었다. 해당 단계를 제거할 경우 zero-shot VQA 성능이 크게 감소하며, 특히 OPT 기반 모델에서는 catastrophic forgetting 현상이 발생하였다.

4.2. Image Captioning

- COCO에서 fine-tuning을 수행한 결과, BLIP-2는 COCO test set뿐 아니라 out-of-domain 데이터셋인 NoCaps에서도 기존 방법 대비 향상된 성능을 보였다. 이는 frozen LLM을 유지한 상태에서도 Q-Former와 image encoder를 학습함으로써 강한 일반화 성능을 확보할 수 있음을 보여준다.

4.3. Visual Question Answering

- VQA에서는 open-ended answer generation 방식으로 fine-tuning을 수행하였다. 질문 토큰을 Q-Former에 함께 입력하여, cross-attention이 질문과 관련된 이미지 영역에 집중하도록 유도하였다. 그 결과 BLIP-2는 open-ended generation 모델 중 state-of-the-art 수준의 성능을 달성하였다.

4.4. Image-Text Retrieval

- Image-text retrieval에서는 LLM 없이 1단계에서 사전학습된 Q-Former와 image encoder를 활용하여 fine-tuning을 수행하였다. BLIP-2는 zero-shot 및 COCO fine-tuning 환경 모두에서 기존 방법 대비 향상된 검색 성능을 기록하였다.

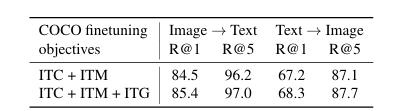

Image-Text Retrieval 성능 비교 (Flickr30K 및 COCO) - 또한 ITG(image-grounded text generation) loss가 retrieval 성능 향상에도 기여함을 확인하였다. 이는 representation learning 단계에서 queries가 language-informative visual features를 학습하도록 설계된 것이 타당함을 뒷받침한다.

5. Limitation

- BLIP-2는 in-context learning 능력을 충분히 활용하지 못한다. 이는 사전학습 데이터가 단일 image-text pair로 구성되어 있어, 하나의 시퀀스 내에서 여러 쌍 간의 관계를 학습하지 못했기 때문으로 분석된다.

- 또한 image-to-text generation 결과는 부정확한 지식, 잘못된 추론 경로, 최신 정보 부족 등의 문제를 포함할 수 있다. 더불어 frozen LLM을 사용하기 때문에 사회적 편향, 유해 표현 생성, 개인정보 노출 등의 위험을 그대로 상속한다. 이를 완화하기 위해 instruction-based control 및 filtered datasets의 활용이 제안된다.

6. Conclusion

- BLIP-2는 frozen image encoder와 frozen LLM을 활용하는 계산 효율적인 Vision-Language pre-training 프레임워크이다. Q-Former 기반의 2단계 사전학습 전략을 통해 vision-language alignment를 효과적으로 수행하며, 적은 trainable parameters로도 다양한 Vision-Language 태스크에서 state-of-the-art 성능을 달성하였다.

- 또한 zero-shot instructed image-to-text generation 능력을 통해 멀티모달 파운데이션 모델의 확장 가능성을 보여준다.