[2025-2] 박제우 - The Impact of Reasoning Step Length on Large Language Models

https://arxiv.org/abs/2401.04925

The Impact of Reasoning Step Length on Large Language Models

Chain of Thought (CoT) is significant in improving the reasoning abilities of large language models (LLMs). However, the correlation between the effectiveness of CoT and the length of reasoning steps in prompts remains largely unknown. To shed light on thi

arxiv.org

본 논문은 2024 ACL Findings에 등재된 논문으로, 2025년 12월 기준 176회 인용되었다.

1. Introduction

그동안 CoT(Chain of Thought)프롬프팅은 cross domain, length generalization, cross lingual 과제 등에서 높은 성능을 보였다.

그러나 이러한 CoT 계열 프롬프트 엔지니어링이 왜/어떻게 효과적으로 작동하는지에 대한 연구는 아직까지 진행되지 않았다. 즉 CoT 내부의 작동 원리를 구조적으로 이해할 필요가 있다는 것이 이 연구의 출발점이 되었다.

본 논문의 핵심 가설은 추론 단계(reasoning step)가 CoT 프롬프트의 효과를 결정하는 핵심적인 요소라는 것이다.

실험에서는 Zero Shot CoT 추론과 Few Shot CoT 추론을 사용했는데 각각은 모든 조건을 동일하게 유지하고 추론 단계만 다르게 해서 성능 변화를 확인했다.

Zero Shot 실험에서는 프롬프트를 "Let's think step by step"에서 “Let’s think step by step, you must think more steps”으로 수정했다.

Few Shot 실험에서는 Demo Sample 내의 추론 단계를 확장시켰다. 그 외에 다른 조건이나 새로운 정보가 개입되는 것은 엄격히 통제했다.

실험 결과 추론 단계 수와 LLM의 추론 능력 사이에는 유의미한 상관관계가 발견되었다. 또한 추론 과정에 잘못된 정보가 개입되더라도 여전히 성능이 향상되었다.

즉 추론 단계의 정확성보다는 길이가 훨씬 모델 성능에 영향을 많이 미친다는 뜻이다. 이 논문의 기여는 아래와 같다.

- Few-shot CoT에서는 추론 단계 수와 정확도 사이에 직접적인 선형 상관관계가 존재한다.

- 잘못된 추론 근거(rationale)라도 요구되는 추론 길이만 유지된다면 성능 향상이 가능하다.

- Zero-shot CoT에서도 추론 단계를 늘리면 LLM 정확도가 유의미하게 향상된다.

2. Related Works

2.1 CoT Prompting

언어 모델의 성능을 프롬프트의 관점에서 높이기 위해서는 대표적으로 In Context Learning 방식과 CoT 추론이 있다.

먼저 2020년 Brown 등의 연구에 따르면, In Context Learning 방식은 복잡한 추론 과제에서 한계를 보임이 밝혀졌다.

이를 개선시켜, Wei 등은 모델 demo에 일련의 논리적 추론 단계를 통합하는 CoT 방식을 제안했고 명시적인 추론 단계 시퀀스를 출력함으로써 맥락을 더욱 깊이 이해할 수 있었다.

2022년에는 더 나아가 등장한 Auto CoT 방식이 등장했는데, 이는 말 그대로 CoT를 자동화 시켜주는 방식이다.

2.2 Preliminary Work on Analyzing CoT

초기 연구로 Madaan과 Yazdanbakhsh(2022)는 프롬프트를 기호, 패턴, 텍스트로 분해하고 반사실적 프롬프팅을 통해 CoT의 구성 요소가 추론에 미치는 영향을 분석하였다.

Tang 등(2023)은 CoT 추론이 사전학습된 의미 지식에 크게 의존하며, 기호적 추론에는 한계가 있음을 보였다. Wang 등(2023)은 추론 단계의 정확성보다도 단계들의 ‘관련성과 순서’가 더 중요함을 실험적으로 밝혔다.

Li 등(2023)은 CoT를 다단계 조합 함수로 이론화하여 인컨텍스트 러닝을 단순화하는 역할을 설명하였다.

또한 Merrill과 Sabharwal(2023)은 중간 추론 단계 수가 많을수록 추론 성능이 함께 증가함을 관찰하였다.

3. Analyzing Method

3.1 Preliminary

Zero Shot CoT : “Let’s think step by step”과 같은 문구를 프롬프트에 추가하는 템플릿 기반 zero-shot 방식이다.

Few Shot CoT : 프롬프트 안에 CoT 추론이 포함된 여러 개의 예시(demonstration)를 함께 제공하는 방식이다.

Manual CoT : 사람이 직접 설계한 소수의 시연 예제를 사용하는 Few-Shot-CoT 방식으로, 각 예제는 ‘질문 + 추론 과정 + 최종 답’으로 구성

Auto CoT : 질문들을 클러스터링하여 다양한 예시를 자동 선택한 뒤, 모델의 zero-shot 추론 능력을 이용해 CoT 추론 예시를 자동 생성하는 방법

3.2 Analyzing Zero-shot CoT

Zero-shot 환경에서는 CoT 예시를 직접 추가할 수 없기 때문에, 기존의 “Let’s think step by step” 프롬프트를 “Let’s think step by step, you must think more steps”로 수정하는 방식만 사용했다.

그 결과, 추가 학습이나 예시 없이도 zero-shot 환경에서 추론 정확도가 유의미하게 향상되었다.

이는 CoT 성능 향상의 핵심이 예시 자체가 아니라 추론 단계의 길이에 있음을 보여준다.

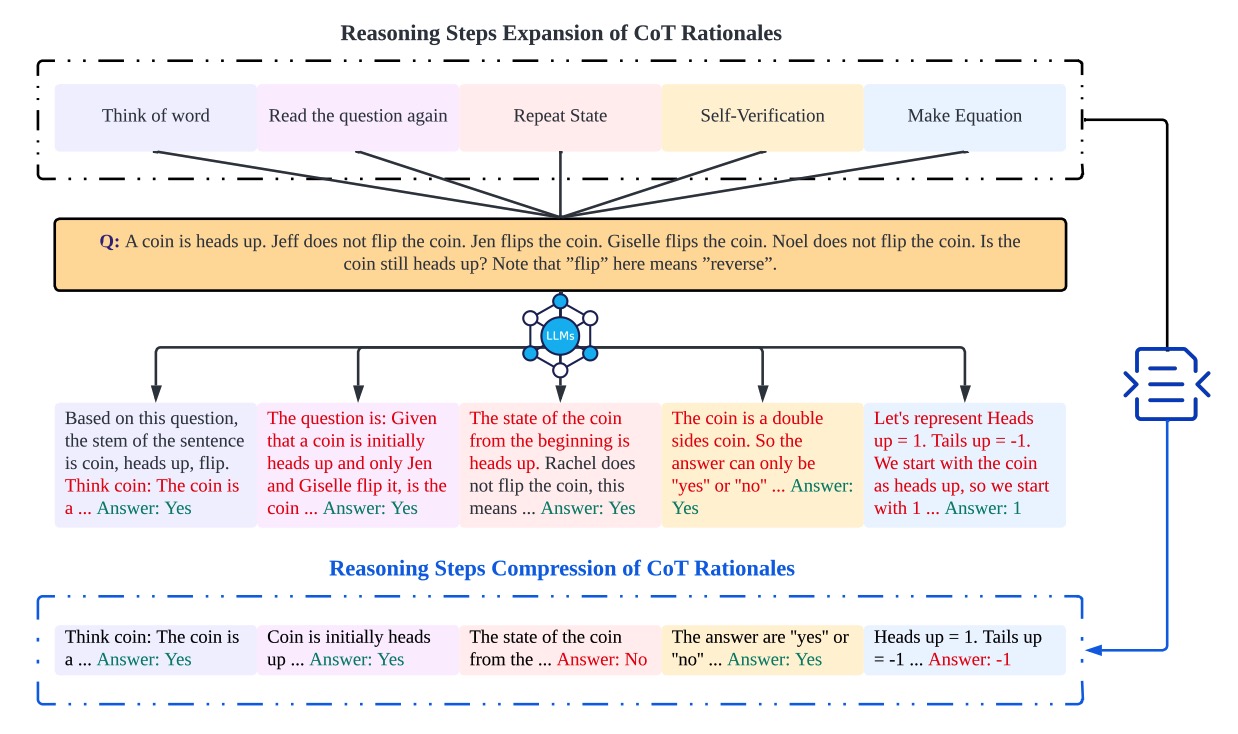

3.2 Analyzing Few-shot CoT

Few-shot CoT 실험에서는 CoT 추론 체인 안의 추론 단계를 인위적으로 늘리거나 줄여서, 추론 구조 변화가 LLM의 성능에에 어떤 영향을 주는지를 분석했다.

이때 가장 중요한 조건은 새로운 문제 관련 정보는 절대 추가하지 않고, 오직 추론 단계만 조절했다는 점이다.

추론 단계 설정은 질문 반복, 단어 의미 분석, 상태 요약, 수식화, 자기 검증과 같은 패턴을 추론 단계 확장 전략으로 사용했다.

저자들은 이러한 프롬프팅 전략이 인간의 추론 과정을 모방하고 있다고 한다.

Think About The Word (단어에 대해 생각하기)

Read the Question Again (질문 다시 읽기)

Repeat State (상태 반복 요약)

Self-Verification (자기 검증)

Make Equation (수식 만들기)

전반적으로 이러한 프롬프트 전략들은 모델의 응답에서 서로 대응되는 패턴이 일관되게 관찰되었다.

4. Experimental Results

데이터셋 : MultiArith, GSM8K, AQuA, SingleEq, SVAMP, Letter, Coin, StrategyQA

모델 : text-davinci-002, GPT-3.5, GPT-4

프롬프팅 : Zero Shot, Zero Shot CoT, Manual CoT, Auto CoT

평가지표 : Accuracy

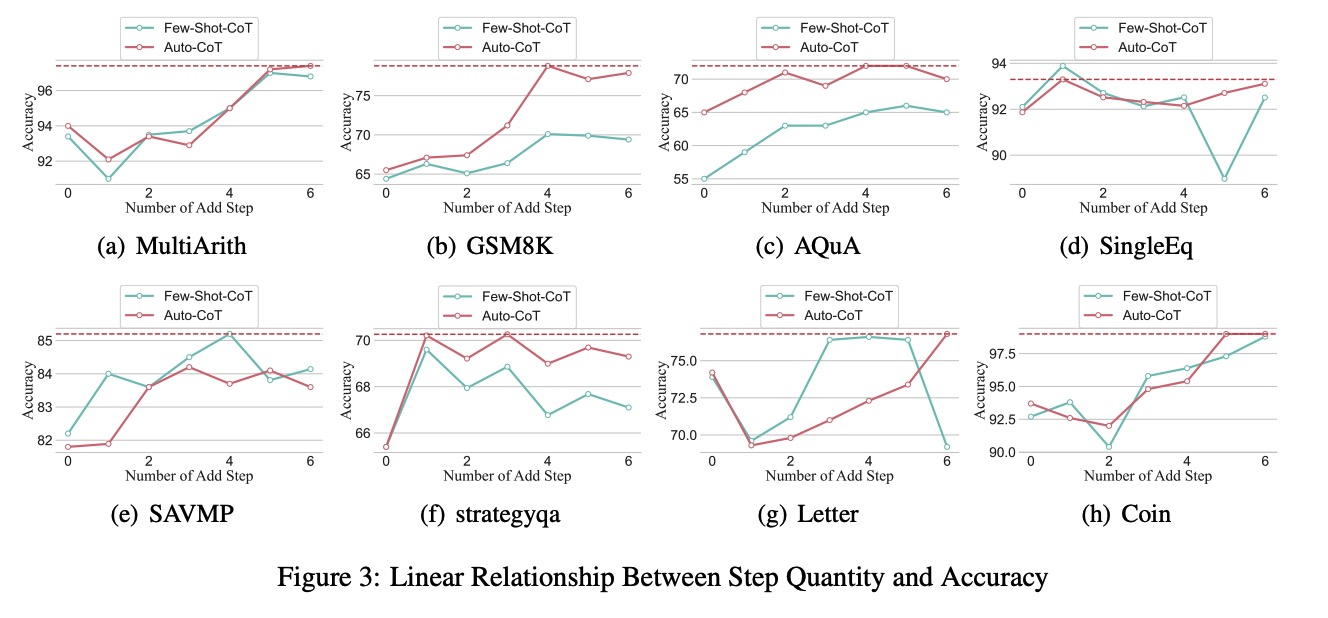

RO1: 시연(demonstration) 내의 추론 단계 수와 CoT 성능 사이에는 어떤 관계가 존재하는가?

참고로 여기서 모델은 GPT 3.5를 사용했다.

RO2: 추론 단계가 LLM 성능에 영향을 미치는 유일한 요인임을 확인할 수 있는가?

이를 입증하기 위해, 추론 과정 안에 의도적으로 잘못된 정보를 삽입했다. 그 과정은 다음과 같다.

실험 결과, 산술형(Arithmetic) 문제에서는 중간에 오차가 삽입되더라도 성능에는 큰 영향을 미치지 않았으나, Coin과 같이 논리적 추론이 필요한 문제에서는 삽입된 오류가 전체 CoT를 무너뜨리는 현상이 보였다.

RO3: Few-shot 시연에서 추론 단계를 압축하면 LLM의 성능이 저하되는가?

당연히 그러했다.

RO4: 요구되는 추론 단계 수가 LLM의 크기와 관련되는 스케일링 현상을 관찰할 수 있는가?

GSM8K 실험에서 초기 성능이 가장 낮은 text-davinci-002는 추론 단계 증가 전략으로 가장 큰 성능 향상을 보였고,

반대로 초기 성능이 가장 높은 GPT-4는 성능 저하 없이 가장 높은 안정성을 보였다.

즉 모델 크기와 최적 추론 단계 수 사이에는 유의미한 관계가 있다.

RO5: CoT 시연에서 질문 자체의 변화가 LLM의 추론 능력에 어떤 영향을 미치는가?

CoT 추론은 고정한 뒤, Question 내용에 고의적 오류를 넣었을 때 성능 변화는 어떻게 달라졌을지에 대한 실험이다.

질문 내용은 다음과 같이 변형했다. 질문에만 오류를 넣고 추론 과정은 정상적으로 유지했다.

실험 결과는 대부분 유지되었다.

5. Limitations

실험적으로 CoT의 추론 길이에 따른 성능을 확인하긴 하였으나, 그러나 이 성능 향상에 대한 근본적인 매커니즘 분석은 없었다.

즉 이론적 분석이나 설명 가능성(explainability) 분석을 포함한 내부 작동 원리 해석이 부족하다는 뜻이다.

또한 실험 대상 모델 역시 지나치게 제한적이다.