[2025-2] 박지원 - Benchmark Inflation: Revealing LLM PerformanceGaps Using Retro-Holdouts

원문) https://openreview.net/forum?id=WdA5H9ARaa#discussion

Benchmark Inflation: Revealing LLM Performance Gaps Using...

Public benchmarks are compromised, as the training data for many Large Language Models (LLMs) is contaminated with test data, suggesting a performance gap between benchmark scores and actual...

openreview.net

Intro

- LLM의 벤치마크 데이터셋에 대한 점수 인플레이션 문제에 대해, 공개 벤치마크 데이터셋이 train data에 오염되어 발생하는 성능 격차를 제기한다.

- 이에 대해, 본 논문은 Retro-holdout dataset이라는 방법론을 제시하며, metrics 또한 기존 벤치마크와 통계적으로 구분할 수 없으면서(유의한 차이가 없으면서) 오염되지 않은 기준을 제시한다. 특히 Truthfulqa 벤치마크의 경우, Retro-holdout dataset 방법론을 적용하게 되면 일부 LLM의 점수가 최대 16%p까지 부풀려졌음을 보였다는 점에서, LLM 및 LLM 평가의 신뢰성을 높이는 과정에 기여했다는 의의가 있다.

용어 정의

* '오염' : LLM을 학습시키는 데 사용되는 훈련 데이터(training data) 안에 모델의 성능을 평가하는 데 사용될 테스트 데이터(test data)의 일부 또는 전체가 포함되어 있다는 의미

* Target : 기존에 공개되어 있는 벤치마크 데이터셋 - 오염되었다 가정

* RETRO (회고적 홀드아웃 데이터셋): RETRO는 TARGET 데이터셋의 통계적 특성과 구조를 모방하여 사후적으로, 그리고 독립적으로 생성된 새로운 홀드아웃 데이터셋 - 오염되지 않았다 가정

1. LLM 벤치마크 점수 인플레이션 문제 제기부터 해결까지의 흐름

1-1. 문제 제기

a. 많은 LLM의 train data가 test data에 의해 오염되면서, 벤치마크 점수와 실제 점수 간 성능 격차(performance gap)이 발생하고 있다. 벤치마크 점수 > 실제 점수로 inflation이 발생한다.

b. 이상적으로는 정확한 점수 계수를 위해선 private holdout dataset( 모델 훈련 과정에서 전혀 사용되지 않고, 외부에 공개되지 않은 비공개 데이터셋 )이 사용되어야 하지만 대부분의 벤치마크에는 이런 데이터셋이 존재하지 않고, 사후적으로 유사한 데이터셋을 구성하는 것 또한 어렵다.

c. 이는 본 벤치마크 데이터셋이 가진 고유한 통계적 특성, 주제 분포, 질문 유형, 난이도 등을 완벽하게 모방하면서도 완전히 새로운 데이터를 생성하는 과정이 매우 복잡하기 때문. 추가적으로 원본 데이터셋에 존재하는 암묵적인 편향까지 모방하게 될 수 있어, 진정으로 독립적인 모델의 일반화 능력을 측정하기 어려울 수 있음.

1-2. 해결 방법론 제시 - Retro holdout dataset 방법론

a. 대상 dataset에 대해 홀드아웃 데이터셋을 retro하게 구성한다. 이 'retro한 생성'은 이미 존재하는 대상 데이터셋(target dataset)을 기반으로, 그 데이터셋이 만들어진 방식과 통계적 특성을 사후적으로 분석하고 모방하여 새로운 홀드아웃 데이터셋을 만드는 것을 의미

b. 이 retro holdout dataset의 통계적 구별이 불가함(유의적 차이가 없음)을 입증한다.

c. 데이터셋의 공개 가용성으로 인한 성능 격차를 정량화하기 위해 두 dataset에 대해 LLM의 성능을 비교한다.

1-3. TruthfulQA 적용 및 결과

a. TruthfulQA 벤치마크에 Retro holdout 방법론을 적용하여 Retro-TruthfulQA 구축 및 공개

b. 20개 LLM을 평가한 결과 일부 모델의 점수가 최대 16%p까지 부풀려졌음을 발견

c. 이는 공개 벤치마크 점수가 항상 모델의 실제 속성을 정확하게 판단하는 것이 아님을 의미

2. 서론 - 공개 벤치마크의 신뢰성 문제와 평가 게이밍

2-1. 공개 벤치마크 신뢰성 우려

a. 공개 벤치마크의 신뢰성에 대한 우려는, 보고된 모델 성능과 실제 역량 간 불일치로 이어진다.

b. 논문에서, 이 현상을 모델이 벤치마크가 평가하려는 실제 역량 향상 없이 단순히 점수를 잘 받기 위해 요구사항을 충족하는 '사양 게이밍(specification gaming)'과 유사하다고 비유함.

c. 이러한 벤치마크 점수와 실제 성능 간 격차를 유발하는 메커니즘을 '평가 게이밍(evaluation gaming)'으로 정의함

2-2. 데이터 누출(leakage)와 예측력 저하

a. 최근 연구에 따르면 평가 데이터셋이 훈련 데이터셋에 포함되는 데이터 leakage(누출)이 발생하며 이 누출은 평가 게이밍으로 이어짐

b. 데이터 누출은 벤치마크의 예측력에 악영향을 미칠 뿐 아니라 모델의 평가 점수와 실제 성능 간 격차를 초래하게 되고, 결과적으로 보고된 모델 점수에 대한 신뢰를 떨어뜨림

c. 이는 데이터셋 공개 및 데이터 수집 관행 개선의 필요성을 강조하는 결과임

2-3. 평가 게이밍의 문제점

a. 평가 결과를 갖고 모델 채택 등이 빈번하게 이뤄짐을 고려한다면 무시할 수 없는 문제

b. 경제적 인센티브는 평가 게이밍이 잘못되었음에도 불구하고, 그 발생 가능성을 높이게 됨. 결과적으로 LLM을 비롯한 모델들에 대해 전체적인 신뢰도를 저하시키게 됨

2-4. 홀드아웃 데이터셋의 필요성

a. 특정 평가 작업과 유사한 실제 작업 간 모델 성능 차이를 정확하게 측정하려면, 모델 훈련에 사용되지 않은 동일한 데이터 분포에서 파생된 데이터셋에 접근해야 함

b. a의 개념이 홀드아웃 데이터셋의 개념이며 훈련 후 ML 모델의 성능을 평가하는 데 사용됨.

c. 홀드아웃 데이터셋은 정의상 대상 데이터셋과 동일한 분포에서 파생되기 때문에, 대상 데이터셋과 홀드아웃 데이터셋에 대해 진행된 모든 평가는 통계적 허용 오차 내에서 동일한 결과를 가져야 함. 즉, 두 데이터셋의 차이가 유의해선 안 됨

d. 홀드아웃 데이터셋과 대상 데이터셋 간 체계적인 성능 차이는 데이터 누출로 인한 과적합을 나타낼 수 있음

e. 공개 벤치마크와 해당 홀드아웃 데이터셋에서의 모델 성능을 비교하면 공개 벤치마크의 데이터가 훈련 과정에 영향을 미쳤는지 확인할 수 있음

f. 그러나 홀드아웃 데이터셋은 일반적으로 사용할 수 없으며, 벤치마크 개발자는 일반적으로 모든 평가 데이터를 open-source화 함.

3. Retro-holdout (회고적 홀드아웃) 방법론 제안

3-1. 본 논문이 제안하는 데이터셋인 Retro holdout dataset은 독립, 회고적으로 생성되었음에도 불구하고 다양한 테스트를 통해 대상 데이터셋과 유사함이 검증됨

3-2. 어떻게 생성하는가 - 크게 2단계에 걸쳐 만들어짐.

a. 직관 구축(Build Intuition): 대상 데이터셋(TARGET)의 목적과 생성 방법론을 깊이 이해하는 단계

- 데이터셋 문서, 관련 문헌을 철저히 검토하고, TARGET 내의 많은 항목을 직접 살펴보면서 데이터셋의 특성과 의도를 파악

- 가령 TruthfulQA의 경우 '일반적인 오개념'을 사용하고, 위키피디아 같은 자료를 활용했음

b. 항목 공식화(Entry Formulation): 직관 구축 단계에서 얻은 통찰력을 바탕으로, TARGET의 구조와 통계적 속성을 반영하면서도 고유한(distinct)새로운 항목들을 생성하는 단계

- 아이디어 구상: 원본 데이터셋의 항목을 검토하거나, 웹에서 오개념 목록을 찾아 새로운 오개념 아이디어를 브레인스토밍

- 질문 및 답변 작성: 선택한 아이디어를 바탕으로 원본 데이터셋의 질문 스타일(예: "무슨 일이 일어날까요, 만약...")을 모방하여 질문을 작성하고, 웹 검색을 통해 오개념의 실제 진실을 파악한 후 정답과 오답을 구성

- 반복 및 검증: 생성된 항목이 TARGET과 얼마나 유사한지 평가하고, 필요하다면 다시 생성하는 과정을 반복하며, 이 과정에서 다양한 도구(예: 임베딩 공간 시각화, 코사인 유사성 분석 등)를 활용하여 통계적 유사성을 확인

즉, 훈련 후 모델의 실제 성능을 평가하기 위한 효과적이고 편향되지 않은 벤치마크 역할을 하도록 대상 데이터셋의 통계적 속성과 일치하도록 독립적으로 사후 생성하는 데이터셋이라 요약 가능.

3-3. 어떻게 평가하는가 - 통계적 유사성 검증은 크게 4단계로 진행

(TARGET과 RETRO가 공통된 기원을 가지고 있다는 귀무 가설을 강력하게 테스트하고 기각하는 것이 목표)

- 난이도 유사성(Similarity of Difficulty): 두 데이터셋의 질문 난이도가 통계적으로 유의미한 차이 없이 비슷한지 확인

- 의미 임베딩 유사성(Semantic Embedding Similarity): 데이터셋 항목들의 의미론적 유사성 분포가 통계적으로 유사한지 확인

- 예측 정확도(Prediction Accuracy): 모델이 두 데이터셋을 구별할 수 있는지 테스트 진행

- 가령 모델의 예측 정확도가 50%에 가깝다면, 모델이 두 데이터셋을 구별하지 못한다는 의미 - 인간 구별 가능성(Human Distinguishability): 인간이 두 데이터셋의 항목들을 보고 어느 데이터셋에 속하는지 구별할 수 있는지 테스트. 인간도 구별하기 어렵다면 통계적으로 구별 불가능하다고 볼 수 있기 때문

4. TruthfulQA 사례

- 언어 모델이 인간의 거짓말을 모방하는 경향을 평가하고자 설계한 Q-A dataset인 TruthfulQA 벤치마크를 사용하여 case study 진행

- 본 데이터셋은 개발자들이 테스트하는데 널리 사용되는 데이터셋임

- 성능이 좋지 않은 모델이 사용자 입력에 그럴듯한 거짓말로 응답할 가능성이 높아, 명확한 안전성 함의를 갖는다고 파악하여 선정됨

5. RETRO 도구

5-1. 기본적으로 Retro 생성은 쉽지 않아서, Fine-tuned prediction model attention을 활용

5-2. Config 및 환경

a. 모델 : BERT 모델(Target 또는 Retro에 속하는 항목을 분류하도록 fine-tuning된 BERT)

- Transformers interpret 라이브러리를 활용하여 모델이 Target과 retro 구분 시 가장 유관하다고 간주한 입력 토큰을 식별

b. 데이터 포인트 임베딩 : HuggingFace Sentence Transformers 라이브러리를 통해 all-mpnet-base-v2 임베딩 모델을 사용하여 모든 데이터 포인트에 대한 임베딩 벡터 생성

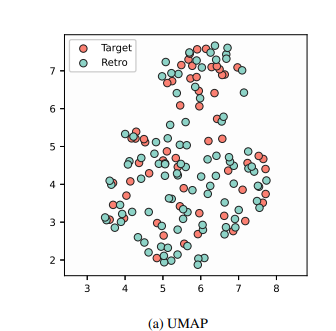

- 임베딩 공간 시각화 : UMAP을 활용하여 임베딩 벡터를 2차원 평면에 투영

- 가장 큰 내부 코사인 유사성 비교(Largest Internal Cosine Similarity Comparison): 두 데이터셋에서 코사인 유사성이 가장 높은 10개 항목 쌍을 강조하여 가장 유사한 항목과 해당 값에 대한 직접적인 비교를 제공

6. Test 관련

6-1. 난이도 유사성

a. RETRO가 TARGET의 난이도와 일치하는지 평가하는 것은 평가 게이밍에 대한 의미 있는 결론을 도출하는 데 중요하다. 그렇지 않으면 성능 차이가 모델의 실제 역량보다는 질문 난이도의 차이에 기인할 수 있기 때문

b. 이러한 잠재적 불일치를 이해하기 위해 TARGET 출시 이전에 훈련 마감일을 가진 모델, 즉 사전 출시 모델(pre-release models)을 고려한다.

- 사전 출시 모델은 TARGET에 노출되어 영향을 받을 수 없으므로(TARGET 데이터셋이 공개되기 이전에 훈련이 완료된 모델이니까) , TARGET과 RETRO 모두에서 그들의 성능은 통계적 불확실성 범위 내에서 비교 가능해야 한다.

* 말이 조금 긴데, 한마디로 사전 출시 모델은 TARGET 데이터셋에 대한 '사전 지식'이 없으므로, TARGET과 RETRO(오염되지 않은 유사 데이터셋) 모두에서 비슷한 성능을 보여야 한다고 가정하는 것. 만약 차이가 있다면, 그것은 데이터셋의 난이도 차이 때문일 수 있으므로, 이 난이도 유사성 테스트를 통해 데이터셋의 구별 불가능성을 검증하는 데 활용하겠다는 것임

- 다양한 역량 수준의 LLM에 접근할 수 있다면, 테스트 방법론과 간단한 인간 평가만으로도 두 평가 데이터셋이 통계적으로 구별 불가능한지 확인할 수 있을 것이다.

- 그러나 최첨단 모델의 성능은 계속 향상되고 있으므로, 사전 출시 모델은 가장 진보된 모델보다 강하지 않을 것이다. 이러한 제약을 해결하기 위해 모델 성능을 증폭시키는 여러 기술을 사용함

- 모델이 여러 답변을 선택하도록 허용(top-k) / 데이터셋 내의 다른 질문 예시 포함(5-shot) / 모델에서 중간 출력을 유도하는 루틴 프롬프트 포함(chain-of-thought) 등이 사용됨.

6-2. 예측 정확도

a.Dankar와 Ibrahim이 상세히 설명한 예측 정확도 수정본( 합성 데이터 평가(synthetic data evaluations)에서 모델이 두 데이터셋(원본과 합성된 데이터셋)을 얼마나 잘 구별하는지 측정하는 방법론 )을 채택하여, 각 데이터셋에서 동일한 수의 항목을 사용하여 항목이 TARGET 또는 RETRO에 속하는지 분류하는 모델을 훈련

b.합성 데이터 평가에서 로지스틱 회귀의 전통적인 사용과는 달리, 예측 작업에 fine-tuned BERT를 사용함

-텍스트 내의 미묘한 의미 관계를 포착하는 BERT의 능력에 기반한 선택(Target과 Retro 데이터셋 간의 미묘한 차이점, 유사성 등을 정확하게 평가하려면 양방향 문맥을 파악하는 BERT가 제일 적합하다고 본 것)

-이는 데이터셋 항목 간의 미묘한 차이 또는 유사성을 정확하게 평가하는 데 중요

c. 이 모델을 나머지 샘플에 대해 테스트하며, 이론적으로 모델의 test sample에 대한 예측 정확도가 통계적 허용오차 내에서 수렴하는지 파악하고자 함

* 예측 정확도 수정본 : 원래는 logistic regression을 썼는데 여기선 상술했듯 BERT를 fine tuning하여 사용

6-3. 의미 임베딩 유사성

a. 다차원 데이터 분석을 위한 잘 확립된 기술을 사용하여, RETRO와 유사한 속성을 가진 분포가 PARENT에서 무작위로 추출될 가능성을 결정하기 위해 무작위 순열 테스트(두 데이터 분포가 통계적으로 동일한지 분석하는 test) 진행

b.무작위 순열 테스트에 사용된 테스트 통계는 PARENT(부모 분포; Target과 retro 데이터셋이 모두 독립적으로 추출되었다고 가정하는 가상의 원본데이터 분포)의 임베딩과 PARENT의 무작위 샘플링된 하위 집합(n=min(n_TARGET, n_RETRO) 항목) 간의 모든 고유하고 비자명한 코사인 유사성의 평균을 계산

+) 기본적으로 가상의 원본 데이터 분포이기 때문에 접근이 불가함. 그래서 본 연구에서는 Target과 Retro를 합친 데이터셋을 '대리 부모(surrogate parent)'로 정의하고 이를 실제 Parent를 근사하는데 사용하였음.

c. TARGET과 RETRO의 테스트 통계는 N개의 무작위 샘플의 테스트 통계와 비교되어 TARGET에 대한 p-값 하나와 RETRO에 대한 p-값 하나를 산출

d. 이 테스트를 성공적으로 통과하려면 p-value_TARGET, p-value_RETRO ∈ [0.05, 0.95]여야 한

e.이 범위는 RETRO가 TARGET과 너무 유사하지도 너무 다르지도 않도록 하여, 현실적인 조건에서 구별 불가능성 가설을 지지하는 균형을 촉진하기 위해 선택

f. n_TARGET ≠ n_RETRO(데이터셋 항목 수가 다른)의 경우, 테스트 통계의 분산을 이해하기 위해 핵심 순열 테스트 외부의 외부 루프도 정의함. 이는 두 데이터셋의 크기가 같아야 무작위 순열 테스트 등 수행할 때 비교가 용이하기 때문

* 외부 루프 : Target과 Retro 간 데이터 항목 수가 다르면 하위 샘플링 과정에서 무작위성이 도입될 때, 핵심 순열 테스트 외에 외부루프를 정의하게 됨. 이 루프는 하위 샘플링 과정을 여러 차례 반복하여 test 통계의 안정성과 신뢰성을 목표로 도입됨

6-4. 인간 구별 가능성(Human Indistinguishability):

- 데이터셋이 인간에게 구별 가능한지 평가하기 위해, 참가자들이 TARGET과 RETRO의 항목을 분리하는 작업을 수행하는 설문 조사를 실시

- 처음에 참가자들은 각 데이터셋에서 10개의 레이블이 지정된 항목을 제공받음 (이해하기 위함)

- 각각 세 개의 데이터셋 항목(두 개는 TARGET에서, 하나는 RETRO에서)으로 구성된 일련의 10가지 테스트를 진행

- 설문 조사 전반에 걸쳐 고유한 샘플을 보장하기 위해 모든 항목은 대체 없이 추출

- 또한, 인간과 모델 성능을 비교하기 위해 GPT-4o를 평가자로 사용하여 이 테스트의 변형을 구현

6-5. 실패 반복(Iterating on Failures)

1. 아무리 통계 테스트를 한다고 해도 구분 불가능한 결과를 얻을 가능성은 낮음

2. 프로세스의 초기 소규모 (데이터셋에 대한) 적용을 수행하여 개발자가 구별 불가능성 테스트를 사용하여 TARGET에 대한 통찰력을 얻을 수 있도록 권장

3. 개발자가 더 광범위한 회고적 홀드아웃 데이터셋을 생성하기 위해 프로세스를 다시 수행하기 전에 방법과 휴리스틱을 개선할 수 있도록 함

4. 실제로 첫 시도에는 통계적으로 유의한 차이가 있는 것으로 나왔음. 그러나 더 작은 소규모 데이터셋에 대해 test를 다양하게 수행한 결과 명확하지 않았던 여러 결과가 식별됨. 이러한 케이스와 조정은 중요한 인사이트를 주기도 했고, 결과적으로 retro-truthfulQA 구축에 사용됨

7. 평가

7-1. 평가 프레임워크 적용

a. TruthfulQA 평가 방식의 문제점

- TruthfulQA 저자들은 언어 모델이 미리 정의된 사용 가능한 옵션 목록 중 하나에 할당된 최대 확률로 평가될 것이라고 예상

- 그러나 이때, 긴 답변 옵션은 선택될 확률이 낮아짐(즉 모델이 특정 답변 옵션에 부여하는 생성 확률이 낮아짐)

-> 언어 모델은 일반적으로 긴 문장(답변) 생성 시 각 토큰의 확률을 곱해서 전체 문장의 확률을 계산한다는 점을 감안한다면 문장이 길수록 확률이 낮아질 수밖에 없음. 만약 모델이 긴 정답 옵션에 높은 '최대 확률'을 할당해야만 좋은 점수를 받는 방식이라면, 모델이 정답을 알고 있더라도 그 답변이 길다는 이유만으로 낮은 총 확률을 받아 불이익을 받을 수 있게 됨

7-2. 새로운 Metrics

- 모든 TruthfulQA mc1-선택 사항의 목록(TruthfulQA 벤치마크의 각 질문에 대해 미리 정의된 multiple choice 답변 옵션들을 번호를 매겨 나열한 목록)을 제공하고, 모델이 가장 적합하다고 생각하는(선호하는) 옵션을 선택하기 위한 토큰을 생성하여 모델을 평가

- 토큰이 위에서 계산하는 확률보다는 더 공정할 것이라 판단했기 때문

- 추가적으로 잠재적인 모델 bias를 최소화하고자, 옵션 회전(같은 질문이라도 답변 옵션들의 순서를 무작위로 섞어서(예: A, B, C -> B, C, A -> C, A, B 등) 최소 10번 이상 다르게 제시하는 것) 을 최소 10회 이상 진행했으며, 하나의 옵션이 다른 옵션들보다 평균 4번 더 선택될 때까지 답변을 resampling함(비용이 상당함..)

- 결과적으로 TruthfulQA와 Retro-TruthfulQA 모두에서 prelease 모델에 대해서만 1-sigma 오차 막대를 계산할 수 있었음.

* 1-sigma 오차 막대 : 실험 결과(값)의 불확실성/변동성을 시각화한 것. 데이터의 약 68%가 해당 범위 내에 있음을 의미

7-3. 결과

a. TruthfulQA에서 babbage-002, davinci-002, neox-20b는 각각 ±1.27%, ±0.83%, ±2.84%의 통계적 오차를 가졌으며, Retro-TruthfulQA에서는 각각 ±2.47%, ±1.96%, ±1.34%의 오차가 발생함.

b. 이는 TruthfulQA 데이터셋의 유형과 관련이 있음

- TruthfulQA 데이터셋은 각 항목에 대해 범주와 유형 2가지 종류를 포함

- 실험은 이런 범주 중 오개념에 중점을 두며 데이터셋은 크게 adversarial / non-adversarial(일반적인 오개념을 다루는 질문들을 포함한 부분) 2개 유형으로 나뉨

c. GPT-3 모델의 성능 차이

- 평가 결과 GPT-3 계열 모델은 비적대적 부분에서 훨씬 나은 성능을 보임. 적대적 부분은 GPT 계열에 대해 다양한 항목을 test하고 모델이 일관되게 올바른 답변을 생성한 항목을 제외해서 구성했기 때문( 모델들이 쉽게 정답을 맞히지 못하게, 즉 모델의 약점을 공략하기 위해 의도적으로 설계된 질문들을 사용했다는 것)

+) TruthfulQA의 원래 목적은 언어 모델이 인간의 거짓말을 얼마나 잘 모방하는지를 측정하려는 것이었음. 때문에 모델이 쉽게 정답을 맞히게 되면 그 '거짓말 모방'이라는 목적을 달성하기 어려워짐. 그래서 잘 맞히는 문제들을 제거한 것

8. Contribution & Limitations

8-1. 기여

- 논문의 연구 결과는 LLM의 벤치마크 성능과 실제 역량 간의 상당한 불일치를 보여주며, 견고하고 신뢰할 수 있는 평가 방법론의 필요성을 강조

- 다양한 공개 벤치마크 평가에 일반적으로 적용 가능하도록 설계된 이 방법론은 모델 평가의 정확성과 신뢰성을 크게 향상시키는 도구를 제공하여 분야에 대한 실용적인 발전 경로를 제시

8-2. 한계

- 동일 분포 가정의 유효성 문제 : Retro - target dataset이 동일한 분포에서 추출되었다는 가정이 항상 유효하지 않을 수 있음. 특히 대상 데이터셋 자체가 분포 변화를 겪게 된다면 이 가정은 아예 깨지게 된다.

- 자원 문제 : 회고적 hodlout dataset 생성과정은 자원이 상당히 많이 소요됨(생성부터 검증까지 전부)

- bias: 대상 데이터셋의 분포를 일치시키는 접근 방식에서, 대상 데이터셋에 존재하는 모든 잠재적 편향을 유지시켜버림. 즉, retro dataset은 Retro dataset 모방에는 좋을지 몰라도 더 포괄적인 맥락상 모델의 일반화에 대해, 정말 독립적이라고 할 수 없을 수 있음.