NLP

[2025-2] 한영웅 - Investigating Data Contamination for Pre-training Language Models (Arxiv 2024)

Gwacheontech

2025. 8. 23. 22:06

1. Introduction

문제 배경

- LLM의 뛰어난 성능은 모델 크기와 데이터 규모 덕분이라고 여겨짐

- GPT-3, PaLM, LLaMA 등 주요 LLM 연구들

- 정말로 크기와 데이터만이 성능의 원인일까?

- "under-explored" : 충분히 연구되지 않은 중대한 측면

- 데이터 오염(data contamination): 사전 훈련 코퍼스에 평가 데이터가 섞여 들어가는 현상

- 지금까지의 LLM 성능 평가가 근본적으로 신뢰할 수 없을 가능성

- 대부분의 사전 훈련 코퍼스가 비공개

기존 접근법의 문제

- 평가 수준 분석 (Evaluation-level Analysis):

- 이미 훈련된 모델에 대해 사후적으로 분석

- 평가 데이터를 깨끗한(clean) 부분과 오염된(contamination) 부분으로 나누어 성능 비교

- 한계: 실제 훈련 과정에서의 영향을 직접 측정하지 못함

- 사전 훈련 수준 분석 (Pre-training Level Analysis):

- 이 논문이 제안하는 방법

- 실제로 다양하게 오염된 데이터로 모델을 처음부터 훈련

- 장점: 오염의 직접적 영향을 정확히 측정 가능

오염의 형태

- 텍스트 오염 (Text Contamination)

- 기존 연구의 주 관심사

- 평가 데이터의 입력 텍스트 부분만 포함

- 예시: "This movie is fantastic!" (감정분석 데이터의 리뷰 텍스트)

- 정답 오염 (Ground-truth Contamination)

- 이 논문의 독창적 기여

- 입력 텍스트 + 프롬프트 + 정답이 모두 포함된 경우

- 예시: "This movie is fantastic! Sentiment: positive"

- 기존 연구가 놓친 더 심각한 형태의 오염

세 가지 핵심 질문:

- RQ1: 오염 형태별 영향

"How are language models affected by the deliberate addition of various forms of contamination on the pre-training corpus?" - RQ2: 반복 오염의 효과

"How do the number of repetitions of evaluation data in the pre-training corpus affect performance?" - RQ3: 기존 정의의 효과성

"How effective are the n-gram-based contamination definitions used in recent LLM reports?"

Contributions Summary

- 1: 실증적 조사

- "from scratch" 접근법

- 다양한 오염 메커니즘의 직접 비교

- 기존의 추측을 실증 데이터로 전환

- 2: 정답 오염의 중요성

- 정답 오염이라는 새로운 개념 도입

- U자 형태 효과: 적당한 오염은 도움, 과도한 오염은 해로움

- 일반적 예상과 다른 결과 확인

- 3: 기존 방법론 비판

- 현재 표준 방법들이 "부적절하고 불충분"

- 실증적 증거를 통한 방법론적 전환 필요성 제기

2. Data Contamination

기존 방법론

- N-gram 기반 접근법의 특징:

- 텍스트 겹침을 직접적으로 측정

- 구현이 상대적으로 용이

- 텍스트 겹침을 직접적으로 측정

- PaLM 방법론:

- 평가 샘플에서 가능한 모든 8-gram 생성

- 훈련 코퍼스에서 발견된 8-gram의 비율 계산

- 임계값: 70% 이상이면 "contaminated", 그렇지 않으면 "clean"

- 평가 샘플에서 가능한 모든 8-gram 생성

- LLaMA-2 방법론:

- 1단계: 토큰 수준 오염 판정

- 10개 이상 토큰으로 구성된 n-gram에 포함된 토큰

- 해당 n-gram이 훈련 세트에도 존재하면 그 n-gram 내 모든 토큰이 "오염됨"

- 10개 이상 토큰으로 구성된 n-gram에 포함된 토큰

- 2단계: 샘플 수준 오염 비율 계산

- (오염된 토큰 수) / (전체 토큰 수) × 100

- (오염된 토큰 수) / (전체 토큰 수) × 100

- 3단계: 4단계 분류 체계

- Clean: 오염 비율이 매우 낮음

- Not Clean: 오염 비율이 낮음

- Not Dirty: 오염 비율이 중간

- Dirty: 오염 비율이 높음

- Clean: 오염 비율이 매우 낮음

- 1단계: 토큰 수준 오염 판정

기존 방법론 문제점

- False Positive

- 의미가 전혀 다른 텍스트도 n-gram이 겹칠 수 있음

- 자연어에는 관용구, 일반적 표현 등이 반복됨

- 의미가 전혀 다른 텍스트도 n-gram이 겹칠 수 있음

- False Negative

- 패러프레이징: 의미는 같지만 표현을 바꾸면 탐지 불가

동의어 사용: 단어만 바꿔도 n-gram 매칭 실패

- 패러프레이징: 의미는 같지만 표현을 바꾸면 탐지 불가

이 연구에서 채택한 정의 방식

- PaLM 정의 적용

- LLaMA-2 정의 적용

- 직접 n-gram 겹침

- 새로운 오염 유형 분류

- 텍스트 오염 (Text Contamination)

- 정답 오염 (Ground-truth Contamination)

3. Experimental Setup

이 챕터는 논문의 핵심인 "처음부터 훈련(from scratch)" 접근법을 구체적으로 구현하는 방법론을 제시.

기존 연구들이 이미 훈련된 모델을 사후 분석하는 것과 달리, 이 연구는 통제된 실험 환경에서 오염의 직접적 효과를 측정하려고 함.

모델 아키텍처 선택의 합리성

- GPT-2-small 선택 이유:

- 계산 효율성: 처음부터 훈련하는 것은 매우 비용이 많이 듦

- 통제 가능성: 작은 모델로 더 많은 실험 변수 테스트 가능

- 재현성: 다른 연구자들이 실험을 재현하기 쉬움

- 하이퍼파라미터: GPT-2 기본 설정 그대로 사용

- 일관성: 모든 실험에서 동일한 설정 유지

- GPT-2-large 확장:

- 목적: 더 큰 모델에서도 동일한 패턴인지 검증

- 데이터셋 구성:

- The Pile 선택 이유:

- 다양성: 800GB의 다양한 텍스트 소스

- 품질: 학술적으로 검증된 대규모 데이터셋

- 접근성: 공개적으로 이용 가능한 데이터

- 평가 데이터셋 선정

- 적절한 난이도: GPT-2가 해결할 수 있는 수준

- 전통적 벤치마크: 널리 사용되어 비교 가능

- 다양한 태스크: 여러 NLP 분야 커버

- SST-2 (Stanford Sentiment Treebank)

- MMLU (Massive Multitask Language Understanding)

- CNN/Daily Mail

- SQuAD V1 (Stanford Question Answering Dataset)

- 평가 방법론

- SST-2 평가의 복잡성 해결

- 문제: GPT-2의 생성 결과가 불안정하고 통제하기 어려움

- 해결: 각 라벨을 가설로 설정하여 점수 매기는 방식

- 프롬프트 민감성 문제 해결

- 프롬프트 다양성 확보:

- 총 10개 프롬프트 사용

- 다양한 형식: 길이와 의미가 다른 프롬프트들

- 평균화: 모든 프롬프트 결과의 평균으로 최종 성능 산출

- 총 10개 프롬프트 사용

- 프롬프트 다양성 확보:

- MMLU 평가의 표준화

- 공식 구현 사용: AllenAI의 검증된 평가 코드

- CNN/Daily Mail 요약 평가

- 트리거: "TL;DR:" 추가하여 요약 유도

- 생성 설정: top-k=2 랜덤 샘플링으로 150 토큰

- 후처리: 처음 3문장만 요약으로 사용

- 평가 지표:

- ROUGE 점수: ROUGE-1, ROUGE-2, ROUGE-L

- UniEval

- SQuAD 질의응답 평가

- 생성 길이: 최대 15 토큰

- 답변 추출: 첫 번째 문장만 답변으로 간주

- 평가: F1 점수 (토큰 겹침 기반)

- SQuAD V1 선택 이유:

- V2의 "답변 없음" 질문들이 실험 결과에 편향을 줄 수 있음

- V1은 모든 질문에 답변이 있어 더 깨끗한 평가 가능

- SST-2 평가의 복잡성 해결

- The Pile 선택 이유:

Experiments & Analyses 챕터 상세 분석

이 챕터는 논문의 핵심이며, 세 가지 모델 변형을 통해 데이터 오염의 직접적 효과를 측정함

- 세 가지 모델 변형:

- GPT-2-small_original: 깨끗한 원본 코퍼스로 훈련 (기준선)

- GPT-2-small_text: 텍스트 오염 버전 (평가 샘플의 입력 텍스트만 추가)

- GPT-2-small_gt: 정답 오염 버전 (입력 텍스트 + 프롬프트 + 정답 모두 추가)

- Effects of Contamination on Evaluation Performance - 오염 효과 분석

- SST-2 (감정 분석) 결과:

- Original: 48.34% → Text: 54.89% (+6.55%p) → GT: 51.02% (+2.68%p)

- 정답 오염이 텍스트 오염보다 성능이 낮음

- "We hypothesize that this is because text classification tasks predominantly depend on the model's comprehension of the input text, rendering evaluation prompts and ground truths less impactful. In fact, they might introduce noise"

- 감정 분석의 특성: 주로 텍스트 이해에 의존하는 태스크

- 프롬프트 민감성: GPT-2가 프롬프트 형식에 매우 민감

- 노이즈 효과: 추가 정보가 오히려 혼란을 야기할 수 있음

- SQuAD (질의응답) 결과:

- Original: 9.07 F1 → Text: 9.78 F1 (+0.71) → GT: 11.45 F1 (+2.38)

- GT 오염이 텍스트 오염보다 3.4배 더 효과적

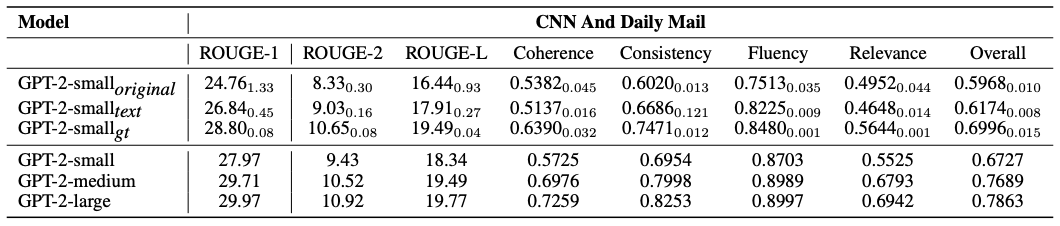

- CNN/Daily Mail (요약) 결과:

- ROUGE-1: 24.76 → 26.84 (Text) → 28.80 (GT)

- 전체 UniEval: 0.5968 → 0.6174 (Text) → 0.6996 (GT)

- GT 오염으로 GPT-2 medium 수준 달성

- 태스크별 오염 효과의 차이

- 구조화된 태스크 vs 분류 태스크:

- 구조화된 태스크 (CNN, SQuAD):

- 정답 오염이 월등히 우수

- 프롬프트-답변 패턴 학습이 중요

- 분류 태스크 (SST-2):

- 텍스트 오염이 더 효과적

- 단순한 패턴 인식이 핵심

- 추가 정보가 오히려 방해 가능성

- 구조화된 태스크 (CNN, SQuAD):

- 구조화된 태스크 vs 분류 태스크:

- 공개 모델과의 성능 비교

- CNN에서 GT 오염 모델이 공개 GPT-2-small을 능가

- 더 큰 훈련 데이터의 필요성

- SST-2 (감정 분석) 결과:

- Effects of Repeated Contamination Can Be U-Shaped - 반복 오염의 U자형 효과

- "For SST-2, MMLU, and SQuAD datasets, we observed a distinct U-shaped performance trend in response to increasing contamination factors."

- U자형 패턴의 특징:

- 초기 향상 (0-5회): 성능 꾸준히 증가

- 최적점 (5-10회): 성능이 정점에 도달

- 성능 하락 (10-20회): 점진적 성능 저하

- 역전 현상 (20회): 원본보다 성능이 낮아짐

- CNN 데이터셋의 특이한 패턴

- ROUGE 점수: 지속적 증가 (단조 증가)

- UniEval 점수: U자형 패턴 (다른 데이터셋과 동일)

- ROUGE vs UniEval 차이의 원인:

- ROUGE: 토큰 빈도에 의존 → 반복으로 인한 인위적 향상

- UniEval: 의미적 품질 측정 → 실제 능력 반영

- 현실적 문제점:

- 알 수 없는 반복 횟수: 실제 LLM에서 평가 데이터가 몇 번 반복되는지 모름

- 웹 크롤링으로 수집된 데이터의 중복 정도 파악 불가

- 실제 능력 vs 기억된 내용의 구분 어려움

- Effects of Removing Contamination from Pre-Training (4.3) - 오염 제거 실험

- 기존 n-gram 정의의 실증적 검증

- n-gram 직접 겹침: 단순한 n-gram 매칭

- LLaMA-2 정의: 10+ 토큰 n-gram 기반

- 다양한 제거 비율: 3%부터 30% 이상까지

- 기존 방법의 무효성

- "The results, however, do not show a uniform pattern across different proportions of token removal. Interestingly, in certain instances where token removal exceeded 30%, the model's performance remained comparable to that of the original model."

- 일관성 없는 패턴: 제거 비율과 성능 간 명확한 관계 없음

- 30% 제거해도 동일한 성능: 제거된 데이터가 진짜 오염이 아님을 의미

- 무해한 데이터를 오염으로 잘못 분류

- PaLM 정의의 문제점:

- 과도한 엄격함: 실제 사용 불가능한 수준

- 극소수 문서만 필터링: 실용성 없음

- 현실과의 괴리: 이론적으로만 존재하는 기준

- 기존 n-gram 정의의 실증적 검증

- Scaling Up with a Larger Model (4.4) - 대규모 모델 실험

- GPT-2-large 실험 설정

- 오염 비율 조정: contamination factor 60 사용 (small의 factor 10과 동일 비율)

- 대규모 모델에서도 지속되는 오염 효과

- CNN 결과:

- Original: 27.47 ROUGE-1 → GT: 28.43 (+0.96)

- Original: 0.6885 전체 점수 → GT: 0.7117 (+0.0232)

- MMLU 결과:

- Original: 22.9% → GT: 23.9% (+1.0%p)

- 모델과 데이터가 커져도 오염 효과는 여전히 존재

- 절대적 개선폭은 작아짐 (희석 효과)

- 근본적 문제: 데이터 규모만으로는 오염 문제 해결 불가

- CNN 결과:

- GPT-2-large 실험 설정

- Assessing Evaluation-Level Contamination Analysis (4.5)

- LLaMA-2 방식의 재현 실험

- 4단계 분류 시스템:

- Clean: 오염 비율 매우 낮음

- Not Clean: 오염 비율 낮음

- Not Dirty: 오염 비율 중간

- Dirty: 오염 비율 높음

- 4단계 분류 시스템:

- 기존 방법론의 문제점 발견

- CNN 결과 분석:

- Dirty가 다른 카테고리보다 특별히 높지 않음

- 예상과 달리 "더러운" 데이터에서 높은 성능 없음

- 실제 오염 효과를 감지하지 못함

- CNN 결과 분석:

- 기존 LLM 보고서들의 오류 지적

- "The fact from the previous experiments that the performance of the evaluated models can be boosted by contamination shows that these models are not immune to contamination in the pre-training corpus."

- 사전 훈련 수준: 명확한 오염 효과 존재 (이 연구에서 입증)

- 평가 수준: 오염 효과 감지 불가 (기존 방법론)

- 기존 연구들의 잘못된 결론:

- 모델이 오염에 강하다 → 측정 방법의 문제

- 오염 효과가 미미하다 → 탐지 능력 부족

- 평가가 신뢰할 만하다 → 근본적 오해

- LLaMA-2 방식의 재현 실험