[2025-1] 임준수 - Self-Adapting Language Models

https://arxiv.org/abs/2506.10943

Self-Adapting Language Models

Large language models (LLMs) are powerful but static; they lack mechanisms to adapt their weights in response to new tasks, knowledge, or examples. We introduce Self-Adapting LLMs (SEAL), a framework that enables LLMs to self-adapt by generating their own

arxiv.org

Abstract

기존의 대형 언어 모델(LLM)은 강력하지만 정적(static)이며 새로운 작업이나 지식에 즉각적으로 적응하는 능력이 제한적이다.

-> SEAL(Self-Adapting Language Models)은 LLM이 직접 self-edit을 생성하여 최적화 하이퍼파라미터 지정 등의 자가 적응(self-adaptation) 기능을 갖추도록 설계되었다. 강화학습 기반 중첩 루프(nested loop)를 통한 지속적 성능 개선 과정을 포함한다.

이러한 self-edit은 지도 학습 기반 미세조정 기법인 SFT(Supervised Fine-tuning)을 통해 지속적인 가중치 업데이트로 이어져, 모델이 영구적으로 적응할 수 있게 한다.

1. Introduction

기존 LLM은 새로운 task가 주어지고 배워야 할 때, 그 정보를 프롬프트에 일시적으로 넣어주는 것으로 해결하는데 본 논문에서는 Seal(Self-Adapting LLM)모델을 통해서 LLM이 자기 자신을 위한 합성데이터와 policy를 스스로 생성하고 활용하는 것을 보여준다.

본 연구는 지식 통합(knowledge incorporation)과 few-shot Learning 도메인에 적용해 SEAL이 기존 방법보다 뛰어난 적응성과 성능을 보임을 입증한다. 이러한 결과는 LLM이 스스로 데이터를 재구성하고, 학습에 최적화된 데이터를 생성하여 fine-tunning policy를 제공하고 자기 적응 능력을 획득할 수 있음을 보여준다.

SEAL모델이 self-edit한 데이터는 GPT-4.1에서 생성된 합성 데이터(synthetic data)보다 성능이 우수하였고 RL 최적화 루프로 성공률을 높였다.

SEAL(Self-Adapting Language Models):

- LLM이 자체적으로 데이터를 재구성하고 가중치 업데이트에 대한 데이터와 지시를 생성하도록 하는 것이다.

- 모델은 모델의 Context에서 제공된 데이터를 사용하여 토큰 생성을 통해 이러한 SE(self-edit)를 직접 생성하도록 학습된다.

-> 자체적인 보상 신호.

- 이러한 데이터 재구성, 자체 생성 policy를 self-edit 이라 칭한다.

self-edit:

- Context로부터 합성데이터(질문,정답) 쌍을 생성

- 한 Context의 텍스트를 가져와서 그로부터 주요 의미를 함축하거나 사실을 다시 표현하는 것.

(ex. 시험을 준비하는 학생이 복습하며 노트를 쓰고 메모하는 개념과 유사.)

- few-shot에서는 hyperparameter , learning rate를 자체적으로 지정할 수도 있고 데이터 증강이나 이미지 rotation도 가능하다.

2. Methods

- Seal의 핵심 방법론은 두 개의 중첩 루프(nested loop)를 가진다. 외부 루프와 내부 루프이다. 이들은 self-adaption, self-edit을 위해서 같이 일한다.

2.1 General Framework

(1) 내부 루프 (Inner Loop)

- 내부 루프는 가중치가 직접 지속적으로 변경사항을 적용하는 구역이고, 모델이 생성한 합성 데이터 (synthetic data) 를 self-edit한다.

합성 데이터는 SEAL 모델이 새로운 태스크나 지식(Context, C)을 입력받았을 때 self-edit 스스로 생성한다.

모델의 현재 파라미터(가중치)와 context를 결합하여 순차적 토큰 생성을 통해 self-edit을 만든다.

- 이를 모델 생성단계의 기초인 sft단계인 미세조정절차에 사용하고 self-edit이 미세조정절차의 대상이 된다.

이를 위해 Lora Adapter 를 사용한다.

SFT(Supervised Fine-Tuning, 지도 미세조정)

- 지도 학습의 일종이고 사전 훈련된 모델을 특정 작업에 적합하게 만드는 강력한 미세 조정 방식

- 학습 속도가 빠르고 계산량이 상대적으로 적은 특징

Lora Adapter:

- full-finetune 과정에서 요구하는 것보다 훨씬 적은 파라미터를 사용함으로써 LLM을 효율적으로 미세 조정(fine-tuning) 하기 위한 방법이다.

- 즉, 모든 가중치를 바꾸지않고도 거대한 모델을 업데이트할 수 있다.

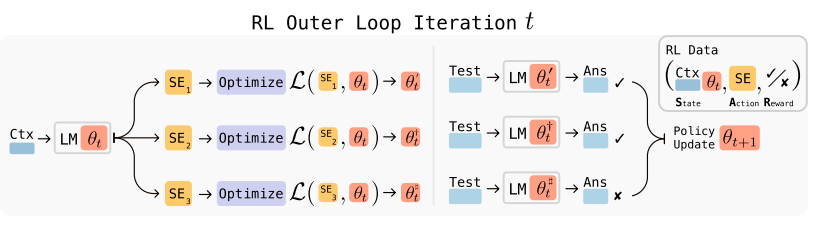

(2) 외부 루프 (Outer Loop)

- 학습 전략이 최적화되는 곳이다. - 여기서 모델이 좋은 self-edit을 생성하는법을 배우고 이는 강화 학습(Reinforcement Learning, RL)을 사용하여 수행된다.

외부 루프 학습 전략 최적화 과정

1. 외부 루프에서 self-edit을 제안하고 해당 내용은 임시복사본을 업데이트하는 내부루프에 저장된다.

2. 그런 다음 업데이트된 모델을 질문에 답하는것과 같은 다운스트림 작업(Downstream Task)

3. 그리고 그 해당작업에서의 성과에 따라 보상 신호(0,1)가 결정된다.

4. 자체 편집으로 더 나은 성과가 도출되면 이를 생성한 policy는 긍정적인 보상을 받고 향후에도 좋은 피드백을 받는다. 반대의 경우는 부정적인 피드백을 받는다.

-> 위 과정은 task 성과를 극대화하기 위해서 self-edit을 생성하는 policy를 최적화하는 것이다.

중첩 루프(nested loop) 구조인 외부 루프는 내부 루프의 학습 과정을 최적화하는데 이 구조는 모델이 어떻게 학습해야 더 잘 적응하는가를 스스로 습득하는 메타러닝(meta-learning) 방식이다.

보상 신호

- 매우 단순한 이진 보상(정답이면 1, 아니면 0)만 사용.

- 복잡한 보상 설계 없이도 효과적으로 학습 전략을 발전시킴.

ReST-EM 알고리즘

- 로그가능도를 최대화, SEAL 알고리즘에서 내부 루프에서 self-edit후보를 여러 개 생성하여 각각 SFT로 파인튜닝(보상1, 아니면 0), 보상 1을 받은 self-edit(합성 데이터, 학습 전략 등)만 남기고, 이를 외부 루프의 policy 학습에 사용하여 강화학습 방식으로 업데이트하는 도구

(기존 GRPO, PPO 사용하였지만 불안정)

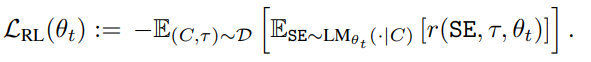

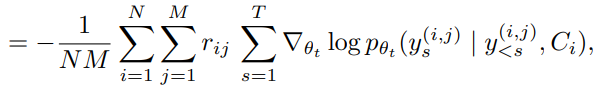

SEAL의 외부 루프(outer loop)에서 self-edit 생성 정책(policy)을 강화학습(RL)으로 최적화할 때 사용하는 목적 함수(손실 함수)

(C,τ)∼D: 데이터셋에서 context(문단 등)와 task 즉, QA 쌍을 샘플링

SE∼LMθt(⋅∣C): 현재 모델 파라미터로부터 context에 대해 self-edit(합성 데이터) 생성

r(SE,τ,θt): self-edit로 업데이트한 모델이 평가문제에서 정답 맞추면 1, 틀리면 0의 이진 보상

여러 컨텍스트(C)와 평가 쿼리(τ)를 샘플링해서,

모델이 self-edit(SE)을 만들고,

그 self-edit를 적용해서 평가 문제를 풀었을 때

정답을 맞추는(보상 r이 1인) 방향으로 모델 파라미터(θ)를 업데이트하는 방향성을 제시.

*딥러닝에서는 손실(Loss)을 최소화하는 방식으로 학습하므로,

보상 최대화를 손실 최소화로 바꿔주기 위해 음수 (-) 가 붙는다.

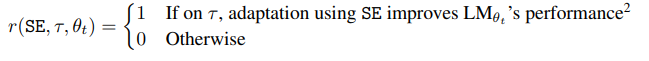

보상 함수 (Reward Function)

self-edit로 업데이트한 모델이 평가문제(τ)에서 정답을 맞췄는지(1) 틀렸는지(0)를 나타내는 이진 보상 함수

내부 루프에서 self-edit로 SFT(지도학습) 후, 외부 루프에서 이 보상값을 RL 정책 최적화에 사용

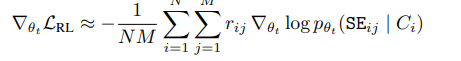

파라미터 업데이트 (policy 최적화)

N: context의 개수(미니배치 크기)

M: self-edit 샘플 개수

- 평가문제에서 정답 맞추면 1, 아니면 0 , 현재 모델 파라미터로 self-edit(혹은 각 토큰)을 생성할 확률, self-edit의 s번째 토큰

self-edit 생성의 실제 과정 (토큰 단위)

- 실제로 여러 context와 여러 self-edit을 샘플링하여, 평가 문제에서 정답을 맞춘 self-edit(보상이 1)만 gradient에 반영하고, 파라미터를 업데이트하는 방향으로 실제 self-edit별로 파라미터를 조정하여 업데이트한다.

- self-edit는 여러 단어(토큰)로 구성되어 있으므로,

- 각 self-edit의 모든 토큰 생성 과정까지 파라미터 업데이트에 반영한다.ex) "공부법(문장)을 한 단어씩 만들어갈 때, 정답을 맞춘 공부법의 모든 단어 생성 과정을 내 공부법에 더 잘 반영한다"

위 과정은 "효과가 입증된 자기 학습 전략만 강화"하는 SEAL의 핵심 메커니즘이다.

모델은 도메인에 따라 형태가 다른 self-edit(SE)를 생성하고 supervised fine-tuning을 통해 파라미터를 업데이트한다.

2.2 Domain Instantiations

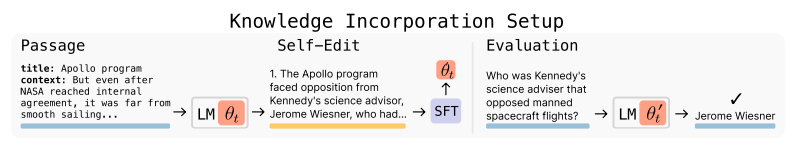

Seal이 새로운 데이터를 내면화하여 이후 해당 text를 보지 않고도 해당 text에 대한 질문에 답할 수 있도록 도울 수 있는지 확인하는 것.

-> 단순히 text를 미세조정 즉 fine tuning 한 것이 아닌 Seal은 앞서 언급한 RL 외부루프를 사용하여 해당 구절에서 파생된 합성데이터의 의미나 재구성을 학습하고 생성하는 훈련을 받음.

-> 원문을 다시 보지 않아도 해당 정보를 원문 없이 답을 맞출 수 있는 내재화

SFT(Supervised Fine-Tuning, 지도 미세조정)

- self-edit를 데이터로 삼아, 모델을 잠깐 미세조정.

- self-edit로 모델의 가중치를 임시로 업데이트하여, 새로운 정보를 실제로 내재화할 수 있게 만든다.

- 이 과정에서 전체 모델을 다시 학습하는 것이 아니라, self-edit로 빠르고 효율적으로 파라미터를 조정한다.

Single Passage - 한 번의 문단 삽입

Continued Pretraining - 여러 문단 연속 삽입

실험 및 결과

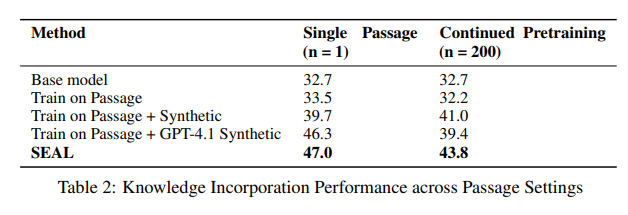

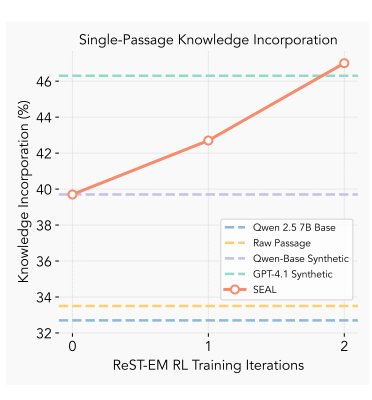

SEAL은 모델이 직접 생성한 합성(synthetic) 데이터로 미세조정을 수행한 결과, SQuAD의 no-passage-in-context (모델에 원래 원문을 제공하지 않았다는 의미) 버전에서, 강화학습 훈련 전 33.5%에서 RL 훈련 후 47.0%로 질문-응답 성능이 크게 향상됨.

이는, 훨씬 더 크고 성능이 뛰어난 GPT 4.1 모델에서 합성데이터를 미세 조정하여 얻은 성능(46.3%)보다 뛰어났다.

- Seal이 GPT4.1의 데이터를 능가하기 위해서는 불과 2번의 반복이 필요했다.

위에서 본 self-edit 생성 및 적용 과정을 2회 Iteration 하면서, 실제로 모델의 지식 내재화 성능(Knowledge Incorporation)이 어떻게 향상되는지 측정한 결과이다.

Few-Shot Learning

- 매우 적은 수의 데이터만을 사용하여 완전히 새로운 종류의 task에 적응하는 것과 관련이 있다.

- 최소한의 예시로부터 추상적인 시각적 추론 패턴을 포함하는 ARC 벤치마크를 사용했다.

- Abstraction and Reasoning Corpus (ARC)는 매우 제한된 예제를 통해 추상 추론과 일반화를 테스트하도록 설계된 벤치마크이다. 각 task에는 몇 가지 입출력 데모와 정확한 출력을 예측해야 하는 테스트 입력이 포함된다.

Seal이 본질적으로 자신의 적응 과정을 구성하는 법을 배웠다는 것. self-edit은 단순한 데이터가 아니고 모델에 어느 도구를 사용해야 하는지 알려주는 policy이다. 앞서 언급했듯 데이터 증강을 위한 이미지 rotation 혹은 학습률 조정 등과 같은 내부 루프 미세 조정을 위한 최적화 매개변수를 어떻게 설정해야 하는지 등의 policy가 있다.

실험 및 결과

Seal은 자신들이 사용한 ARC 하위 집합에서 72.5%의 성공률을 기록했다.

강화학습 최적화 루프 없이 비슷한 self-edit을 사용하려고 시도하면 20%만 얻을 수 있다는 점과 대조.

문맥 학습에서 표준은 0%, 인간이 설계한 최적 설정의 이론적인 Oralce점수인 100%에는 도달하지 못했지만,

강화 학습을 사용하지 않았을 때의 20%에서 사용했을 때 70% 이상으로의 향상은 이 모델의 효과적인 자율적 적응 전략을 의미한다.

3. Limitations

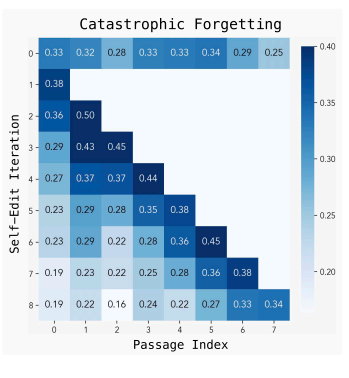

Catastrophic forgetting(치명적 망각)

- SEAL이 여러 번 self-edit 업데이트를 반복할수록, 이전에 학습한 정보에 대한 성능이 점점 저하되는 현상.

즉, 새로운 지식을 내재화할 때 과거에 배운 내용을 잊어버리는 “치명적 망각” 문제가 발생한다..

연속적으로 여러 지식을 통합할 때, 먼저 배운 초기지식이 점차 사라지는 현상을 실험적으로 확인.

Computational Overhead(계산 비용)

SEAL모델의 루프는 기존 LLM 강화학습 방식보다 훨씬 많은 계산 자원을 필요로 한다.

self-edit마다 전체 모델을 미세조정(finetuning)하고 평가까지 거쳐야 하므로, 한 번의 self-edit 평가에 30~45초가 소요된다.

이는 단순한 패턴 매칭이나 인간 피드백 기반 보상 방식에 비해 매우 비효율적이다.

Context-Dependent Evaluation(문맥 의존성)

SEAL은 현재 강화학습 시 평가에서 모든 context(입력)에 명시적인 QA 쌍이 반드시 짝지어져 있어야 한다.

이 구조는 보상 계산을 단순화하지만, 레이블이 없는 대규모 코퍼스(예: 위키피디아 전체, 뉴스 기사 등)에는 확장 적용이 어렵다는 한계.

미래에는 모델이 context만 보고 스스로 평가질문 생성 기대.