[2025-1] 박서형 - Learning Transferable Visual Models From Natural Language Supervision

https://arxiv.org/abs/2103.00020

Learning Transferable Visual Models From Natural Language Supervision

State-of-the-art computer vision systems are trained to predict a fixed set of predetermined object categories. This restricted form of supervision limits their generality and usability since additional labeled data is needed to specify any other visual co

arxiv.org

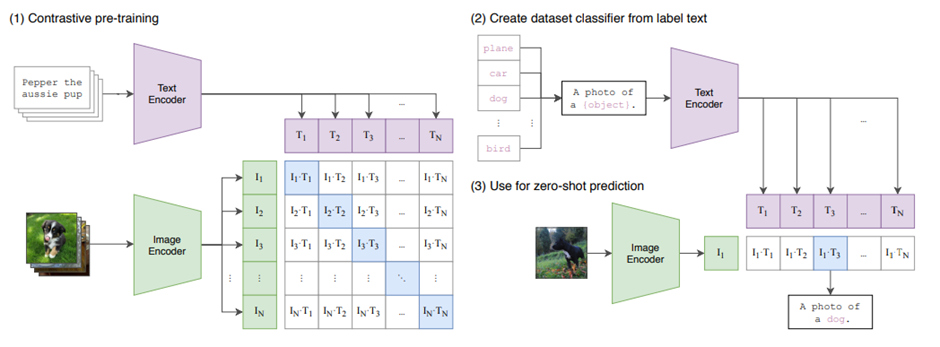

Clip은 기존의 비전 방식과 다르게 라벨과 이미지 쌍을 학습시키는 게 아니라 raw text와 이미지 쌍을 학습시켜 이미지로 텍스트를 찾거나 텍스트로 이미지를 찾는 등의 task를 잘 수행할 수 있게 한다. 이때 이미지는 비전 모델 (ex, ResNet, Vision Transformer) 등을 통해 임베딩 벡터로 변환하고 텍스트는 언어모델을 통해 독립적으로 임베딩 벡터로 변환시킨다. 이때 대조학습을 통해 같은 의미를 가진 이미지와 텍스트 사이의 코사인 유사도를 극대화하고 의미가 다르면 최소화하는 방향으로 학습을 진행한다. 이러면 이미지 분류,검색, 멀티모달 등 다양한 task에서 응용이 가능하고 zero-shot 학습을 통해 사전에 학습하지 않은 텍스트와 표현들을 처리할 수 있는 확장성과 유연성을 갖추게 된다.

1) Contrastive pre-training

Text는 text encoder를 통해 벡터로 표현하고 이미지는 image encoder를 통해 벡터 값으로 표현한다. 그리고 나서 텍스트 벡터와 이미지 벡터들 사이의 코사인 유사도를 구한다. 그리고 코사인 유사도를 이용해 cross entropy loss 계산하고 최적화를 진행한다.

이때 본 논문에서는 image encoder로 resnet-50과 vision transformer, text enocder로는 transformer를 사용했다.

2) Create dataset classifier from label text & 3) use for zero-shot prediction

미리 준비된 라벨들을 학습된 text encoder에 넣어 벡터로 변환하고 테스트 하고 싶은 이미지도 학습된 image encoder에 넣어 벡터로 변환시킨 후 코사인 유사도를 계산해 가장 높은 유사도를 가진 라벨을 선택하게 된다. 이러면 미리 학습하지 않은 라벨에 대해서도 예측이 가능한 zero-shot prediction이 가능해진다.

Clip 모델은 image encoder와 text encoder를 결합하여 zero-shot prediction을 수행하는 새로운 패러다임을 연 논문으로 큰 상징성을 가진 논문이다. 그러나 몇몇의 task에서는 부진한 성능을 보였다는 한계도 존재한다.